| 標題 | 表情符號 | 顏色 | 科洛特 | SDK | sdk_version | app_file | 固定 | 執照 | short_description |

|---|---|---|---|---|---|---|---|---|---|

AgentReview | ? | 靛青 | 粉色的 | Gradio | 5.4.0 | app.py | 錯誤的 | Apache-2.0 | EMNLP 2024 |

?

演示網站| ?紙| ?arxiv |代碼

@inproceedings { jin2024agentreview ,

title = { AgentReview: Exploring Peer Review Dynamics with LLM Agents } ,

author = { Jin, Yiqiao and Zhao, Qinlin and Wang, Yiyang and Chen, Hao and Zhu, Kaijie and Xiao, Yijia and Wang, Jindong } ,

booktitle = { EMNLP } ,

year = { 2024 }

}

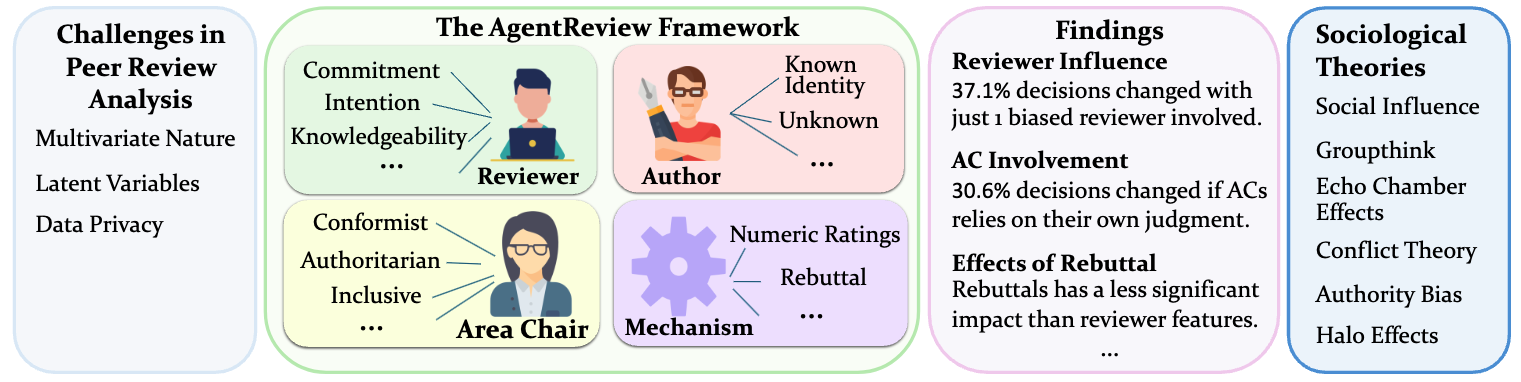

AgentReview是一個開創性的大語言模型(LLM)基於模擬同行審查過程的框架,開發了用於分析和解決影響審查結果的複雜多元因素。與傳統的統計方法不同,Agent Review捕獲了潛在變量,同時尊重敏感同行評審數據的隱私。

同行評審是科學出版物的完整性和進步的基礎。同行評審分析的傳統方法通常依賴於現有同行評審數據的探索和統計數據,這些數據無法充分解決該過程的多元性質,解釋了潛在變量,並且由於數據的敏感性而受到隱私問題的進一步限制。我們介紹了AgentReview,這是第一個基於同行的大語言模型(LLM)仿真框架,該框架有效地解開了多種潛在因素的影響並解決了隱私問題。我們的研究揭示了重要的見解,包括審稿人偏見引起的紙質決策的37.1%變化,並得到社會學理論(例如社會影響理論,利他主義疲勞和權威偏見)的支持。我們認為,這項研究可以提供有價值的見解,以改善同行評審機制的設計。

下載數據

在此Dropbox中下載兩個zip文件:

unzip AgentReview_paper_data.zip在data/中,其中包含:

unzip AgentReview_Paper_Data.zip -d data/ (可選)Unzip AgentReview_llm_reviews.zip在outputs/中包含LLM生成的評論(我們的LLM生成數據集)

unzip AgentReview_LLM_Review.zip -d outputs/安裝所需的軟件包:

cd AgentReview/

pip install -r requirements.txt

如果使用OpenAI API,請設置OpenAI_API_KEY。

export OPENAI_API_KEY=... # Format: sk-...如果使用Azureopenai API,請設置以下內容

export AZURE_ENDPOINT=... # Format: https://<your-endpoint>.openai.azure.com/

export AZURE_DEPLOYMENT=... # Your Azure OpenAI deployment here

export AZURE_OPENAI_KEY=... # Your Azure OpenAI key here運行項目

在run.sh中設置環境變量並運行:

bash run.sh注意:所有項目文件均應從AgentReview目錄運行。

演示

可以在notebooks/demo.ipynb中找到演示

您可以在agentreview/experiment_config.py中添加一個新設置,然後將設置作為新條目添加到all_settings dictionary:

all_settings = {

"BASELINE" : baseline_setting ,

"benign_Rx1" : benign_Rx1_setting ,

...

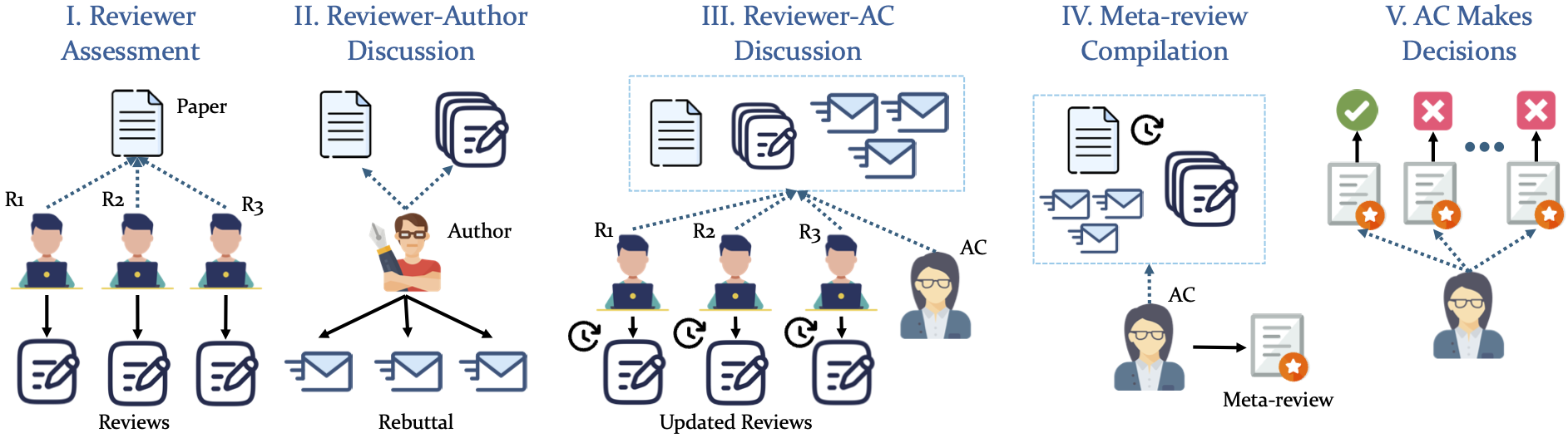

" your_setting_name ": your_setting 我們的模擬採用了結構化的5階段管道

該項目已根據APACHE-2.0許可獲得許可。

該實現部分基於Chatarena框架。