| Titel | Emoji | farblich | Colorto | SDK | sdk_version | app_file | festgesteckt | Lizenz | Short_description |

|---|---|---|---|---|---|---|---|---|---|

AgentReview | ? | Indigo | Rosa | Gradio | 5.4.0 | app.py | FALSCH | Apache-2.0 | EMNLP 2024 |

Offizielle Implementierung für das AMNLP 2024 Hauptspur (Mündliche) Papier - AgentReview: Erforschung der Peer Review -Dynamik mit LLM -Agenten

Demo | Website | ? Papier | Arxiv | Code

@inproceedings { jin2024agentreview ,

title = { AgentReview: Exploring Peer Review Dynamics with LLM Agents } ,

author = { Jin, Yiqiao and Zhao, Qinlin and Wang, Yiyang and Chen, Hao and Zhu, Kaijie and Xiao, Yijia and Wang, Jindong } ,

booktitle = { EMNLP } ,

year = { 2024 }

}

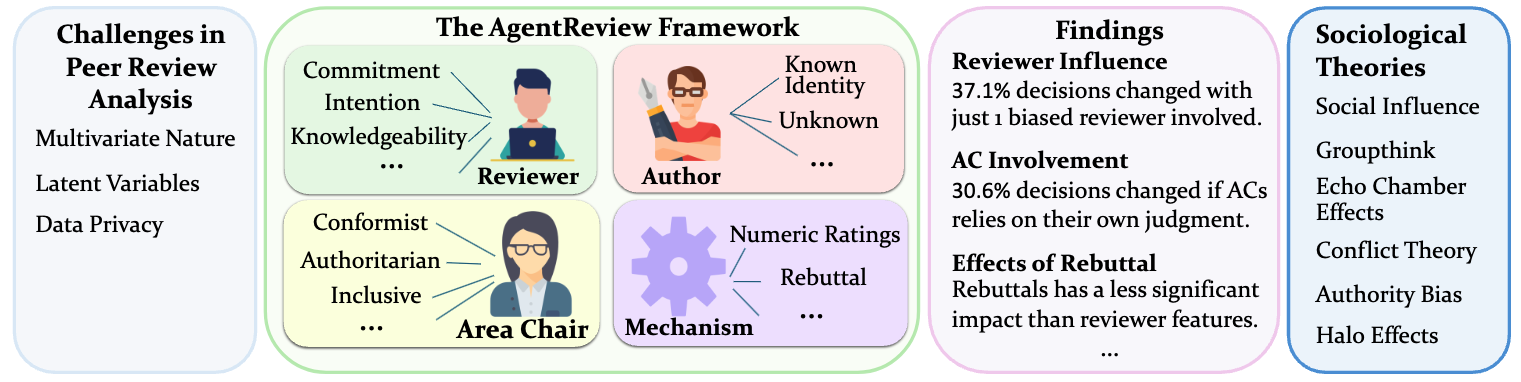

AgentReview ist ein Pionier-Rahmen für das Basis von LLM-Basis (LLM) für die Simulation von Peer-Review-Prozessen (entwickelt, um die komplexen, multivariaten Faktoren zur Beeinflussung der Überprüfungsergebnisse zu analysieren und anzugehen. Im Gegensatz zu herkömmlichen statistischen Methoden erfasst AgentReview latente Variablen und respektiert die Privatsphäre sensibler Peer -Review -Daten.

Peer Review ist grundlegend für die Integrität und Fortschritt der wissenschaftlichen Veröffentlichung. Traditionelle Methoden der Peer Review -Analysen beruhen häufig auf Exploration und Statistiken bestehender Peer -Review -Daten, die die multivariate Natur des Prozesses nicht angemessen behandeln, die latenten Variablen berücksichtigen und aufgrund der sensiblen Natur der Daten durch Datenschutzbedenken weiter eingeschränkt werden. Wir stellen AgentReview vor, das erste großartigen Rahmen des Peer Review -Simulations -Frameworks (LLM), das die Auswirkungen mehrerer latenter Faktoren effektiv entwirrt und das Problem der Privatsphäre befasst. Unsere Studie zeigt signifikante Erkenntnisse, einschließlich einer bemerkenswerten Variation von 37,1% der Papierentscheidungen aufgrund von Überprüfungsvorurteilen, die durch soziologische Theorien wie die Theorie des sozialen Einflusses, Altruismus -Müdigkeit und Autoritätsverzerrung unterstützt werden. Wir glauben, dass diese Studie wertvolle Erkenntnisse zur Verbesserung des Designs von Peer Review -Mechanismen bieten könnte.

Laden Sie die Daten herunter

Laden Sie beide Zip -Dateien in dieser Dropbox herunter:

Unzip agentReview_paper_data.zip unter data/ , das enthält:

unzip AgentReview_Paper_Data.zip -d data/ (Optional) Unzip AgentReview_LLM_Reviews.zip unter outputs/ , die die von LLM erstellten Bewertungen enthält (unser LLM-generierter Datensatz)

unzip AgentReview_LLM_Review.zip -d outputs/Installieren Sie die erforderlichen Pakete :

cd AgentReview/

pip install -r requirements.txt

Wenn Sie OpenAI -API verwenden, setzen Sie OpenAI_API_KEY.

export OPENAI_API_KEY=... # Format: sk-...Wenn Sie die Azureopenai -API verwenden, stellen Sie Folgendes fest

export AZURE_ENDPOINT=... # Format: https://<your-endpoint>.openai.azure.com/

export AZURE_DEPLOYMENT=... # Your Azure OpenAI deployment here

export AZURE_OPENAI_KEY=... # Your Azure OpenAI key hereDas Projekt ausführen

Legen Sie die Umgebungsvariablen in run.sh ein und rennen Sie sie:

bash run.sh Hinweis: Alle Projektdateien sollten aus dem AgentReview -Verzeichnis ausgeführt werden.

Demo

Eine Demo finden Sie in notebooks/demo.ipynb

Sie können eine neue Einstellung in agentreview/experiment_config.py hinzufügen und dann die Einstellung als neue Eintrag zum all_settings -Wörterbuch hinzufügen:

all_settings = {

"BASELINE" : baseline_setting ,

"benign_Rx1" : benign_Rx1_setting ,

...

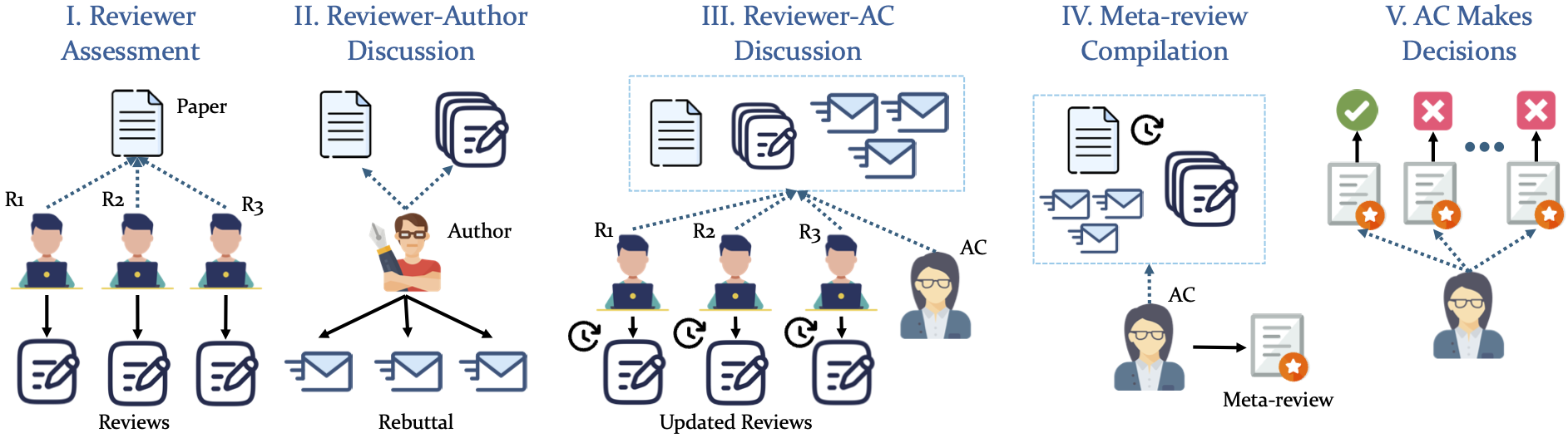

" your_setting_name ": your_setting Unsere Simulation nimmt eine strukturierte 5-Phasen-Pipeline an

Dieses Projekt ist unter der Lizenz Apache-2.0 lizenziert.

Die Implementierung basiert teilweise auf dem Chatarena -Framework.