| título | emoji | color de color | colorto | sdk | sdk_version | app_file | cubierto | licencia | short_description |

|---|---|---|---|---|---|---|---|---|---|

Revisión de agentes | ? | índigo | rosa | Gradio | 5.4.0 | app.py | FALSO | apache-2.0 | EMNLP 2024 |

Implementación oficial para el documento? EMNLP 2024 PRINCIPAL (ORAL) - AGENTERVIEW: Explorando la dinámica de revisión por pares con agentes LLM

Demo | Sitio web | ? Papel | ? ARXIV | Código

@inproceedings { jin2024agentreview ,

title = { AgentReview: Exploring Peer Review Dynamics with LLM Agents } ,

author = { Jin, Yiqiao and Zhao, Qinlin and Wang, Yiyang and Chen, Hao and Zhu, Kaijie and Xiao, Yijia and Wang, Jindong } ,

booktitle = { EMNLP } ,

year = { 2024 }

}

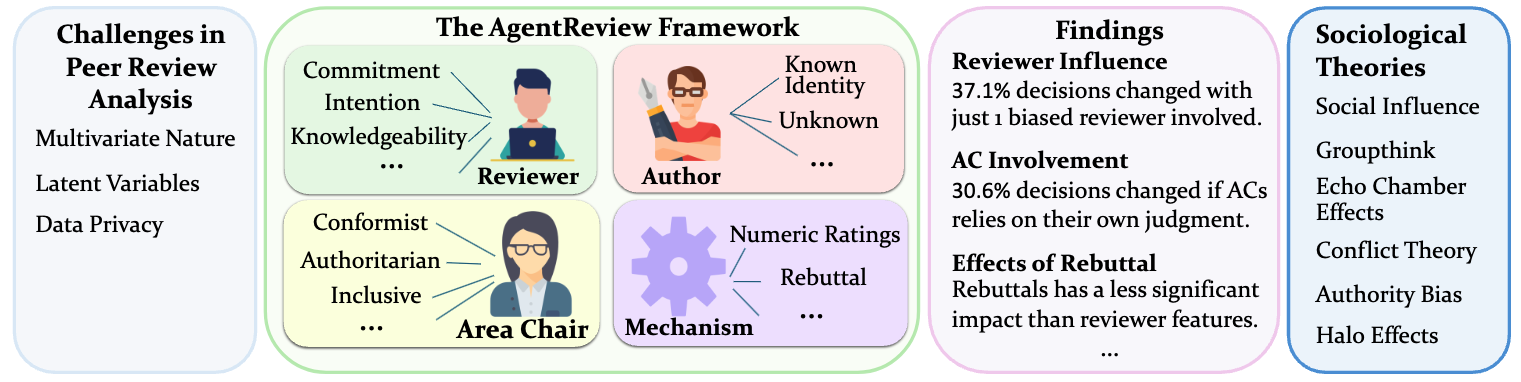

AgentReview es un marco basado en el modelo de lenguaje grande (LLM) pionero para simular los procesos de revisión por pares, desarrollado para analizar y abordar los factores complejos y multivariados que influyen en los resultados de la revisión. A diferencia de los métodos estadísticos tradicionales, AgentReview captura variables latentes al tiempo que respeta la privacidad de los datos confidenciales de revisión por pares.

La revisión por pares es fundamental para la integridad y el avance de la publicación científica. Los métodos tradicionales de revisión por pares los análisis a menudo se basan en la exploración y las estadísticas de los datos de revisión por pares existentes, que no abordan adecuadamente la naturaleza multivariada del proceso, representan las variables latentes y están más limitados por las preocupaciones de privacidad debido a la naturaleza sensible de los datos. Introducimos a AgentReview, el primer marco de simulación de revisión por pares del modelo de lenguaje grande (LLM), que efectivamente desenreda los impactos de múltiples factores latentes y aborda el problema de la privacidad. Nuestro estudio revela ideas significativas, incluida una notable variación del 37.1% en las decisiones en papel debido a los sesgos de los revisores, respaldados por teorías sociológicas como la teoría de la influencia social, la fatiga del altruismo y el sesgo de autoridad. Creemos que este estudio podría ofrecer información valiosa para mejorar el diseño de mecanismos de revisión por pares.

Descargar los datos

Descargue ambos archivos zip en este dropbox:

Unzip AgentReview_paper_data.zip en data/ , que contiene:

unzip AgentReview_Paper_Data.zip -d data/ (Opcional) Unzip AgentReview_llm_reviews.zip en outputs/ , que contiene las revisiones generadas por LLM (nuestro conjunto de datos generado por LLM)

unzip AgentReview_LLM_Review.zip -d outputs/Instalar paquetes requeridos :

cd AgentReview/

pip install -r requirements.txt

Si usa API de OpenAI, establezca OpenAI_API_KEY.

export OPENAI_API_KEY=... # Format: sk-...Si usa la API de AzureOpenai, establezca lo siguiente

export AZURE_ENDPOINT=... # Format: https://<your-endpoint>.openai.azure.com/

export AZURE_DEPLOYMENT=... # Your Azure OpenAI deployment here

export AZURE_OPENAI_KEY=... # Your Azure OpenAI key hereEjecutando el proyecto

Establezca las variables de entorno en run.sh y ejecutarlo:

bash run.sh Nota: Todos los archivos del proyecto deben ejecutarse desde el directorio AgentReview .

Manifestación

Se puede encontrar una demostración en notebooks/demo.ipynb

Puede agregar una nueva configuración en agentreview/experiment_config.py , luego agregar la configuración como una nueva entrada al diccionario all_settings :

all_settings = {

"BASELINE" : baseline_setting ,

"benign_Rx1" : benign_Rx1_setting ,

...

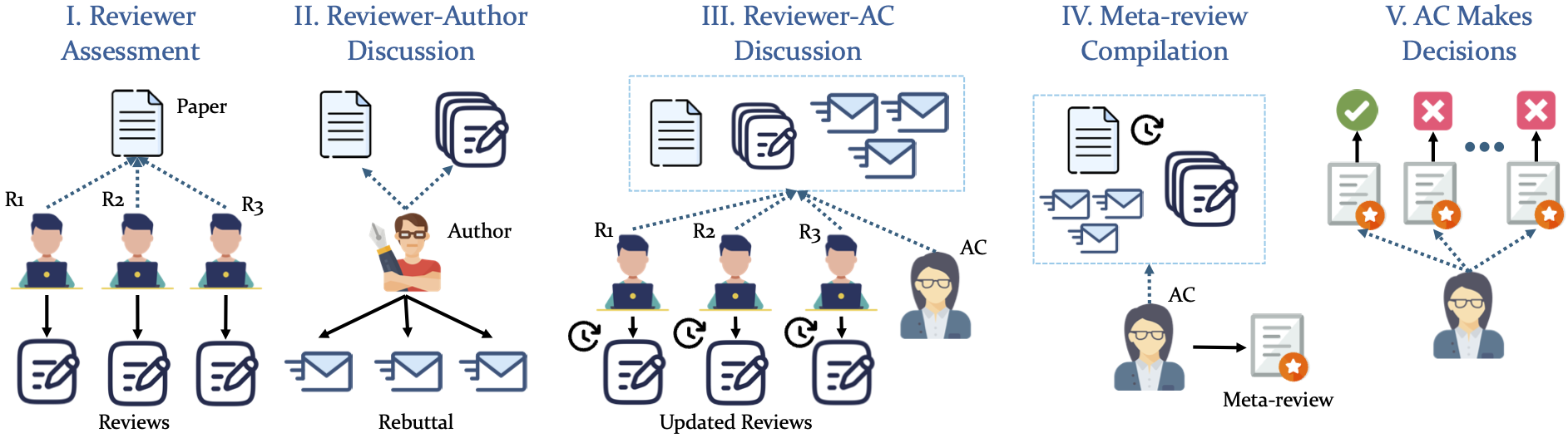

" your_setting_name ": your_setting Nuestra simulación adopta una tubería estructurada de 5 fases

Este proyecto tiene licencia bajo la licencia Apache-2.0.

La implementación se basa parcialmente en el marco de Chatarena.