搜索引擎是旨在进行Web搜索的软件系统。他们以系统的方式搜索万维网,以在文本Web搜索查询中指定的特定信息。搜索结果通常以一系列结果表示,通常称为搜索引擎结果页面(SERP),信息可能是指向网页,图像,视频,信息图表,文章,研究论文和其他类型文件的链接的混合。一些搜索引擎还挖掘了数据库或打开目录中可用的数据。与仅由人类编辑维护的Web目录不同,搜索引擎还通过在Web爬网上运行算法来维护实时信息。无法通过网络搜索引擎搜索的互联网内容通常描述为深网。

搜索引擎几乎实时维护以下过程:

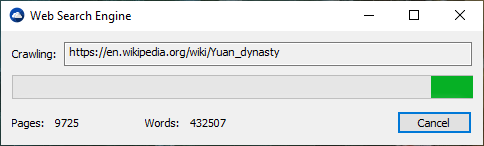

Web搜索引擎通过网站爬行到网站的网络获取信息。 “蜘蛛”检查标准文件名robots.txt,已解决。 robots.txt文件包含搜索蜘蛛的指令,告诉它要爬网以及哪些页面不爬网。在检查了robots.txt并找到或不找到它后,蜘蛛将某些信息发送回索引,具体取决于许多因素,例如标题,页面内容,JavaScript,级联样式表(CSS),标题或其元数据在HTML Meta标签中。在一定数量的页面爬行,索引数量或在网站上花费的时间后,蜘蛛停止爬行并继续前进。 “ [n] o网络爬行者实际上可能会爬上整个可触及的网络。由于无限的网站,蜘蛛陷阱,垃圾邮件和真实网络的其他紧急情况,爬行者会应用爬网策略来确定网站的爬网何时应充分爬行。有些网站被详尽地爬行,而其他网站则被爬行,而仅部分爬行”。

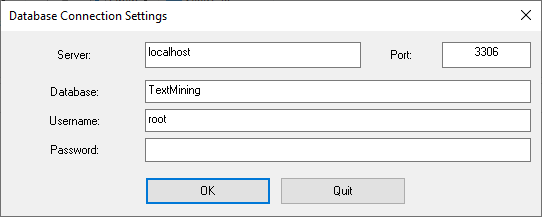

索引意味着将网页上的单词和其他可定义的令牌关联到其域名和基于HTML的字段。关联是在公共数据库中进行的,可用于Web搜索查询。用户的查询可以是一个单词,多个单词或句子。该索引有助于尽快找到与查询有关的信息。索引和缓存的一些技术是商业秘密,而网络爬行是系统地访问所有站点的直接过程。

在蜘蛛的访问之间,该页面的缓存版本(渲染所需的某些或所有内容)存储在搜索引擎工作记忆中,很快将发送给询问者。如果访问逾期,则搜索引擎可以作为Web代理。在这种情况下,页面可能与索引的搜索词不同。缓存页面具有以前索引单词的版本的外观,因此,当实际页面丢失时,页面的缓存版本对网站可能很有用,但是此问题也被认为是链接的温和形式。

通常,当用户将查询输入搜索引擎时,这是一些关键字。该索引已经具有包含关键字的站点的名称,并且这些站点是从索引中立即获得的。真正的处理负载是生成搜索结果列表的网页:整个列表中的每个页面都必须根据索引中的信息加权。然后,顶部搜索结果项目需要摘要的查找,重建和标记,以显示匹配的关键字的上下文。这些只是处理每个搜索结果页面所需的处理的一部分,而更多页面(顶部旁边)需要更多此后处理。

除了简单的关键字查找之外,搜索引擎还提供了自己的GUI或命令驱动的操作员和搜索参数,以完善搜索结果。这些用户为从第一个搜索结果的初始页面进行过滤和加权时,为参与反馈循环用户创建的反馈循环用户创建的用户提供了必要的控件。例如,从2007年开始,Google.com搜索引擎可以通过单击初始搜索结果页面的最左边列中的“显示搜索工具”来按日期过滤,然后选择所需的日期范围。也可以按日期进行权重,因为每个页面都有一个修改时间。大多数搜索引擎都支持使用布尔运营商的使用,或者不帮助最终用户完善搜索查询。布尔运算符用于字面搜索,使用户可以完善并扩展搜索条款。该引擎完全按照输入的方式查找单词或短语。一些搜索引擎提供了一个称为接近搜索的高级功能,该功能允许用户定义关键字之间的距离。还有基于概念的搜索研究涉及在包含您搜索的单词或短语的页面上使用统计分析。

搜索引擎的有用性取决于结果集的相关性。尽管可能有数百万个网页包括特定单词或短语,但某些页面可能比其他页面更相关,受欢迎或权威。大多数搜索引擎采用方法来对结果进行排名,以提供“最佳”结果。搜索引擎如何决定哪些页面是最佳匹配,以及结果应显示的顺序,从一个引擎到另一个引擎差异很大。随着互联网使用的变化和新技术的发展,这些方法也随着时间的推移而变化。搜索引擎有两种主要类型:一个是人类广泛编程的预定义和分层关键字的系统。另一个是通过分析其定位的文本来生成“倒置索引”的系统。第一种形式更加依赖计算机本身来完成大部分工作。

大多数网络搜索引擎是广告收入支持的商业企业,因此其中一些允许广告客户的列表在搜索结果中的排名更高。通过运行与常规搜索引擎结果一起运行搜索相关的广告来赚钱的搜索引擎可赚钱。每当有人点击这些广告之一时,搜索引擎都会赚钱。

。

。