Um mecanismo de pesquisa é um sistema de software projetado para realizar pesquisas na Web. Eles pesquisam na World Wide Web de maneira sistemática por informações específicas especificadas em uma consulta de pesquisa na web textual. Os resultados da pesquisa são geralmente apresentados em uma linha de resultados, geralmente chamados de Páginas de Resultados do Mecanismo de Pesquisa (SERPs), as informações podem ser uma mistura de links para páginas da Web, imagens, vídeos, infográficos, artigos, trabalhos de pesquisa e outros tipos de arquivos. Alguns mecanismos de pesquisa também minam dados disponíveis em bancos de dados ou diretórios abertos. Ao contrário dos diretórios da Web, que são mantidos apenas pelos editores humanos, os mecanismos de pesquisa também mantêm informações em tempo real, executando um algoritmo em um rastreador da web. O conteúdo da Internet que não é capaz de ser pesquisado por um mecanismo de pesquisa na Web é geralmente descrito como a Web Deep.

Um mecanismo de pesquisa mantém os seguintes processos em tempo quase real:

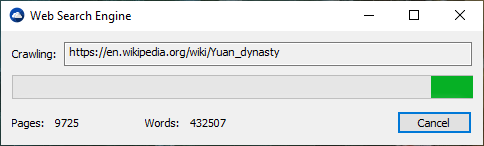

Os mecanismos de pesquisa da web obtêm suas informações rastejando da Web de site para site. A verificação do "Spider" para o nome do arquivo robots.txt padrão, endereçado a ele. O arquivo robots.txt contém diretrizes para aranhas de pesquisa, informando quais páginas rastejam e quais páginas para não rastejar. Depois de verificar o robots.txt e encontrá -lo ou não, a aranha envia certas informações de volta para serem indexadas, dependendo de muitos fatores, como títulos, conteúdo da página, javascript, folhas de estilo em cascata (CSS), títulos ou seus metadados em metatags HTML. Após um certo número de páginas rastejadas, quantidade de dados indexados ou tempo gasto no site, a aranha para de rastejar e segue em frente. "[N] o rastreador da web pode realmente engatinhar toda a web acessível. Devido a sites infinitos, armadilhas de aranha, spam e outras exigências da web real, os rastreadores aplicam uma política de rastreamento para determinar quando o rastreamento de um site deve ser considerado suficiente. Alguns sites estão se arrastando exaustivamente, enquanto outros são rabugentos apenas parcialmente".

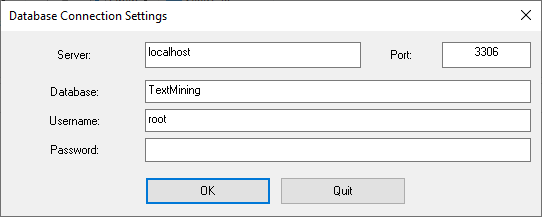

A indexação significa associar palavras e outros tokens definíveis encontrados nas páginas da web em seus nomes de domínio e campos baseados em HTML. As associações são feitas em um banco de dados público, disponibilizado para consultas de pesquisa na web. Uma consulta de um usuário pode ser uma única palavra, várias palavras ou uma frase. O índice ajuda a encontrar informações relacionadas à consulta o mais rápido possível. Algumas das técnicas para indexação e cache são segredos comerciais, enquanto o rastreamento da web é um processo direto de visitar todos os sites sistemáticos.

Entre as visitas da aranha, a versão em cache da página (alguns ou todo o conteúdo necessária para renderizá -la) armazenada no mecanismo de pesquisa a memória de trabalho é rapidamente enviada a um inquérito. Se uma visita estiver atrasada, o mecanismo de pesquisa poderá simplesmente atuar como um proxy da web. Nesse caso, a página pode diferir dos termos de pesquisa indexados. A página em cache mantém a aparência da versão cujas palavras foram indexadas anteriormente; portanto, uma versão em cache de uma página pode ser útil para o site quando a página real for perdida, mas esse problema também é considerado uma forma leve de linkrot.

Normalmente, quando um usuário insere uma consulta em um mecanismo de pesquisa, são algumas palavras -chave. O índice já possui os nomes dos sites que contêm as palavras -chave, e estes são obtidos instantaneamente no índice. A carga real de processamento está na geração das páginas da Web que são a lista de resultados de pesquisa: cada página de toda a lista deve ser ponderada de acordo com as informações nos índices. Em seguida, o item de resultado da pesquisa superior requer a pesquisa, a reconstrução e a marcação dos trechos mostrando o contexto das palavras -chave correspondidas. Isso é apenas parte do processamento de que cada página dos resultados da pesquisa requer e mais páginas (ao lado da parte superior) exigem mais deste pós-processamento.

Além das pesquisas simples de palavras-chave, os mecanismos de pesquisa oferecem seus próprios operadores orientados para GUI- ou comandos e parâmetros de pesquisa para refinar os resultados da pesquisa. Eles fornecem os controles necessários para o usuário envolvido nos usuários do Loop de feedback, filtrando e ponderação ao refinar os resultados da pesquisa, dadas as páginas iniciais dos resultados da primeira pesquisa. Por exemplo, a partir de 2007, o mecanismo de pesquisa do Google.com permitiu filtrar por data clicando em "Mostrar ferramentas de pesquisa" na coluna mais à esquerda da página de resultados de pesquisa inicial e selecionando o intervalo de data desejado. Também é possível ponderar por data, porque cada página tem um tempo de modificação. A maioria dos mecanismos de pesquisa suporta o uso dos operadores booleanos e, ou e não para ajudar os usuários finais a refinar a consulta de pesquisa. Os operadores booleanos são para pesquisas literais que permitem ao usuário refinar e ampliar os termos da pesquisa. O motor procura as palavras ou frases exatamente como inseridas. Alguns mecanismos de pesquisa fornecem um recurso avançado chamado Pesquisa de Proximidade, que permite aos usuários definir a distância entre as palavras -chave. Há também pesquisa baseada em conceito, onde a pesquisa envolve o uso de análises estatísticas em páginas que contêm as palavras ou frases que você procura.

A utilidade de um mecanismo de pesquisa depende da relevância do conjunto de resultados que ele retribui. Embora possa haver milhões de páginas da Web que incluam uma palavra ou frase específica, algumas páginas podem ser mais relevantes, populares ou autoritárias do que outras. A maioria dos mecanismos de pesquisa emprega métodos para classificar os resultados para fornecer os "melhores" resultados primeiro. Como um mecanismo de pesquisa decide quais páginas são as melhores correspondências e em que ordem os resultados devem ser mostrados, varia amplamente de um motor para outro. Os métodos também mudam ao longo do tempo à medida que o uso da Internet muda e as novas técnicas evoluem. Existem dois tipos principais de mecanismo de pesquisa que evoluíram: um é um sistema de palavras -chave predefinidas e ordenadas hierarquicamente que os humanos programaram extensivamente. O outro é um sistema que gera um "índice invertido" analisando textos que ele localiza. Essa primeira forma depende muito mais do próprio computador para fazer a maior parte do trabalho.

A maioria dos mecanismos de pesquisa da Web são empreendimentos comerciais suportados pela receita de publicidade e, portanto, alguns deles permitem que os anunciantes tenham suas listagens mais altas nos resultados de pesquisa por uma taxa. Os mecanismos de pesquisa que não aceitam dinheiro para seus resultados de pesquisa ganham dinheiro executando anúncios relacionados à pesquisa, juntamente com os resultados regulares dos mecanismos de pesquisa. Os mecanismos de pesquisa ganham dinheiro toda vez que alguém clica em um desses anúncios.

.

.