Un moteur de recherche est un système logiciel conçu pour effectuer des recherches Web. Ils recherchent le World Wide Web de manière systématique pour des informations particulières spécifiées dans une requête de recherche Web textuelle. Les résultats de recherche sont généralement présentés dans une ligne de résultats, souvent appelés pages de résultats de moteur de recherche (SERP), les informations peuvent être un mélange de liens vers des pages Web, des images, des vidéos, des infographies, des articles, des articles de recherche et d'autres types de fichiers. Certains moteurs de recherche exploitent également les données disponibles dans les bases de données ou les répertoires ouverts. Contrairement aux répertoires Web, qui ne sont maintenus que par des éditeurs humains, les moteurs de recherche conservent également des informations en temps réel en exécutant un algorithme sur un robot Web. Le contenu Internet qui n'est pas capable d'être recherché par un moteur de recherche Web est généralement décrit comme le Web Deep.

Un moteur de recherche maintient les processus suivants en temps quasi réel:

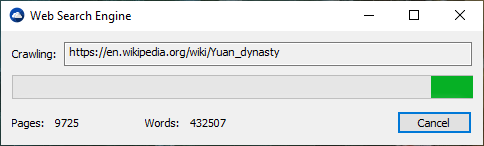

Les moteurs de recherche Web obtiennent leurs informations en rampant Web d'un site à l'autre. Le "Spider" vérifie le nom de fichier standard Robots.txt, adressé à lui. Le fichier robots.txt contient des directives pour les araignées de recherche, lui indiquant quelles pages à ramper et quelles pages ne pas ramper. Après avoir vérifié les robots.txt et le trouver ou non, l'araignée renvoie certaines informations pour être indexées en fonction de nombreux facteurs, tels que les titres, le contenu de la page, JavaScript, les feuilles de style en cascade (CSS), les en-têtes ou ses métadonnées dans des balises HTML Meta. Après qu'un certain nombre de pages aient rampé, la quantité de données indexées ou le temps passé sur le site Web, l'araignée cesse de ramper et de passer. "[N] O Crawler Web peut en fait explorer la web accessible entier. En raison de sites Web infinis, de pièges à araignée, de spam et d'autres exigences du vrai Web, les Crawlers appliquent plutôt une politique de rampe pour déterminer quand la rampe d'un site ne devrait être considérée que partiellement.

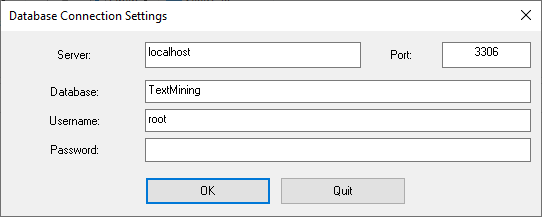

L'indexation signifie associer des mots et d'autres jetons définissables trouvés sur les pages Web vers leurs noms de domaine et leurs champs basés sur HTML. Les associations sont faites dans une base de données publique, mise à disposition pour les requêtes de recherche Web. Une requête d'un utilisateur peut être un seul mot, plusieurs mots ou une phrase. L'index aide à trouver des informations relatives à la requête le plus rapidement possible. Certaines des techniques d'indexation et de mise en cache sont des secrets commerciaux, tandis que le compromis Web est un processus simple de visiter tous les sites sur une base systématique.

Entre les visites de The Spider, la version mise en cache de la page (certains ou tout le contenu nécessaire pour le rendre) stocké dans la mémoire de travail du moteur de recherche est rapidement envoyé à un enquêteur. Si une visite est en retard, le moteur de recherche peut simplement agir comme un proxy Web à la place. Dans ce cas, la page peut différer des termes de recherche indexés. La page en cache contient l'apparition de la version dont les mots étaient précédemment indexés, donc une version mise en cache d'une page peut être utile au site Web lorsque la page réelle a été perdue, mais ce problème est également considéré comme une forme légère de linkrot.

En règle générale, lorsqu'un utilisateur entre dans une requête dans un moteur de recherche, il s'agit de quelques mots clés. L'index a déjà les noms des sites contenant les mots clés, et ceux-ci sont instantanément obtenus à partir de l'index. La charge de traitement réelle consiste à générer les pages Web qui sont la liste des résultats de recherche: chaque page de la liste entière doit être pondérée en fonction des informations des index. Ensuite, l'élément de résultat de recherche supérieur nécessite la recherche, la reconstruction et la majoration des extraits montrant le contexte des mots clés correspondant. Ce ne sont qu'une partie du traitement que la page Web des résultats de recherche nécessite, et d'autres pages (à côté du haut) nécessitent davantage de ce post-traitement.

Au-delà des recherches de mots clés simples, les moteurs de recherche offrent leurs propres opérateurs et paramètres de recherche axés sur la GUY ou les commandes pour affiner les résultats de recherche. Ceux-ci fournissent les contrôles nécessaires pour l'utilisateur engagé dans la boucle de rétroaction que les utilisateurs des utilisateurs sont créés en filtrant et en pondérant lors de la raffinement des résultats de recherche, compte tenu des pages initiales des premiers résultats de recherche. Par exemple, à partir de 2007, le moteur de recherche Google.com a permis de filtrer par date en cliquant sur "Afficher les outils de recherche" dans la colonne la plus à gauche de la page de résultats de recherche initiale, puis en sélectionnant la plage de dates souhaitée. Il est également possible de peser par date car chaque page a un temps de modification. La plupart des moteurs de recherche prennent en charge l'utilisation des opérateurs booléens et, ou et non pour aider les utilisateurs finaux à affiner la requête de recherche. Les opérateurs booléens sont destinés à des recherches littérales qui permettent à l'utilisateur d'affiner et d'étendre les termes de la recherche. Le moteur recherche les mots ou les phrases exactement comme entré. Certains moteurs de recherche fournissent une fonctionnalité avancée appelée recherche de proximité, qui permet aux utilisateurs de définir la distance entre les mots clés. Il existe également une recherche basée sur le concept où la recherche implique d'utiliser une analyse statistique sur des pages contenant les mots ou les phrases que vous recherchez.

L'utilité d'un moteur de recherche dépend de la pertinence de l'ensemble des résultats qu'il rend. Bien qu'il puisse y avoir des millions de pages Web qui incluent un mot ou une phrase en particulier, certaines pages peuvent être plus pertinentes, populaires ou autoritaires que d'autres. La plupart des moteurs de recherche utilisent des méthodes pour classer les résultats pour fournir d'abord les «meilleurs» résultats. Comment un moteur de recherche décide quelles pages sont les meilleures correspondances et dans quel ordre les résultats doivent être affichés, varie considérablement d'un moteur à l'autre. Les méthodes changent également au fil du temps à mesure que les changements d'utilisation d'Internet et les nouvelles techniques évoluent. Il existe deux principaux types de moteurs de recherche qui ont évolué: l'un est un système de mots clés prédéfinis et hiérarchiquement ordonnés que les humains ont largement programmé. L'autre est un système qui génère un "index inversé" en analysant les textes qu'il localise. Cette première forme repose beaucoup plus sur l'ordinateur lui-même pour faire la majeure partie de l'œuvre.

La plupart des moteurs de recherche Web sont des entreprises commerciales soutenues par des revenus publicitaires et donc certains d'entre eux permettent aux annonceurs de faire classer leurs listes plus élevées dans les résultats de recherche moyennant des frais. Les moteurs de recherche qui n'acceptent pas d'argent pour leurs résultats de recherche font de l'argent en exécutant des annonces liées à la recherche aux côtés des résultats réguliers du moteur de recherche. Les moteurs de recherche gagnent de l'argent chaque fois que quelqu'un clique sur l'une de ces annonces.

.

.