trol:大语言和视觉模型的层遍历[arxiv]

trol:大语言和视觉模型的层遍历[arxiv]

多亏了HuggingFace员工,我们可以为每个用户使用免费的Zerogpu(NVIDIA A100),但是查询有限,因此,如果粘住了推论,请等待几分钟。 (本地演示速度比这个在线GPU领域要快得多。)

huggingface模型现在可以使用trol-1.8b。 (包括本地演示读数)

现在,huggingface模型可用trol-3.8b。 (包括本地演示读数)

现在,huggingface型号可用trol-7b。 (包括本地演示读数)

在网上trol演示现在可以在“拥抱面”空间中使用。 (您可以选择型号大小)

官方的Pytorch实施代码,用于实现图层遍历(TROL)的技术部分,以改善具有高效模型大小的众多视觉性能。此代码是从头开始开发的。因此,与具有相对复杂结构的代码相比,我一直在尝试提高代码的可读性和简单性。

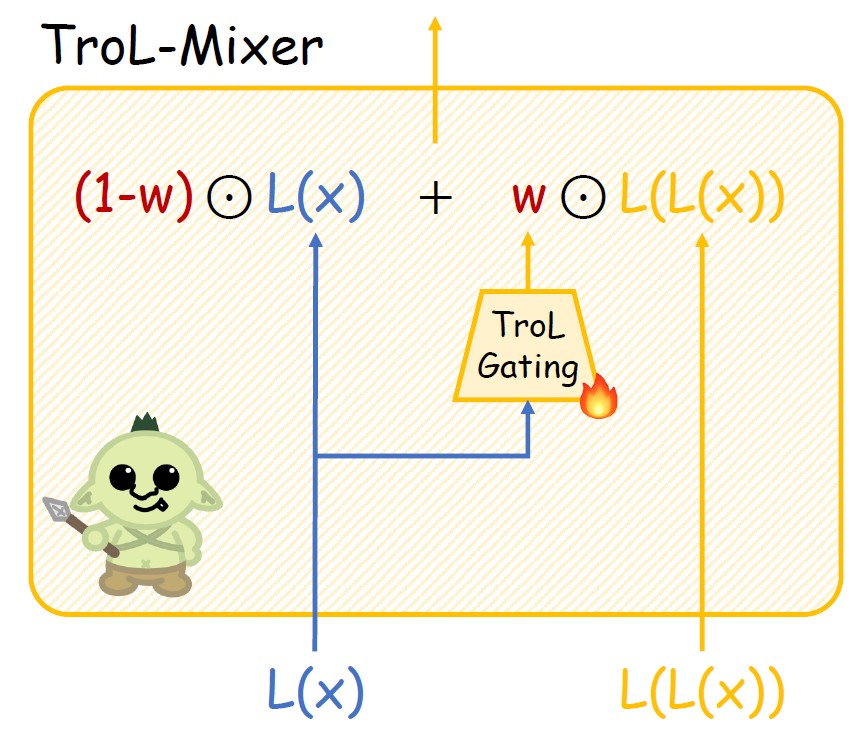

图1。TROL层。新的传播。

图2。托尔混合物的结构。

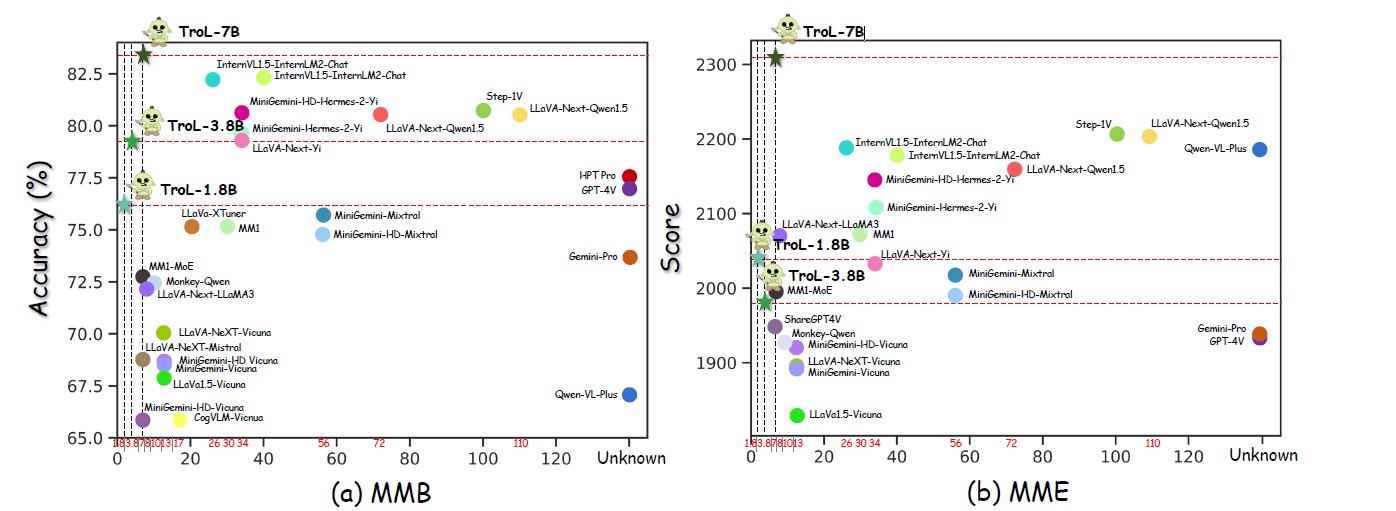

图3。跨多个模型大小的性能。

图4。与封闭源LLVM的比较。

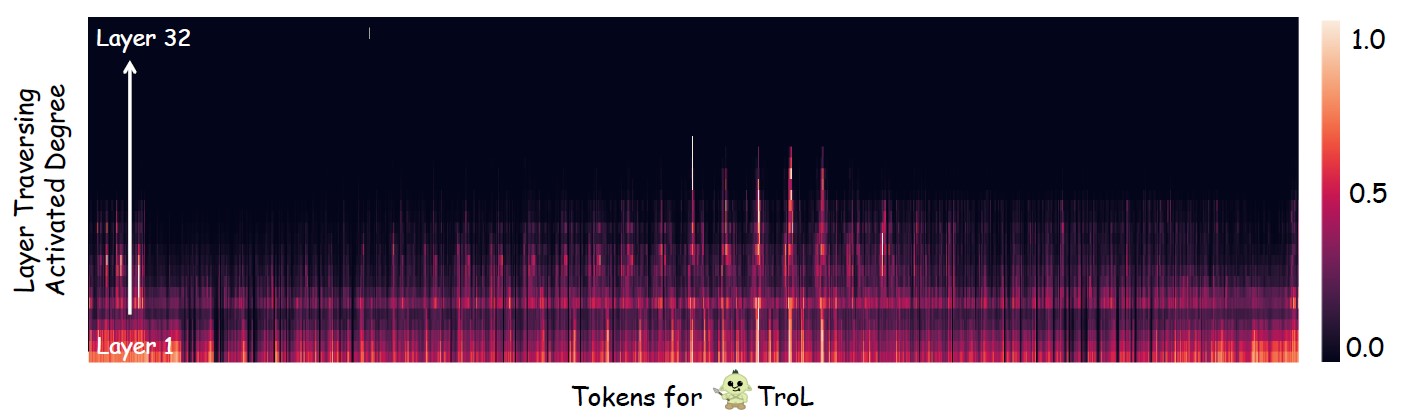

图5。调查层横穿(重复使用层)的位置主要发生。

具有标准型号的开源LLVM

| llvms | sqa-img | 教皇 | 妈妈 | MMB | Mathvista | 种子img | MM-VET | llava-w |

|---|---|---|---|---|---|---|---|---|

| YI-VL-6B | 71.7 | 82.5 | 1915年 | 64.2 | 29.7 | 67.5 | 32.1 | 51.9 |

| llava-next-7b | 70.1 | 86.5 | 1851年 | 69.6 | 34.6 | 70.2 | 43.9 | 72.3 |

| MM1-7B | 72.6 | 86.6 | 1858年 | 72.3 | 35.9 | 70.9 | 42.1 | - |

| TROL-1.8B | 87.5 | 88.6 | 2038 | 76.1 | 45.4 | 69.0 | 45.1 | 69.7 |

| TROL-3.8B | 90.8 | 86.5 | 1980 | 79.2 | 55.1 | 70.5 | 51.1 | 76.6 |

| 小手手-7B | 92.8 | 87.8 | 2308 | 51.8 | 75.3 | 54.7 | 92.8 | 87.1 |

具有较大型号的开源LLVM

| llvms | AI2D | Chartqa | 妈妈 | MMB | Mathvista | MM-VET | llava-w |

|---|---|---|---|---|---|---|---|

| internvl1.5-40b | 79.0 | 68.0 | 2175 | 82.2 | 47.7 | 48.9 | - |

| Internvl1.5-26b | 80.7 | 83.8 | 2188 | 82.2 | 53.5 | 62.8 | - |

| MM1-30B | - | - | 2069 | 75.1 | 39.4 | 48.7 | - |

| Minigemini-34b | - | - | 2105 | 79.6 | 38.9 | 53.0 | - |

| Minigemini-HD-34B | - | - | 2141 | 80.6 | 43.3 | 59.3 | - |

| llava-next-34b | 74.9 | 68.7 | 2030 | 79.3 | 46.0 | 57.4 | 88.8 |

| llava-next-8b | 71.6 | 69.5 | 1972 | 72.1 | 37.5 | - | 80.1 |

| llava-next-72b | 77.4 | 77.0 | 2159 | 80.5 | 46.6 | - | 89.2 |

| llava-next-1110b | 80.4 | 80.4 | 2201 | 80.5 | 49.0 | - | 90.4 |

| TROL-1.8B | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 45.1 | 69.7 |

| TROL-3.8B | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 51.1 | 76.6 |

| 小手手-7B | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 54.7 | 92.8 |

封闭源LLVM

| llvms | sqa-img | AI2D | Chartqa | 妈妈 | MMB | Mathvista | 种子img | mmstar |

|---|---|---|---|---|---|---|---|---|

| qwen-vl-plus | 71.6 | 75.9 | 78.1 | 2183 | 67.0 | 43.3 | 72.7 | 39.7 |

| 双子座 | 80.1 | 73.9 | 74.1 | 1933年 | 73.6 | 45.2 | 70.7 | 41.6 |

| GPT-4V | 84.6 | 78.2 | 78.5 | 1927年 | 77.0 | 49.9 | 69.1 | 46.1 |

| TROL-1.8B | 87.5 | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 69.0 | 45.5 |

| TROL-3.8B | 90.8 | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 70.5 | 46.5 |

| 小手手-7B | 92.8 | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 75.3 | 51.3 |

trol

trol总计:2273830(230万)

-------------------------------------*现实世界图像:755K*现实世界文字:143K*文档和图表与图&Sign&Sumply:627K*数学:747K

- 视力数学:180k

- 仅具有文字的数学:566K

------------------------------------------

-shareGpt4v捕获[无SAM](91021,91k)

-shareGpt4v-Instruction [没有几个OCR-VQA样本](664703,664K)

-Allava4v-Text(143000,143K)

-Minigemini-Instruction [DOCVQA,CHARTQA,DVQA,AI2D](27670,27K)

-docdownstream(574268,574K)

- 杜季节(25877,25k)

-Gllava-Align(60252,60K)

-Gllava-QA(117205,117K)

-Mathvision(3040,3K)

-Mathinstruct [Textonlydataset](262040,262K)

-Mathplus [textonlydataset](304754,304k)我们收集以下九个数据集。对于Minigemini,我们仅有选择地将数据样本用于DOCVQA,CHARTQA,DVQA和AI2D。因此,您无需下载Minigemini的所有数据样本。

sharegpt4v [链接]

Allava4v-Text [link]

Minigemini [链接]

docdownstream [链接]

do季节[链接]

Gllava [链接]

Mathvision [链接]

Mathinstruct [链接]

Mathplus [链接]

收集的数据集布局

trol_dataset_path

├├期llava#sharegpt4v│└└─-llava_pretrain

││└前图

├ - 可可#sharegpt4v│└──Train2017

├├期sam#sharegpt4v││ - 图像

├─-gqa#sharegpt4v│└─..m图像

├ - ─ocr_vqa#sharegpt4v││─图像

textvqa#sharegpt4v│└-textvqa#train_images

├├期:vg#sharegpt4v│├──VG_100K

││└─-VG_100K_2

├├─share_textvqa#sharegpt4v││-图像

├ - ─-Web-Celebrity#sharegpt4v│└-图像

├ - ─网络标志#sharegpt4v│└─..m图像

Wikiart#sharegpt4v│└─..m图像图像

├├─share_textvqa#sharegpt4v││-图像

├ - docvqa#minigemini│ - 图像

ChartQA#MINIGEMINI│ - 训练

││└前图

├ - dVQA#MINIGEMINI│ - 图像

├├期 - AI2D#MINIGEMINI│ - 图像

├ - imgs#docdownstream&doerosaly│ - chartqa

│└└─-due_benchmark

││└站

││└└-docvqa

││└└-infopraphicsVQA

││└站

││└─....tabfact

│└└└└-wikiblesquestions

│└│└-textcaps

textVQA

Visualmrc

├─geo3k#gllava | └ - 火车

├─-geoqa_plus#gllava├─图像#MATHVISION | MATHVISION | sharegpt4v_instruct_gpt4-vish4-vision_cap100k.json#sharegpt4v-caption├─ OL-Instruct-GPT4-Turbo-143K。 json # ALLAVA4V-Text├── train.jsonl # DocDownstream├── detailed_explanation.jsonl # DocReason├── minigemini_instruction.json # MiniGemini-Instruction├── gllava_align.parquet # GLLaVA-Align├── gllava_qa.parquet # GLLaVA- QA├├─Mathvision.parquet#Mathvision├─Mathinstruct.json#MathinStruct└─Mathplus.parquet#Mathplus这些是评估数据集的列表。如果您完全下载它们,则应通过以下目录布局将数据集放在文件夹中。

Q BENCH [链接]

SQA-IMG [链接]

AI2D [链接]

ChartQA [链接]

种子[链接]

教皇[链接]

HallusionBench [链接]

MME [链接]

Mathvista [链接]

MMB [链接]

MM-VET [链接]

llava-w [链接]

mmstar [链接]

数学[链接]

Visualwebbench [链接]

评估数据集目录布局

evaluation_dataset_path ├──llvisionqa-qbench#q-Bench├─科学QA#sqa-img├iscon-ai2d#ai2d├-加台Qa#chartqa#chartqa#chartqa├──ic- seed-bench#seed-img├─pope#pope#pope#pope├iscon-pope├ischimusion-hallushiusionbench #halliusionBench├─mme_benchmark_release_version#mme├istion#mathvista#Mathvista├─mmmbench#mmb├─mm-vet#mm-vet#mm-vet├─lllava-llava-in-the-the-the-the-the-wild#lllava bent thewild├-lllava bent theWild├istripintion├-llava batch ─MMSTAR#MMSTAR├─Mathverse#Mathverse└─Visualwebbench#VisualWebbbench