Trol: Traversal des couches pour les grands modèles de langage et de vision [ARXIV]

Trol: Traversal des couches pour les grands modèles de langage et de vision [ARXIV]

Grâce au personnel de HuggingFace, nous pouvons utiliser le zérogpu gratuit (NVIDIA A100) pour chaque utilisateur, mais il y a des requêtes limitées, donc si les inférences sont bloquées, veuillez attendre quelques minutes. (La vitesse de démonstration locale est beaucoup plus rapide que cet espace GPU en ligne.)

TROL-1.8B est maintenant disponible dans les modèles HuggingFace. (Readme de démo locale incluse)

Trol-3.8b est désormais disponible dans les modèles HuggingFace. (Readme de démo locale incluse)

Trol-7b est maintenant disponible dans les modèles de HuggingFace. (Readme de démo locale incluse)

La démo en ligne de trol est maintenant disponible dans les espaces de câlins. (Vous pouvez choisir la taille du modèle)

Code d'implémentation officiel de Pytorch pour réaliser la partie technique de la traversée des couches (Trol) pour améliorer de nombreuses performances de langage de vision avec une taille de modèle efficace. Ce code est développé à partir de zéro. J'ai donc essayé d'améliorer la lecture et la simplicité du code, par rapport à Llava qui a un code structuré relativement complexe.

Figure 1. Couche de trol. Nouvelle propagation.

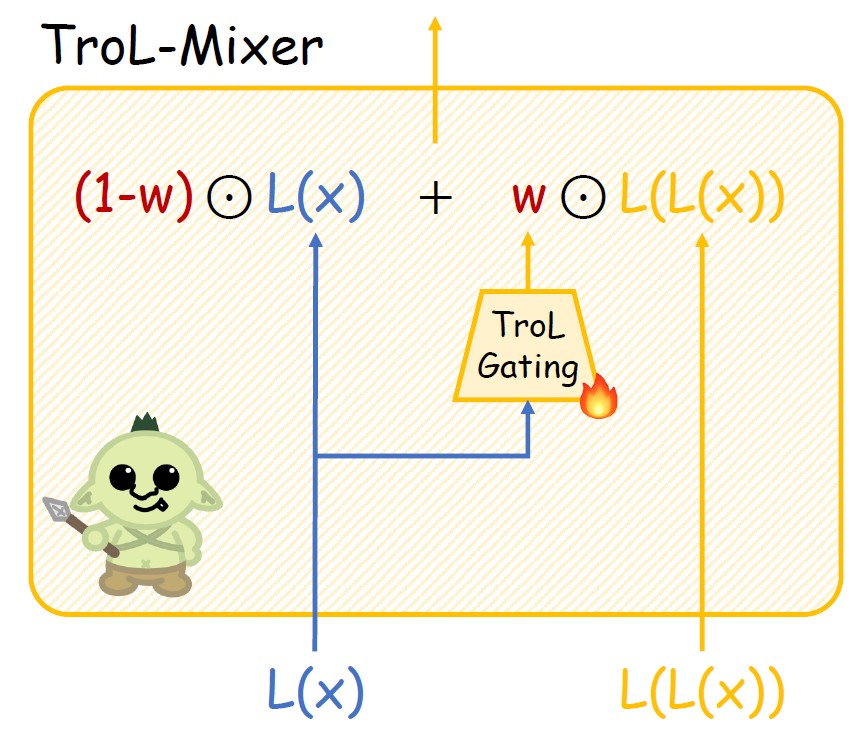

Figure 2. Structure du trol-mixeur.

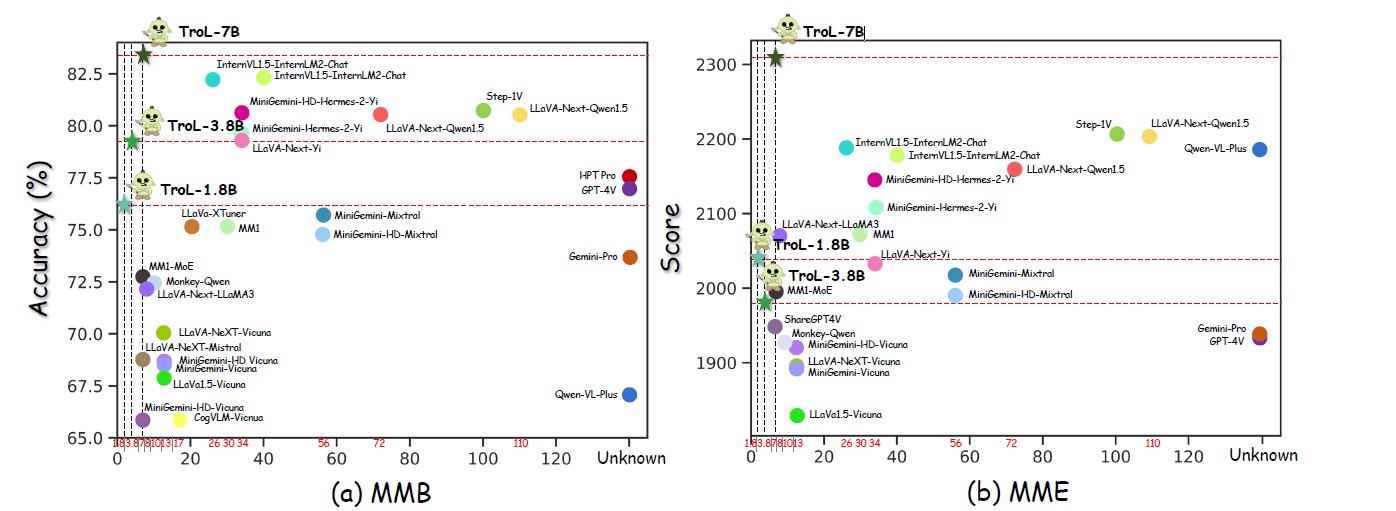

Figure 3. Performances dans de nombreuses tailles de modèle.

Figure 4. Comparaison avec les LLVM de source fermée.

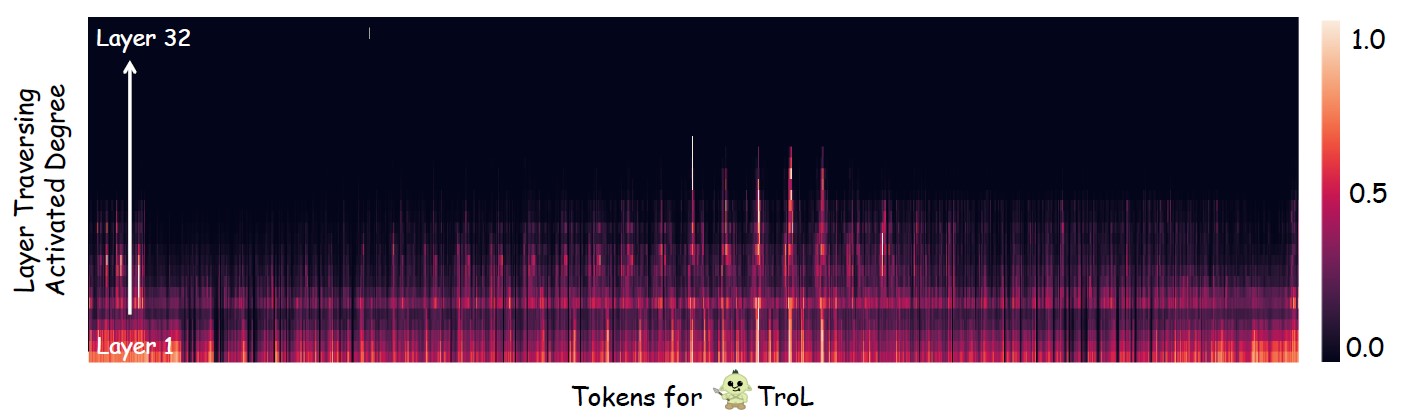

Figure 5. Enquêter où la couche traversant (les couches de réutilisation) se produit principalement.

LLVMS open source avec une taille de modèle standard

| LLVM | SQA-IMG | PAPE | Mme | MMB | Mathvista | Semence-IMG | Mm-vet | Llava-w |

|---|---|---|---|---|---|---|---|---|

| YI-VL-6B | 71.7 | 82.5 | 1915 | 64.2 | 29.7 | 67.5 | 32.1 | 51.9 |

| Llava-next-7b | 70.1 | 86.5 | 1851 | 69.6 | 34.6 | 70.2 | 43.9 | 72.3 |

| MM1-7B | 72.6 | 86.6 | 1858 | 72.3 | 35.9 | 70.9 | 42.1 | - |

| Trol-1.8b | 87.5 | 88.6 | 2038 | 76.1 | 45.4 | 69.0 | 45.1 | 69.7 |

| Trol-3.8b | 90.8 | 86.5 | 1980 | 79.2 | 55.1 | 70.5 | 51.1 | 76.6 |

| Trol-7b | 92.8 | 87.8 | 2308 | 51.8 | 75.3 | 54.7 | 92.8 | 87.1 |

LLVMS open source avec de grandes tailles de modèle

| LLVM | AI2D | Chartqa | Mme | MMB | Mathvista | Mm-vet | Llava-w |

|---|---|---|---|---|---|---|---|

| Intervl1.5-40b | 79.0 | 68.0 | 2175 | 82.2 | 47.7 | 48.9 | - |

| Intervl1.5-26b | 80.7 | 83.8 | 2188 | 82.2 | 53.5 | 62.8 | - |

| MM1-30B | - | - | 2069 | 75.1 | 39.4 | 48.7 | - |

| Minigemini-34b | - | - | 2105 | 79.6 | 38.9 | 53.0 | - |

| Minigemini-HD-34B | - | - | 2141 | 80.6 | 43.3 | 59.3 | - |

| Llava-next-34b | 74.9 | 68.7 | 2030 | 79.3 | 46.0 | 57.4 | 88.8 |

| Llava-next-8b | 71.6 | 69.5 | 1972 | 72.1 | 37.5 | - | 80.1 |

| Llava-next-72b | 77.4 | 77.0 | 2159 | 80.5 | 46.6 | - | 89.2 |

| Llava-next-110b | 80.4 | 80.4 | 2201 | 80.5 | 49.0 | - | 90.4 |

| Trol-1.8b | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 45.1 | 69.7 |

| Trol-3.8b | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 51.1 | 76.6 |

| Trol-7b | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 54.7 | 92.8 |

LLVMS de source fermée

| LLVM | SQA-IMG | AI2D | Chartqa | Mme | MMB | Mathvista | Semence-IMG | Mmstar |

|---|---|---|---|---|---|---|---|---|

| Qwen-vl-plus | 71.6 | 75.9 | 78.1 | 2183 | 67.0 | 43.3 | 72.7 | 39.7 |

| Gemini-pro | 80.1 | 73.9 | 74.1 | 1933 | 73.6 | 45.2 | 70.7 | 41.6 |

| GPT-4V | 84.6 | 78.2 | 78.5 | 1927 | 77.0 | 49.9 | 69.1 | 46.1 |

| Trol-1.8b | 87.5 | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 69.0 | 45,5 |

| Trol-3.8b | 90.8 | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 70.5 | 46.5 |

| Trol-7b | 92.8 | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 75.3 | 51.3 |

Trol

TrolTotal: 2273830 (2,3 m)

------------------------------ * Image du monde réel: 755K * Texte du monde réel: 143K * Document & Chart & Diagramme & Signe et symbole: 627k * mathématiques: 747k

- Math avec vision: 180K

- mathématiques avec texte uniquement: 566k

------------------------------

- Sharegpt4v-caption [sans SAM] (91021, 91k)

- Sharegpt4v-Istruction [sans quelques échantillons d'OCR-VQA] (664703, 664K)

- Allava4v-Text (143000, 143k)

- Minigemini-Instruche [Docvqa, Chartqa, DVQA, AI2D] (27670, 27K)

- DocdownStream (574268, 574K)

- DOCRANSE (25877, 25K)

- Glava-Adign (60252, 60K)

- Glava-QA (117205, 117K)

- Mathvision (3040, 3K)

- Mathinstruc [TextOnlyDataset] (262040, 262K)

- MathPlus [TextOnlyDataset] (304754, 304K)Nous collectons les neuf ensembles de données suivants. Pour Minigemini, nous utilisons sélectivement des échantillons de données uniquement pour DOCVQA, ChartQA, DVQA et AI2D. Par conséquent, il n'est pas nécessaire pour vous de télécharger tous les échantillons de données pour Minigemini.

Sharegpt4v [lien]

Allava4v-text [lien]

Minigemini [lien]

Docdowstream [lien]

DOCRENON [LIEN]

Gllava [lien]

MathVision [lien]

Mathinstruc [lien]

MathPlus [lien]

Disposition de l'ensemble de données rassemblé

Trol_dataset_path

├fique

│ └fiques

├fiques coco # sharegpt4v│ └fique

├fique

├fique

├fique

├── Textvqa # sharegpt4v│ └fique

├fique

│ └fique

├fique

├fiquesbrity web-celebrity # sharegpt4v│ └fique

├fiques web-landmark # sharegpt4v│ └fique

├fiques

├fique

├fiques docvqa # minigemini│ └fique

├fique

│ └fiques

├fique

├fique

├tilmet IMGS # docdowstream & docreason│ └fique

│ └fique

│ └fique

│ └fique

│ └fique

│ └fiques

│ └fique

│ └fiques

│ └fiques

│ └fiques

│ └fique

├fiques-Geo3k # gllava | └til

├── Geoqa_Plus # gllava├fiques Ol-Istruct-GPT4-Turbo-143K. JSON # allava4v-text├fique Qa├fiquement mathVision.Parquet # MathVision├fiqueCe sont la liste des ensembles de données d'évaluation. Si vous les téléchargez complètement, l'ensemble de données doit être placé dans le dossier par la disposition ci-dessous suivante.

Q-Bench [lien]

SQA-IMG [lien]

AI2D [lien]

ChartQa [lien]

Graine [lien]

Pape [lien]

Hallushingbench [lien]

Mme [lien]

Mathvista [lien]

MMB [lien]

Mm-vet [lien]

Llava-w [lien]

Mmstar [lien]

Mathverse [lien]

VisualWebbench [lien]

Disposition du répertoire de l'ensemble de données d'évaluation

Évaluation_dataset_path ├── llVisionqa-qbench # q-bench├── scienceqa # sqa-img├fique # Hallushingbench├fiques ─ mmstar # mmstar├── mathverse # mathverse└fiques visualwebbench # visualwebbench