Trol: Traversal von Schichten für große Sprache und Sehmodelle [ARXIV]

Trol: Traversal von Schichten für große Sprache und Sehmodelle [ARXIV]

Dank der Mitarbeiter von Huggingface können wir für jeden Benutzer kostenlose Zerogpu (NVIDIA A100) verwenden. Es gibt jedoch nur begrenzte Abfragen. Wenn die Schlussfolgerungen fest sind, warten Sie bitte einige Minuten. (Die lokale Demo -Geschwindigkeit ist viel schneller als dieser Online -GPU -Bereich.)

Trol-1.8b ist jetzt in "Huggingface" -Modellen erhältlich. (Lokale Demo Readme inklusive)

Trol-3.8b ist jetzt in "Huggingface" -Modellen erhältlich. (Lokale Demo Readme inklusive)

TROL-7B ist jetzt in Modellen mit Huggingface erhältlich. (Lokale Demo Readme inklusive)

Die Online -Trol -Demo ist jetzt in "Huggingface" -Räumen erhältlich. (Sie können die Modellgröße wählen)

Der offizielle Pytorch -Implementierungscode zur Realisierung des technischen Teils des Durchquerens von Schichten (TROL) zur Verbesserung zahlreicher Sehsprache mit effizienter Modellgröße. Dieser Code wird von Grund auf neu entwickelt. Daher habe ich versucht, die Lesbarkeit und Einfachheit des Codes zu verbessern, verglichen mit LLAVA, der einen relativ komplexen strukturierten Code aufweist.

Abbildung 1. Trol -Schicht. Neue Ausbreitung.

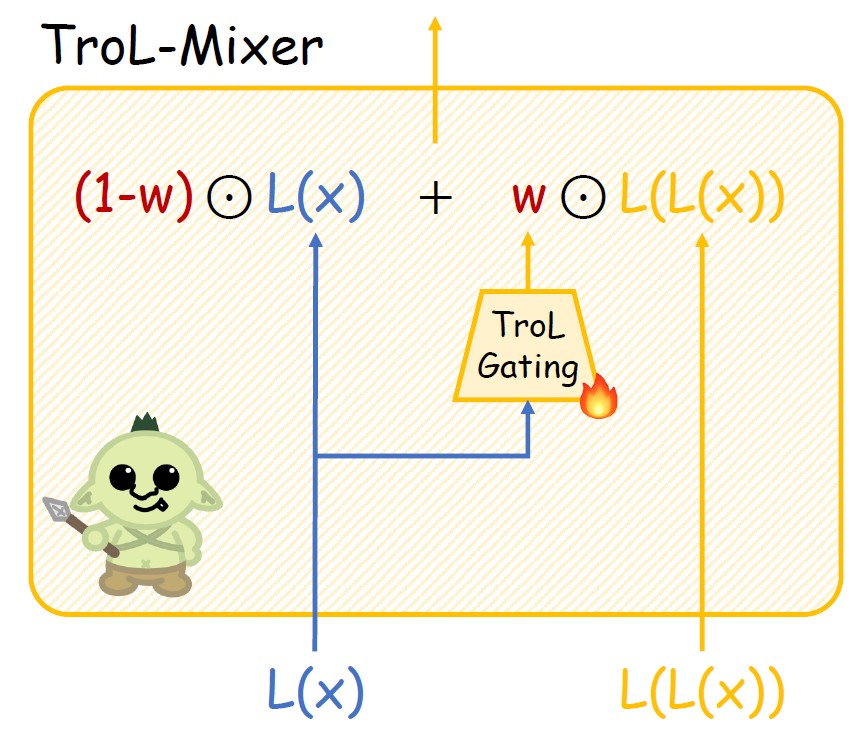

Abbildung 2. Struktur des Trol-Mixers.

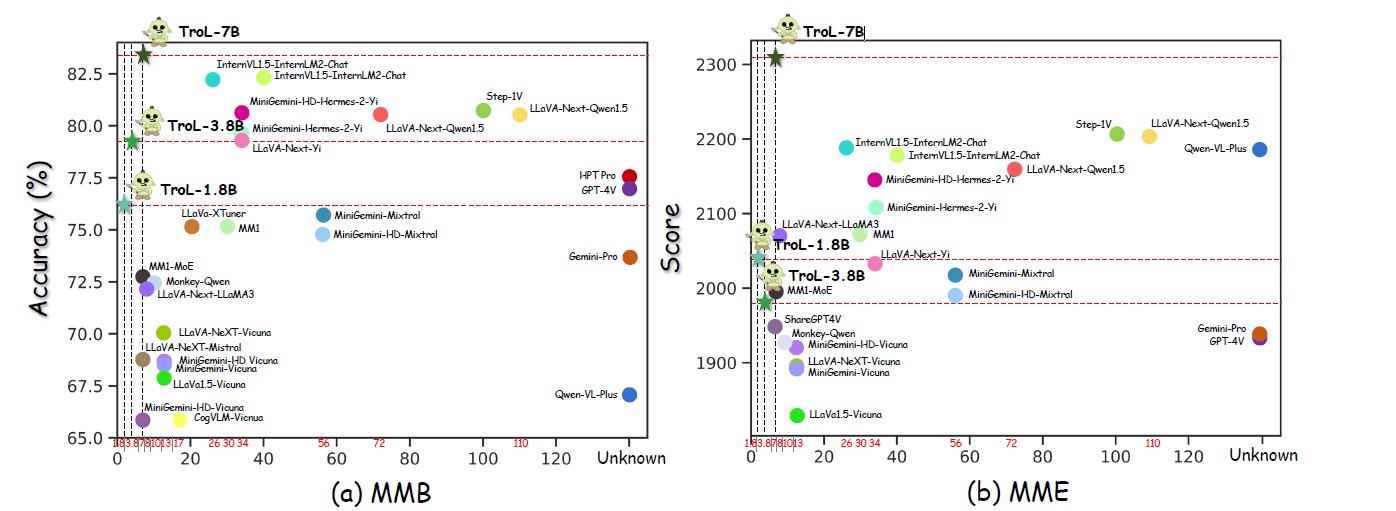

Abbildung 3. Performances über zahlreiche Modellgrößen.

Abbildung 4. Vergleich mit Closed-Source-LLVMs.

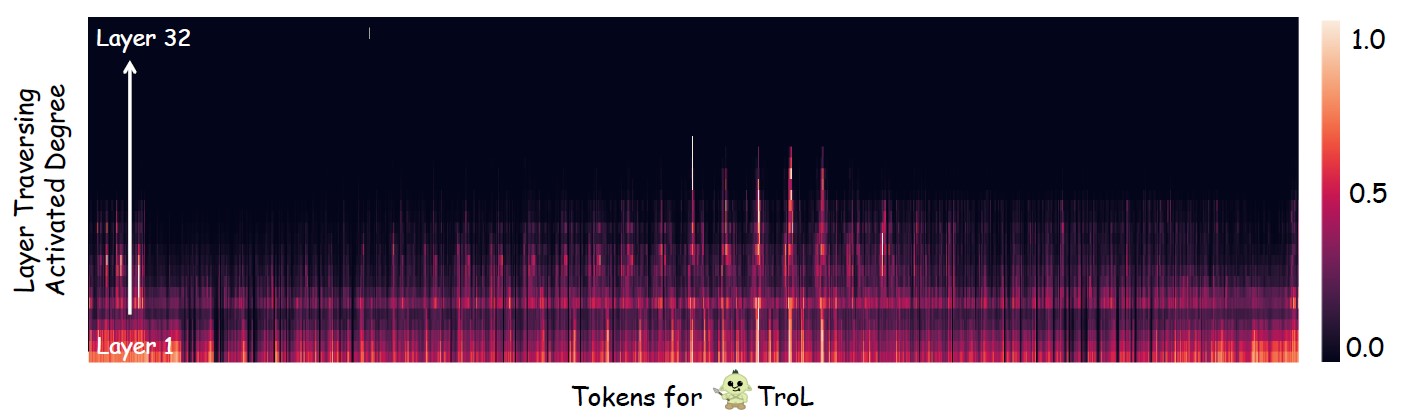

Abbildung 5. Untersuchung, wo Schichtverfolgung (Wiederverwendung von Schichten) hauptsächlich auftritt.

Open-Source LLVMs mit Standardmodellgröße

| Llvms | SQA-IMG | PAPST | Mme | MMB | Mathvista | Samen-Img | MM-VET | Llava-w |

|---|---|---|---|---|---|---|---|---|

| Yi-vl-6b | 71.7 | 82,5 | 1915 | 64.2 | 29.7 | 67,5 | 32.1 | 51.9 |

| Llava-next-7b | 70.1 | 86,5 | 1851 | 69.6 | 34.6 | 70,2 | 43.9 | 72.3 |

| MM1-7b | 72.6 | 86.6 | 1858 | 72.3 | 35.9 | 70,9 | 42.1 | - - |

| Trol-1.8b | 87,5 | 88,6 | 2038 | 76.1 | 45,4 | 69.0 | 45.1 | 69.7 |

| Trol-3.8b | 90,8 | 86,5 | 1980 | 79,2 | 55.1 | 70,5 | 51.1 | 76,6 |

| Trol-7b | 92.8 | 87,8 | 2308 | 51.8 | 75,3 | 54.7 | 92.8 | 87.1 |

Open-Source LLVMs mit großen Modellgrößen

| Llvms | Ai2d | Chartqa | Mme | MMB | Mathvista | MM-VET | Llava-w |

|---|---|---|---|---|---|---|---|

| Internvl1.5-40b | 79,0 | 68.0 | 2175 | 82.2 | 47,7 | 48,9 | - - |

| Internvl1.5-26b | 80.7 | 83.8 | 2188 | 82.2 | 53,5 | 62,8 | - - |

| MM1-30B | - - | - - | 2069 | 75.1 | 39.4 | 48,7 | - - |

| Minigemini-34b | - - | - - | 2105 | 79,6 | 38,9 | 53.0 | - - |

| Minigemini-HD-34B | - - | - - | 2141 | 80.6 | 43.3 | 59.3 | - - |

| Llava-next-34b | 74,9 | 68,7 | 2030 | 79,3 | 46.0 | 57,4 | 88,8 |

| Llava-next-8b | 71.6 | 69,5 | 1972 | 72.1 | 37,5 | - - | 80.1 |

| Llava-next-72b | 77,4 | 77.0 | 2159 | 80.5 | 46.6 | - - | 89,2 |

| Llava-next-110b | 80.4 | 80.4 | 2201 | 80.5 | 49,0 | - - | 90.4 |

| Trol-1.8b | 68,9 | 64.0 | 2038 | 76.1 | 45,4 | 45.1 | 69.7 |

| Trol-3.8b | 73.6 | 73,8 | 1980 | 79,2 | 55.1 | 51.1 | 76,6 |

| Trol-7b | 78,5 | 71.2 | 2308 | 83,5 | 51.8 | 54.7 | 92.8 |

LLVMS geschlossen

| Llvms | SQA-IMG | Ai2d | Chartqa | Mme | MMB | Mathvista | Samen-Img | Mmstar |

|---|---|---|---|---|---|---|---|---|

| Qwen-vl-plus | 71.6 | 75,9 | 78.1 | 2183 | 67.0 | 43.3 | 72.7 | 39.7 |

| Gemini-Pro | 80.1 | 73,9 | 74.1 | 1933 | 73.6 | 45,2 | 70.7 | 41.6 |

| GPT-4V | 84.6 | 78,2 | 78,5 | 1927 | 77.0 | 49,9 | 69.1 | 46.1 |

| Trol-1.8b | 87,5 | 68,9 | 64.0 | 2038 | 76.1 | 45,4 | 69.0 | 45,5 |

| Trol-3.8b | 90,8 | 73.6 | 73,8 | 1980 | 79,2 | 55.1 | 70,5 | 46,5 |

| Trol-7b | 92.8 | 78,5 | 71.2 | 2308 | 83,5 | 51.8 | 75,3 | 51.3 |

Trol

TrolGesamt: 2273830 (2,3 m)

----------------------------/ & Zeichen & Symbol: 627k* Math: 747k

- Mathematik mit Vision: 180k

- Mathematik nur mit Text: 566k

-----------------------------------

- Sharegpt4v-Kapion [ohne SAM] (91021, 91k)

-Sharegpt4V-Instruktur [ohne wenige Proben von OCR-VQA] (664703, 664K)

- Allava4v-Text (143000, 143k)

- Minigemini-Anstruktur [DOCVQA, Chartqa, DVQA, AI2D] (27670, 27K)

- Docdownstream (574268, 574K)

- Docreason (25877, 25K)

- Gllava-Align (60252, 60k)

- Gllava-qa (117205, 117k)

- Mathvision (3040, 3k)

- MathInstruct [TextonlyDataset] (262040, 262k)

- Mathplus [TextonlyDataset] (304754, 304K)Wir sammeln die folgenden neun Datensätze. Für Minigemini verwenden wir selektiv Datenproben für Docvqa, ChartQA, DVQA und AI2D. Daher müssen Sie alle Datenmuster für Minigemini herunterladen.

Sharegpt4v [Link]

Allava4v-Text [Link]

Minigemini [Link]

Docdownstream [Link]

Docreason [Link]

Gllava [Link]

Mathvision [Link]

MathInstruct [Link]

Mathplus [Link]

Sammelendes Datensatzlayout

Trol_dataset_path

├── Llava # Sharegpt4V│ └── llava_petrain

│ └── Bilder

├── Coco # Sharegpt4V│ └── Train2017

°

├── GQA # Sharegpt4V│ └── Bilder

├── OCR_VQA # SHAREGPT4V│ └── Bilder

°

├── VG # Sharegpt4V│ ├── vg_100k

│ └── VG_100K_2

°

├── Web-Celebrity # Sharegpt4V│ └── Bilder

├── Web-Landmark # Sharegpt4V│ └── Bilder

├── Wikiart # Sharegpt4V│ └── Bilder

°

├── docvqa # minigemini│ └── Bilder

├── Chartqa # Minigemini│ └── Zug

│ └── Bilder

├── DVQA # Minigemini│ └── Bilder

├── AI2D # Minigemini│ └── Bilder

°

"

│ └── Deepform

│ └── docvqa

│ └── Infograficsvqa

│ └── KLEISTERCHARITY

│ └── Tabfakt

│ └── wikitleQuestions

│ └── Textcaps

│ └── textvqa

│ └── visualmrc

├── Geo3K # gllava | └── Zug

├── geoqa_plus # GLLaVA├── images # MathVision|├── sharegpt4v_instruct_gpt4-vision_cap100k.json # ShareGPT4V-Caption├── sharegpt4v_mix665k_cap23k_coco-ap9k_lcs3k_sam9k_div2k.json # ShareGPT4V-Instruction├── Evol-Instruct-GPT4-Turbo-143K. json # ALLAVA4V-Text├── train.jsonl # DocDownstream├── detailed_explanation.jsonl # DocReason├── minigemini_instruction.json # MiniGemini-Instruction├── gllava_align.parquet # GLLaVA-Align├── gllava_qa.parquet # GLLaVA- Qa├── Mathvision.Parquet # MathVision├── MathInstruct.json # mathInstruct└gangDies sind die Liste der Bewertungsdatensätze. Wenn Sie sie vollständig herunterladen, sollte der Datensatz im Ordner im folgenden Verzeichnislayout platziert werden.

Q-Bench [Link]

SQA-IMG [Link]

AI2D [Link]

Chartqa [Link]

Saatgut [Link]

Papst [Link]

HallusionBench [Link]

Mme [Link]

Mathvista [Link]

MMB [Link]

MM-VET [Link]

Llava-w [Link]

MMSTAR [Link]

Mathverse [Link]

Visualwebbench [Link]

Bewertungsdatensatzverzeichnislayout

Evaluation_dataset_path ├── llvisionqa-qbench # q-Bench├── Scienceqa # SQA-IMG├── AI2D # AI2D├├ # Chartqa├├ # Saatgut # Samen-Img├── # Papst Papst # HallusionBench├── # Mme_Benchmark_Release_VERSION # MME├form mathvista # mathvista├├ # mmbench # mmb├fornen MM-VET # MM-VET├├├ # LLAVA-Bench-in-the-the-the-the-the-the-the-the-the-the-llava-Bench in der Wildnis in der Wildnis. ─ Mmstar # Mmstar├── Mathverse # mathverse└wort # visualwebbench # visualwebbench