트롤 : 큰 언어 및 비전 모델을위한 레이어의 횡단 [ARXIV]

트롤 : 큰 언어 및 비전 모델을위한 레이어의 횡단 [ARXIV]

Huggingface 직원 덕분에 각 사용자에게 무료 Zerogpu (NVIDIA A100)를 사용할 수 있지만 쿼리가 제한되어 있으므로 추론이 고정되면 몇 분 동안 기다리십시오. (로컬 데모 속도는이 온라인 GPU 공간보다 훨씬 빠릅니다.)

Trol-1.8b는 이제 "Huggingface 모델에서 사용할 수 있습니다. (로컬 데모 readme 포함)

Trol-3.8b는 이제 "Huggingface Models에서 사용할 수 있습니다. (로컬 데모 readme 포함)

Trol-7B는 이제 "Huggingface 모델에서 사용할 수 있습니다. (로컬 데모 readme 포함)

온라인 트롤 데모는 이제 "Huggingface Spaces에서 사용할 수 있습니다. (모델 크기를 선택할 수 있습니다)

효율적인 모델 크기로 수많은 비전 언어 성능을 향상시키기 위해 TROL (Traversal of Layers) 의 기술적 부분을 실현하기위한 공식 Pytorch 구현 코드. 이 코드는 처음부터 개발되었습니다. 따라서 비교적 복잡하게 구조화 된 코드를 갖는 LLAVA와 비교하여 코드의 재진성과 단순성을 향상 시키려고 노력했습니다.

그림 1. 트롤 레이어. 새로운 전파.

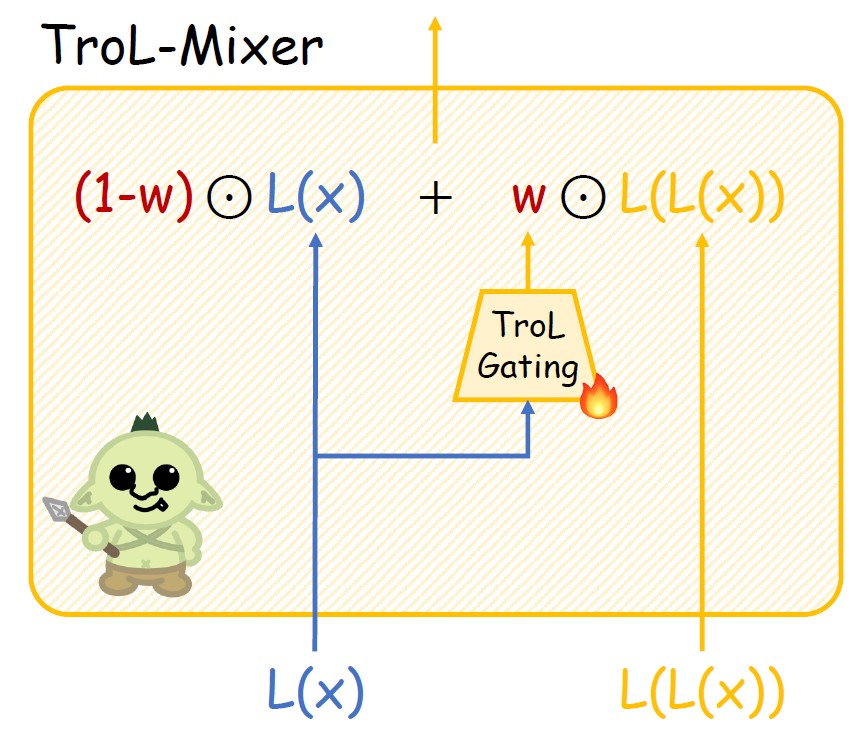

그림 2. 트롤 믹서의 구조.

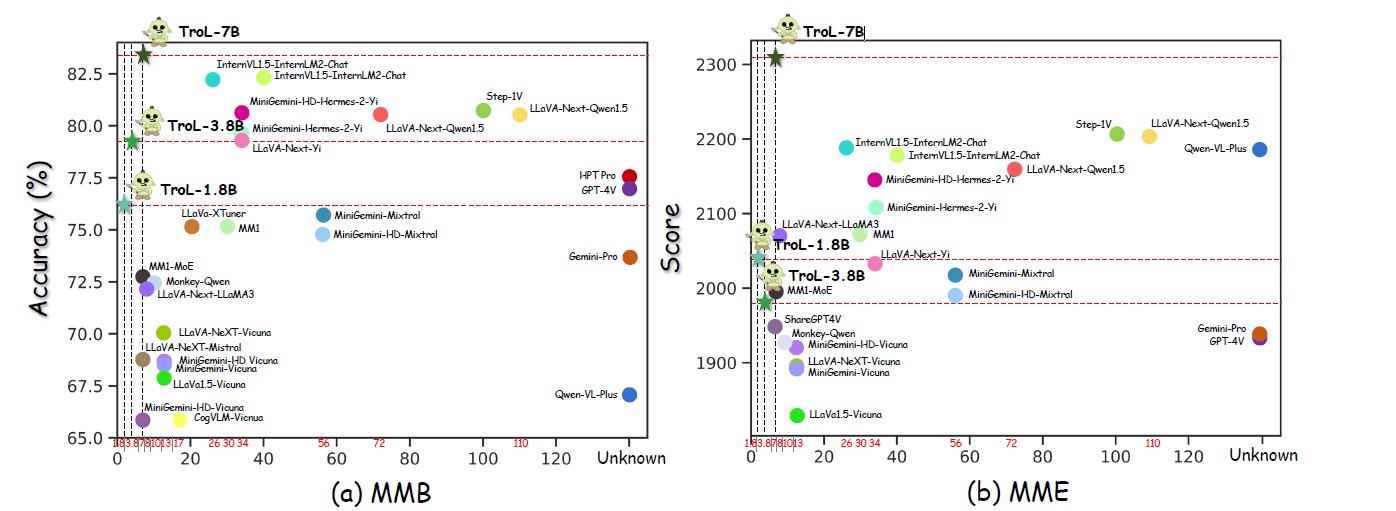

그림 3. 수많은 모델 크기에 따른 성능.

그림 4. 폐쇄 소스 LLVMS와의 비교.

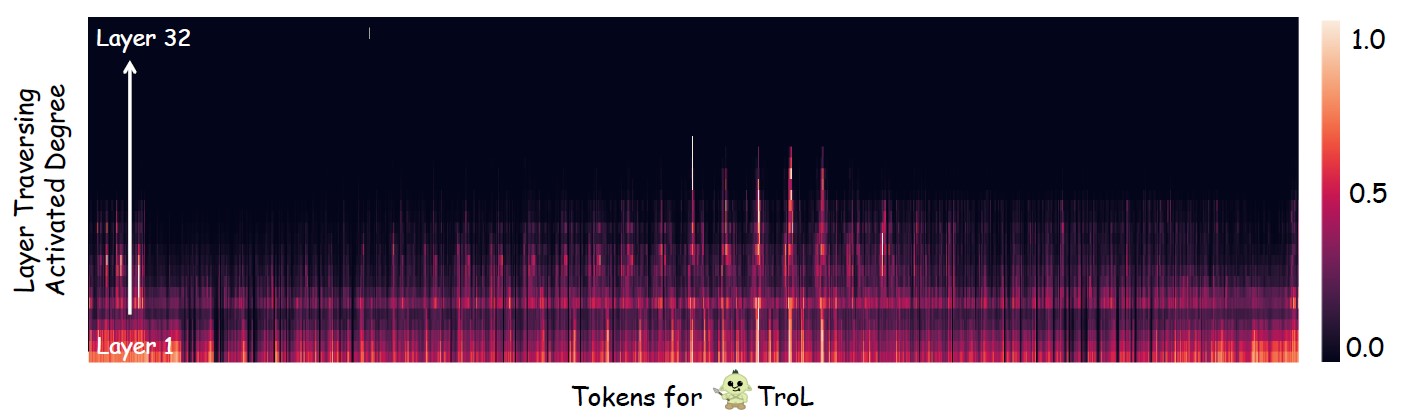

그림 5. 층 통과 (층 재사용 층)가 대부분 발생하는 곳을 조사합니다.

표준 모델 크기의 오픈 소스 LLVM

| llvms | SQA-IMG | 로마 교황 | mme | MMB | Mathvista | 종자-임그 | MM-VET | llava-w |

|---|---|---|---|---|---|---|---|---|

| Yi-VL-6B | 71.7 | 82.5 | 1915 | 64.2 | 29.7 | 67.5 | 32.1 | 51.9 |

| llava-next-7b | 70.1 | 86.5 | 1851 | 69.6 | 34.6 | 70.2 | 43.9 | 72.3 |

| MM1-7B | 72.6 | 86.6 | 1858 | 72.3 | 35.9 | 70.9 | 42.1 | - |

| 트롤 -1.8b | 87.5 | 88.6 | 2038 | 76.1 | 45.4 | 69.0 | 45.1 | 69.7 |

| 트롤 -3.8b | 90.8 | 86.5 | 1980 | 79.2 | 55.1 | 70.5 | 51.1 | 76.6 |

| 트롤 -7b | 92.8 | 87.8 | 2308 | 51.8 | 75.3 | 54.7 | 92.8 | 87.1 |

큰 모델 크기의 오픈 소스 LLVM

| llvms | AI2D | ChartQa | mme | MMB | Mathvista | MM-VET | llava-w |

|---|---|---|---|---|---|---|---|

| Internvl1.5-40b | 79.0 | 68.0 | 2175 | 82.2 | 47.7 | 48.9 | - |

| Internvl1.5-26B | 80.7 | 83.8 | 2188 | 82.2 | 53.5 | 62.8 | - |

| MM1-30B | - | - | 2069 | 75.1 | 39.4 | 48.7 | - |

| 미니 세미 -34b | - | - | 2105 | 79.6 | 38.9 | 53.0 | - |

| 미니 세미 니 -HD-34B | - | - | 2141 | 80.6 | 43.3 | 59.3 | - |

| llava-next-34b | 74.9 | 68.7 | 2030 | 79.3 | 46.0 | 57.4 | 88.8 |

| llava-next-8b | 71.6 | 69.5 | 1972 | 72.1 | 37.5 | - | 80.1 |

| llava-next-72b | 77.4 | 77.0 | 2159 | 80.5 | 46.6 | - | 89.2 |

| llava-next-1110b | 80.4 | 80.4 | 2201 | 80.5 | 49.0 | - | 90.4 |

| 트롤 -1.8b | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 45.1 | 69.7 |

| 트롤 -3.8b | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 51.1 | 76.6 |

| 트롤 -7b | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 54.7 | 92.8 |

폐쇄 소스 LLVM

| llvms | SQA-IMG | AI2D | ChartQa | mme | MMB | Mathvista | 종자-임그 | mmstar |

|---|---|---|---|---|---|---|---|---|

| Qwen-VL-Plus | 71.6 | 75.9 | 78.1 | 2183 | 67.0 | 43.3 | 72.7 | 39.7 |

| 쌍둥이 자리 프로 | 80.1 | 73.9 | 74.1 | 1933 | 73.6 | 45.2 | 70.7 | 41.6 |

| GPT-4V | 84.6 | 78.2 | 78.5 | 1927 | 77.0 | 49.9 | 69.1 | 46.1 |

| 트롤 -1.8b | 87.5 | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 69.0 | 45.5 |

| 트롤 -3.8b | 90.8 | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 70.5 | 46.5 |

| 트롤 -7b | 92.8 | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 75.3 | 51.3 |

트롤

트롤총 : 2273830 (2.3m)

---------------------------* 실제 이미지 : 755K* 실제 텍스트 : 143K* 문서 및 차트 및 다이어그램 & 사인 및 기호 : 627K* 수학 : 747K

- 비전과 수학 : 180k

- 텍스트 만있는 수학 : 566k

---------------------------------

-Sharegpt4v-Caption [SAM없이] (91021, 91K)

-Sharegpt4v-Instruction [OCR-VQA의 몇 가지 샘플없이] (664703, 664K)

-Allava4v-text (143000, 143k)

-Minigemini-Instruction [Docvqa, Chartqa, DVQA, AI2D] (27670, 27K)

-DocdownStream (574268, 574K)

-Docreason (25877, 25k)

-Gllava-Align (60252, 60k)

-Gllava-Qa (117205, 117k)

-Mathvision (3040, 3k)

-Mathinstruct [TextonlyDataset] (262040, 262k)

-Mathplus [TextonlyDataset] (304754, 304k)다음 9 개의 데이터 세트를 수집합니다. Minigemini의 경우 DOCVQA, ChartQA, DVQA 및 AI2D에 대해서만 데이터 샘플을 선택적으로 사용합니다. 따라서 Minigemini 용 모든 데이터 샘플을 다운로드 할 필요는 없습니다.

sharegpt4v [링크]

allava4v-text [link]

미니 세미니 [링크]

docdownstream [링크]

Doceason [Link]

Gllava [링크]

MathVision [링크]

Mathinstruct [링크]

Mathplus [링크]

수집 된 데이터 세트 레이아웃

trol_dataset_path

llava # sharegpt4v│ └ └ 커트. llava_pretrain

│ │ │─퀴 이미지

Coco # sharegpt4v│ └ └ └ └얼리. Train2017

SAM # sharegpt4v│ └ 대 이미지

├ ── GQA # sharegpt4v│ └ └ 담장. 이미지

OCR_VQA # sharegpt4v│ └ 대 이미지

TextVQA # sharegpt4v│ └ └ └ 커스

VG # sharegpt4v│ ├ 담사. vg_100k

VG_100K_2

Share_TextVQA # sharegpt4v│ └ 담장. 이미지

Web-Celebrity # sharegpt4v │ └ └ 커스티

Web-Landmark # sharegpt4v│ └ └ └ 커 이미지

Wikiart # sharegpt4v │ └ └ 커트. 이미지

Share_TextVQA # sharegpt4v│ └ 담장. 이미지

docvqa # minigemini│ └ └ 담장. 이미지

Chartqa # Minigemini│ └ └ └얼

│ │ │─퀴 이미지

DVQA # MINIGEMINI│ └ └ 담장. 이미지

AI2D # MINIGEMINI│ └ └ 커 이미지

IMGS # docdownstream & docreason └ └ └커

│ │ ── aprue_benchmark

Deepform

│ │ ─신 신입니다

infographicsvqa

Kleistercharity

tabfact

WikitableQuestions

│ │ ─퀴. 텍스트 캡

│ │ ─퀴 ~ textvqa

│ │ 익. VisualMrc

GEO3K # GLLAVA | └ ─) 기차

Geoqa_plus # gllava├à 정전 # MathVision | ├ | ├ | ├ | ─ sharegpt4v_instruct_gpt4-vision_cap100k.json # sharegpt4v-caption├ ─뇨 sharegpt4v_mix665k_cap23k_coco-ap9k_lcsam9k _dson # hortt4v OL- 강조 GPT4- 터보 -143K. JSON # allava4v-text├|) jsonl.jsonl # docdownStream #) reaverd_explanation.jsonl # docreason├| 있고 minigemini_instruction.json # minigemini-instruction ├ 착수는 Gllava_align.parquet # gllava-align├─ gllava_qa.parquet # Qaisionà 정전. MathVision.Parquet # MathVision ├ 착수평가 데이터 세트 목록입니다. 완전히 다운로드하면 데이터 세트는 다음 디렉토리 레이아웃 아래 폴더에 배치해야합니다.

Q- 벤치 [링크]

SQA-IMG [링크]

ai2d [링크]

ChartQa [링크]

씨앗 [링크]

교황 [링크]

hallusionbench [링크]

MME [링크]

Mathvista [Link]

MMB [링크]

MM-VET [링크]

llava-W [링크]

mmstar [링크]

Mathverse [링크]

VisualWebBench [링크]

평가 데이터 세트 디렉토리 레이아웃

평가_DATASET_PATH ScienceQa # Sqa-Img├à 정전 # Ai2d # Ai2d├à 정전 Qa # Chartqa├| 있고 Seed-Bench # Seed-Img├ 확장 # Pope # Pope #) HallusionBench # hallusionbench├─* MME_BENCHMARM_RELEASE_VERSION # MMEATION # U MATHVISTA # MATHVISTA태├ ─) MMBENCH # MMBATIN #) MM-VET # MM-VETATIN 출신 Llava-Bench-in-The-Wild # Llava Bench # ─ MMSTAR # MMSTAR태 ── MathVerse # Mathverse 신 ─신 VisualWebBench # VisualWebBench