TROL: Traversal de camadas para grandes modelos de linguagem e visão [Arxiv]

TROL: Traversal de camadas para grandes modelos de linguagem e visão [Arxiv]

Graças à equipe da HuggingFace, podemos usar o ZeroGPU gratuito (NVIDIA A100) para cada usuário, mas há consultas limitadas; portanto, se as inferências estiverem presas, aguarde alguns minutos. (A velocidade da demonstração local é muito mais rápida que esse espaço online da GPU.)

O TROL-1.8b agora está disponível em modelos de huggingface. (README DE DEMO LOCAL INCLUÍDO)

O TROL-3.8B está agora disponível em modelos de huggingface. (README DE DEMO LOCAL INCLUÍDO)

O TROL-7B está agora disponível em modelos de huggingface. (README DE DEMO LOCAL INCLUÍDO)

A demonstração on -line do Trol está agora disponível em Spaces de Huggingface. (Você pode escolher o tamanho do modelo)

Código oficial de implementação do Pytorch para realizar a parte técnica da Traversal of Camadas (TROL) para melhorar inúmeras performances de linguagem de visão com tamanho eficiente do modelo. Este código é desenvolvido a partir do zero. Por isso, tenho tentado melhorar a legibilidade e a simplicidade do código, em comparação com o LLAVA, que possui código estruturado relativamente complexamente.

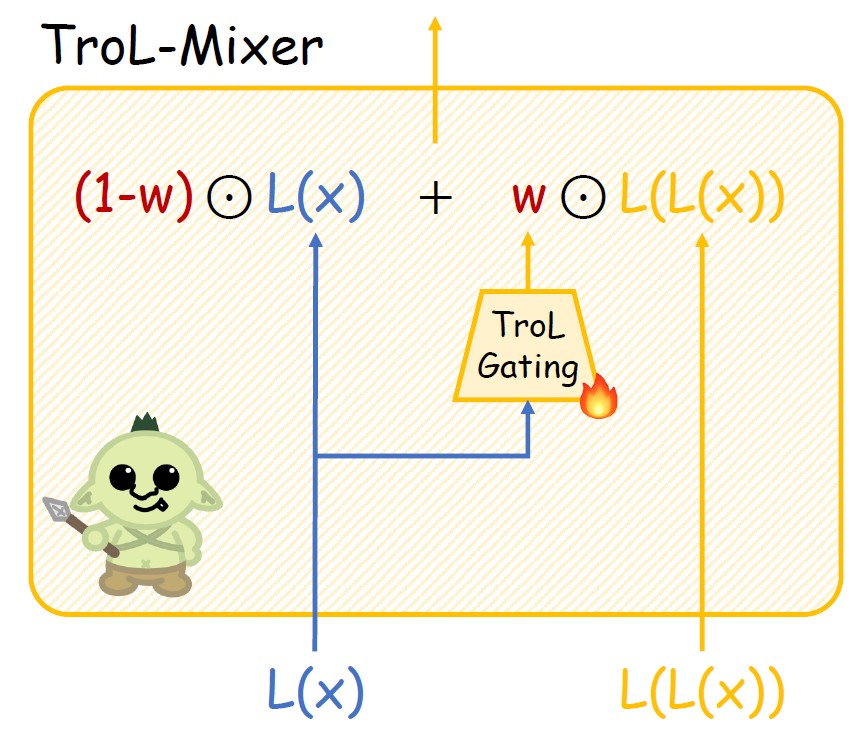

Figura 1. Camada de trol. Nova propagação.

Figura 2. Estrutura do mixer de carrinho.

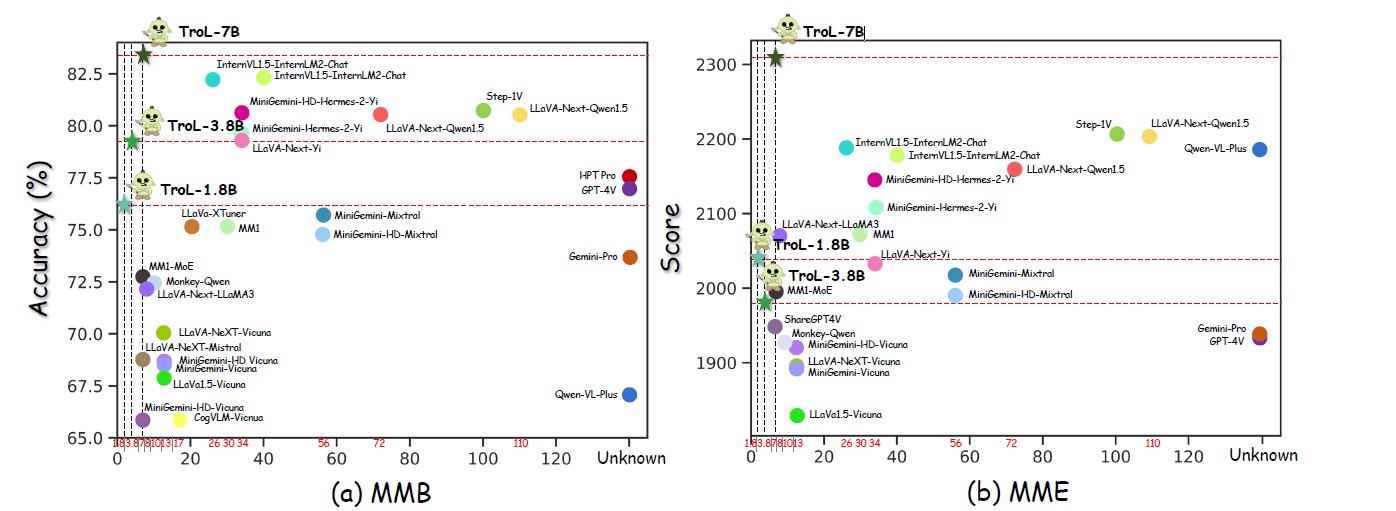

Figura 3. Performances em vários tamanhos de modelo.

Figura 4. Comparação com LLVMs de código fechado.

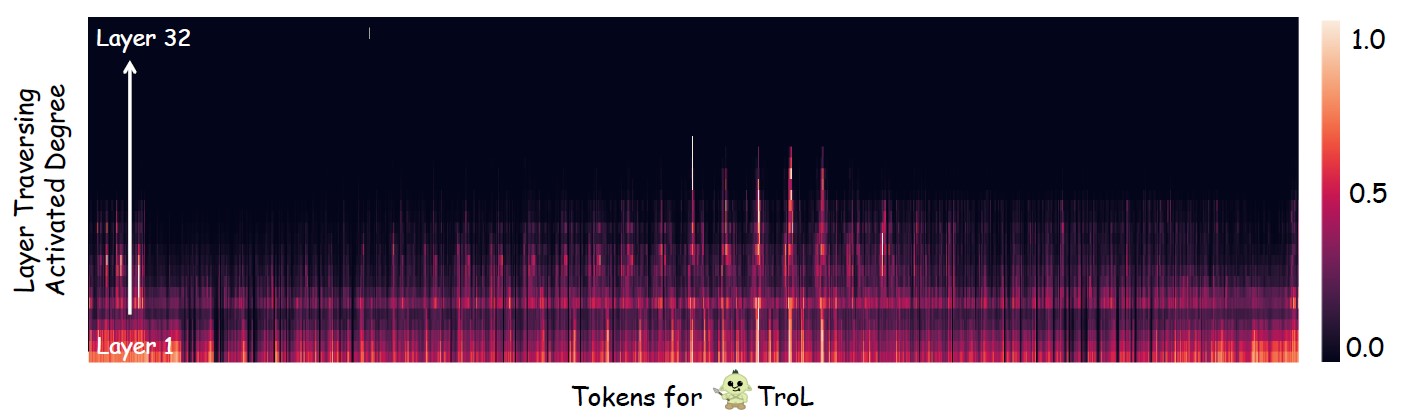

Figura 5. Investigar onde a camada atravessando (reutilizando camadas) acontece principalmente.

LLVMs de código aberto com tamanho de modelo padrão

| Llvms | SQA-IMG | PAPA | Mme | MMB | Mathvista | Semente-img | MM-VET | Llava-w |

|---|---|---|---|---|---|---|---|---|

| Yi-vl-6b | 71.7 | 82.5 | 1915 | 64.2 | 29.7 | 67.5 | 32.1 | 51.9 |

| Llava-next-7b | 70.1 | 86.5 | 1851 | 69.6 | 34.6 | 70.2 | 43.9 | 72.3 |

| MM1-7B | 72.6 | 86.6 | 1858 | 72.3 | 35.9 | 70.9 | 42.1 | - |

| TROL-1.8B | 87.5 | 88.6 | 2038 | 76.1 | 45.4 | 69.0 | 45.1 | 69.7 |

| TROL-3.8B | 90.8 | 86.5 | 1980 | 79.2 | 55.1 | 70.5 | 51.1 | 76.6 |

| TROL-7B | 92.8 | 87.8 | 2308 | 51.8 | 75.3 | 54.7 | 92.8 | 87.1 |

LLVMs de código aberto com grandes tamanhos de modelo

| Llvms | Ai2d | ChartQa | Mme | MMB | Mathvista | MM-VET | Llava-w |

|---|---|---|---|---|---|---|---|

| Internvl1.5-40b | 79.0 | 68.0 | 2175 | 82.2 | 47.7 | 48.9 | - |

| Internvl1.5-26b | 80.7 | 83.8 | 2188 | 82.2 | 53.5 | 62.8 | - |

| MM1-30B | - | - | 2069 | 75.1 | 39.4 | 48.7 | - |

| Minigemini-34b | - | - | 2105 | 79.6 | 38.9 | 53.0 | - |

| Minigemini-HD-34B | - | - | 2141 | 80.6 | 43.3 | 59.3 | - |

| LLAVA-NEXT-34B | 74.9 | 68.7 | 2030 | 79.3 | 46.0 | 57.4 | 88.8 |

| LLAVA-NEXT-8B | 71.6 | 69.5 | 1972 | 72.1 | 37.5 | - | 80.1 |

| LLAVA-NEXT-72B | 77.4 | 77.0 | 2159 | 80.5 | 46.6 | - | 89.2 |

| LLAVA-NEXT-110B | 80.4 | 80.4 | 2201 | 80.5 | 49.0 | - | 90.4 |

| TROL-1.8B | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 45.1 | 69.7 |

| TROL-3.8B | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 51.1 | 76.6 |

| TROL-7B | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 54.7 | 92.8 |

LLVMS de código fechado

| Llvms | SQA-IMG | Ai2d | ChartQa | Mme | MMB | Mathvista | Semente-img | Mmstar |

|---|---|---|---|---|---|---|---|---|

| QWEN-VL-PLUS | 71.6 | 75.9 | 78.1 | 2183 | 67.0 | 43.3 | 72.7 | 39.7 |

| Gemini-Pro | 80.1 | 73.9 | 74.1 | 1933 | 73.6 | 45.2 | 70.7 | 41.6 |

| GPT-4V | 84.6 | 78.2 | 78.5 | 1927 | 77.0 | 49.9 | 69.1 | 46.1 |

| TROL-1.8B | 87.5 | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 69.0 | 45.5 |

| TROL-3.8B | 90.8 | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 70.5 | 46.5 |

| TROL-7B | 92.8 | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 75.3 | 51.3 |

Trol

TrolTotal: 2273830 (2,3m)

--------------------------------* Imagem do mundo real: 755K* Texto do mundo real: 143K* Document & Chart & Diagram & Sign & Symbol: 627K* Matemática: 747K

- Matemática com visão: 180K

- Matemática apenas com texto: 566k

--------------------------------

- ShareGPT4V-Caption [sem Sam] (91021, 91k)

-ShareGPT4V-Instruction [sem poucas amostras de OCR-VQA] (664703, 664K)

- ALLAVA4V-TEXT (143000, 143K)

- Minigemin-Instruction [Docvqa, ChartQa, DVQA, AI2D] (27670, 27K)

- Docdownstream (574268, 574k)

- Docreason (25877, 25k)

- Gllava-Align (60252, 60k)

- Gllava-Qa (117205, 117K)

- MathVision (3040, 3k)

- MathInstruct [textonlydataset] (262040, 262k)

- Mathplus [textonlydataset] (304754, 304K)Coletamos os nove conjuntos de dados a seguir. Para Minigemini, usamos seletivamente amostras de dados apenas para docvqa, ChartQA, DVQA e AI2D. Portanto, não é necessário baixar todas as amostras de dados para Minigemini.

ShareGpt4V [link]

Allava4v-text [link]

Minigemini [link]

DocDownStream [link]

Docrurane [Link]

Gllava [link]

MathVision [link]

MathInstruct [link]

Mathplus [link]

Layout do conjunto de dados reunido

Trol_dataset_path

├sto

│ └── Imagens

├sto

├sto

├── GQA # sharegpt4v│ └── imagens

├── ocr_vqa # sharegpt4v│ └── imagens

├sto

├sto

│ └── VG_100K_2

├── share_textvqa # sharegpt4v│ └sto

├sto

├sto

├── Wikiart # sharegpt4v│ └── imagens

├── share_textvqa # sharegpt4v│ └sto

├sto

├── Chartqa # minigemini│ └sto

│ └── Imagens

├sto

├sto

├sto

│ └── Due_benchmark

│ └── Deepform

│ └── Docvqa

│ └── InfographicsVqa

│ └── Kleistarcaridade

│ └── tabfff

│ └── WikitableQuestions

│ └── TextCaps

│ └── TextVQA

│ └── VisualMrc

├── Geo3K # GLLAVA | └── trem

├─ Logeqa_plus # Gllava├erto Imagens # MathVision | ├── ShareGpt4v_instruct_gpt4-vision_cap100k.json # sharegpt4v-caption├sto Evol-Instruct-GPT4-Turbo-143k. JSON # ALLAVA4V-TEXT├erto Train.jsonl # DocDownStream├── detalhado_explanation.jsonl # docSoason├sto Qa├erto MathVision.Parquet # MathVision├stoEstes são a lista de conjuntos de dados de avaliação. Se você os baixar completamente, o conjunto de dados deverá ser colocado na pasta pelo layout do diretório a seguir.

``

SQA-IMG [link]

AI2D [link]

ChartQa [link]

Semente [link]

Papa [link]

Hallusionbench [link]

Mme [link]

Mathvista [link]

MMB [link]

MM-VET [link]

Llava-w [link]

Mmstar [link]

Mathverse [link]

Visualwebbench [link]

Layout do diretório do conjunto de dados de avaliação

Avaliação_dataset_path ├── llVisionqa-qbench # q-bench├sto # Hallusionbench├── mme_benchmark_release_version # mme├── mathvista # mathvista├── mmbench # mmb├── mm-vet # mm-vet├── llava-banch-in-the-wild # llava bânghia in wild├vio ─ mmstar # mmstar├── mathverse # mathverse└── visualwebbench # visualwebbench