ในด้านปัญญาประดิษฐ์การฝึกอบรมแบบจำลองภาษาขนาดใหญ่ (LLMS) ได้กลายเป็นทิศทางที่สำคัญในการส่งเสริมความก้าวหน้าทางเทคโนโลยี อย่างไรก็ตามในขณะที่ขนาดของโมเดลและชุดข้อมูลยังคงขยายตัววิธีการเพิ่มประสิทธิภาพแบบดั้งเดิม - ใน ADAMW โดยเฉพาะ - ค่อยๆเปิดเผยข้อ จำกัด ของพวกเขา นักวิจัยต้องเผชิญกับความท้าทายหลายประการเช่นค่าใช้จ่ายในการคำนวณที่สูงและความไม่แน่นอนในการฝึกอบรมรวมถึงการหายตัวไปของการไล่ระดับสีหรือการระเบิดการอัพเดทเมทริกซ์พารามิเตอร์ที่ไม่สอดคล้องกันและข้อกำหนดของทรัพยากรสูงในสภาพแวดล้อมแบบกระจาย ดังนั้นเทคนิคการเพิ่มประสิทธิภาพที่มีประสิทธิภาพและมีเสถียรภาพมากขึ้นจึงจำเป็นต้องมีความจำเป็นเร่งด่วนในการจัดการกับความซับซ้อนเหล่านี้

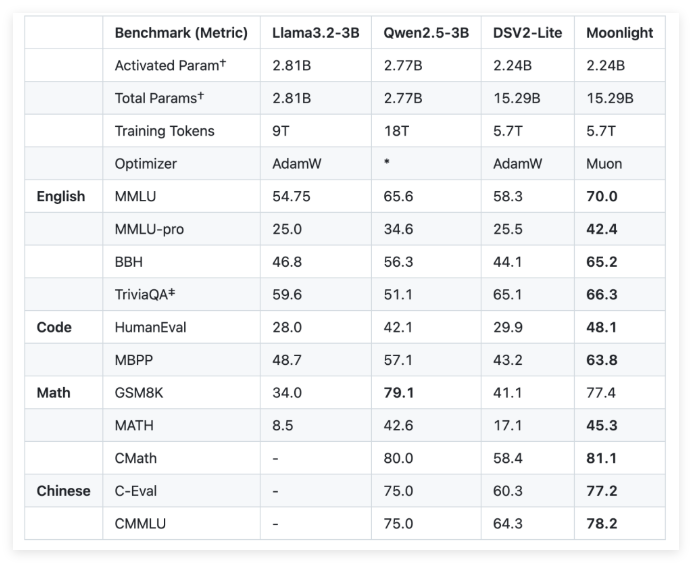

เพื่อจัดการกับความท้าทายเหล่านี้ Moonshot AI (ด้านมืดของดวงจันทร์) และ UCLA ได้พัฒนา Moonlight ร่วมกันซึ่งเป็นแบบจำลองการผสมผสานของ Expert (MOE) โดยใช้ Muon Optimizer Moonlight มีการกำหนดค่าสองแบบ: หนึ่งคือพารามิเตอร์การเปิดใช้งานคือ 3 พันล้านและอื่น ๆ คือพารามิเตอร์ทั้งหมดคือ 16 พันล้านและใช้คะแนน 5.7 ล้านล้านสำหรับการฝึกอบรม นวัตกรรมของ Muon Optimizer อยู่ในการใช้วิธีการวนซ้ำของ Newton-Schultz เพื่อดำเนินการ matrix orthogonalization เพื่อให้แน่ใจว่าความสม่ำเสมอของการอัพเดทการไล่ระดับสีในพื้นที่พารามิเตอร์ของโมเดล การปรับปรุงนี้เป็นทางเลือกที่มีแนวโน้มสำหรับ ADAMW แบบดั้งเดิมปรับปรุงประสิทธิภาพการฝึกอบรมและความมั่นคง

ในแง่ของรายละเอียดทางเทคนิค Moonlight ได้ปรับแต่งคีย์สองครั้งให้กับ Muon Optimizer ก่อนอื่นเทคโนโลยีการสลายตัวของน้ำหนักได้รับการแนะนำเพื่อควบคุมการเติบโตของน้ำหนักในระหว่างการฝึกอบรมรุ่นขนาดใหญ่และเครื่องหมายขนาดใหญ่ ประการที่สองแอมพลิจูดการอัปเดตของแต่ละพารามิเตอร์ได้รับการสอบเทียบเพื่อให้ได้รับการปรับขนาดตามสแควร์รูทของมิติสูงสุดของเมทริกซ์น้ำหนักซึ่งจะทำให้เกิดการอัปเดตอย่างสม่ำเสมอ

จากการประเมินเชิงประจักษ์ของแสงจันทร์นักวิจัยพบว่าประสิทธิภาพของมันที่จุดตรวจกลางนั้นดีกว่ารูปแบบการฝึกอบรม ADAMW แบบดั้งเดิม ตัวอย่างเช่นในภารกิจความเข้าใจภาษา Moonlight ได้รับคะแนนที่สูงขึ้นตามมาตรฐาน MMLU ในงานการสร้างรหัสการปรับปรุงประสิทธิภาพมีความชัดเจนมากขึ้นแสดงให้เห็นว่ากลไกการเพิ่มประสิทธิภาพของ Muon มีส่วนในเชิงบวกต่อประสิทธิภาพการทำงาน

การใช้งานโครงการ Moonlight ที่ประสบความสำเร็จจะนำมาตรฐานใหม่มาสู่การฝึกอบรมแบบจำลองภาษาขนาดใหญ่ การใช้งานโอเพนซอร์สของ Muon Optimizer และการเปิดตัวรุ่นที่ผ่านการฝึกอบรมมาก่อนและจุดตรวจระดับกลางคาดว่าจะช่วยให้การวิจัยเพิ่มเติมเกี่ยวกับเทคนิคการเพิ่มประสิทธิภาพที่ปรับขนาดได้

GitHub: https: //github.com/moonshotai/moonlight? tab = readme-ov-file

HuggingFace: https: //huggingface.co/moonshotai/moonlight-16b-a3b

กระดาษ: https://github.com/moonshotai/moonlight/blob/master/moonlight.pdf

ประเด็นสำคัญ:

โมเดล Moonlight เป็นแบบจำลองส่วนผสมที่พัฒนาร่วมกันโดย Moonshot AI และ UCLA มีการกำหนดค่าพารามิเตอร์ 3 พันล้านและ 16 พันล้านและใช้คะแนน 5.7 ล้านล้านสำหรับการฝึกอบรม

Muon Optimizer ช่วยปรับปรุงประสิทธิภาพและความเสถียรของการฝึกอบรมแบบจำลองขนาดใหญ่อย่างมีนัยสำคัญผ่านวิธีการวนซ้ำของ Newton-Schultz และเทคโนโลยีการสลายตัวของน้ำหนัก

ผลลัพธ์เชิงประจักษ์แสดงให้เห็นว่าแสงจันทร์ดีกว่ารูปแบบการฝึกอบรม ADAMW แบบดั้งเดิมในหลาย ๆ งานแสดงความเข้าใจภาษาที่ดีขึ้นและความสามารถในการสร้างรหัส