В области искусственного интеллекта подготовка крупных языковых моделей (LLMS) стала важным направлением для продвижения технологического прогресса. Однако, поскольку размер модели и наборы данных продолжают расширяться, традиционные методы оптимизации, в частности, ADAMW, постепенно выявили свои ограничения. Исследователи сталкиваются с рядом проблем, таких как высокие вычислительные затраты и нестабильность в обучении, включая исчезновение или взрыв градиента, обновления несовместимых параметров параметров и высокие требования к ресурсам в распределенных средах. Следовательно, более эффективные и более стабильные методы оптимизации срочно необходимы для решения этих сложностей.

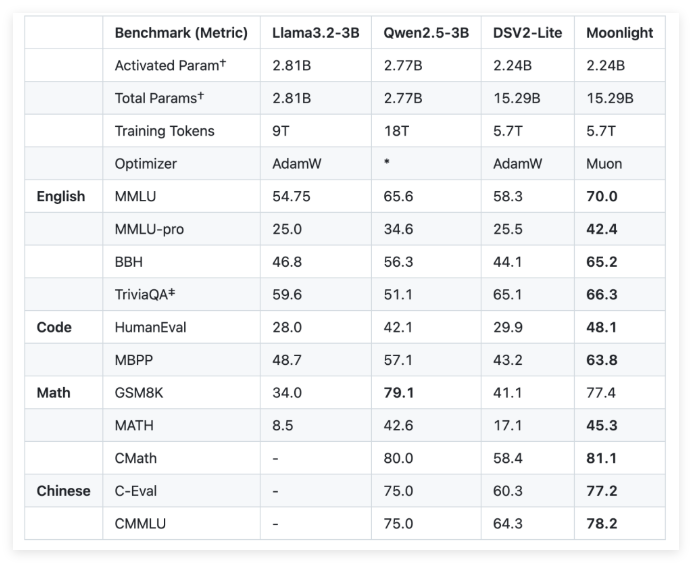

Чтобы решить эти проблемы, Moonshot AI (темная сторона Луны) и UCLA совместно разработали Moonlight, модель смеси экспертов (MOE) с использованием Muon Optimizer. Moonlight предоставляет две конфигурации: одна - параметр активации составляет 3 миллиарда, а другой - общий параметр 16 миллиардов, а для обучения использовались 5,7 триллиона марок. Инновация Muon Optimizer заключается в использовании итерационного метода Newton-Schultz для выполнения ортогонализации матрицы, чтобы обеспечить однородность градиентных обновлений в пространстве параметров модели. Это улучшение обеспечивает многообещающую альтернативу традиционному ADAMW, повышая эффективность обучения и стабильность.

С точки зрения технических деталей, Moonlight сделал два ключевых настройки для Muon Optimizer. Во -первых, технология распада веса вводится для контроля роста весов во время обучения крупных моделей и крупных маркеров. Во -вторых, амплитуда обновления каждого параметра откалибрована таким образом, чтобы оно масштабировано в соответствии с квадратным корнем максимального размера матрицы веса, тем самым достигая согласованности обновлений.

Посредством эмпирической оценки лунного света исследователи обнаружили, что его эффективность на промежуточных контрольных точках была лучше, чем традиционная учебная модель ADAMW. Например, в задаче по пониманию языка Moonlight заработал более высокие оценки на эталоне MMLU. В задачах генерации кода улучшение производительности является более очевидным, что указывает на то, что механизм оптимизации MUON положительно способствовал производительности задач.

Успешная реализация проекта Moonlight принесет новые стандарты для обучения крупных языковых моделей. Ожидается, что реализация MUON Optimizer и выпуск предварительно обученных моделей и промежуточных контрольных точек будут способствовать дальнейшему исследованию масштабируемых методов оптимизации.

github: https: //github.com/moonshotai/moonlight? tab = readme-ov-file

Huggingface: https: //huggingface.co/moonshotai/moonlight-16b-a3b

Бумага: https://github.com/moonshotai/moonlight/blob/master/moonlight.pdf

Ключевые моменты:

Модель Moonlight представляет собой модель смеси экспертов, совместно разработанную AI Moonshot AI и UCLA. Он предоставляет 3 миллиарда и 16 миллиардов конфигураций параметров и использует 5,7 триллиона марок для обучения.

Muon Optimizer значительно повышает эффективность и стабильность крупномасштабного модельного обучения с помощью метода итерации Newton-Schultz и технологии распада веса.

Эмпирические результаты показывают, что лунный свет лучше, чем традиционные тренировочные модели ADAMW по нескольким задачам, демонстрируя лучшее понимание языка и возможности генерации кода.