Auf dem Gebiet der künstlichen Intelligenz ist die Ausbildung von großsprachigen Modellen (LLMs) zu einer wichtigen Richtung, um den technologischen Fortschritt zu fördern. Da die Modellgröße und die Datensätze weiter erweitert werden, haben herkömmliche Optimierungsmethoden - insbesondere Adamw - allmählich ihre Einschränkungen aufgedeckt. Forscher stehen vor einer Reihe von Herausforderungen wie hohen Rechenkosten und Instabilität im Training, einschließlich des Verschwindens oder der Explosion, inkonsistenten Parametermatrix -Updates und hohen Ressourcenanforderungen in verteilten Umgebungen. Daher sind effizientere und stabilere Optimierungstechniken dringend erforderlich, um diese Komplexität zu bewältigen.

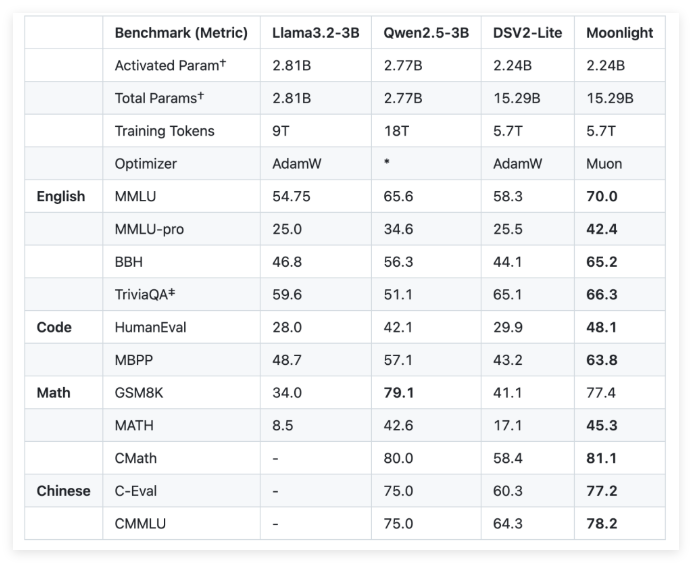

Um diese Herausforderungen zu bewältigen, entwickelte Moonshot AI (Dark Side of the Moon) und UCLA gemeinsam Moonlight, ein Mischungsmischungsmischung (MEE) mit dem Myon-Optimierer. Moonlight liefert zwei Konfigurationen: Einer ist der Aktivierungsparameter 3 Milliarden und der andere ist der Gesamtparameter 16 Milliarden und für das Training wurden 5,7 Billionen Markierungen verwendet. Die Innovation des Myon-Optimierers liegt in der Verwendung der iterativen Newton-Schultz-Methode zur Durchführung der Matrix-Orthogonalisierung, um die Einheitlichkeit der Gradientenaktualisierungen im Modellparameterraum zu gewährleisten. Diese Verbesserung bietet eine vielversprechende Alternative zu herkömmlichem ADAMW und verbessert die Schulungseffizienz und -stabilität.

In Bezug auf technische Details machte Moonlight zwei wichtige Optimierungen am Myon -Optimierer. Erstens wird die Gewichtsverschlüsselungstechnologie eingeführt, um das Wachstum von Gewichten während des Trainings großer Modelle und großer Marker zu kontrollieren. Zweitens wird die Aktualisierungsamplitude jedes Parameters so kalibriert, dass sie gemäß der quadratischen Wurzel der maximalen Dimension der Gewichtsmatrix skaliert wird, wodurch die Konsistenz von Aktualisierungen erreicht wird.

Durch eine empirische Bewertung von Mondlicht stellten die Forscher fest, dass ihre Leistung an Zwischenkontrollpunkten besser war als das traditionelle Adamw -Trainingsmodell. In der Aufgabe des Sprachverständnisses erzielte Moonlight beispielsweise höhere Punktzahlen für die MMLU -Benchmark. Bei Aufgaben der Codegenerierung ist die Leistungsverbesserung offensichtlicher, was darauf hinweist, dass der Optimierungsmechanismus von MUON positiv zur Aufgabenleistung beigetragen hat.

Die erfolgreiche Implementierung des Moonlight -Projekts bringt neue Standards für die Ausbildung von großsprachigen Modellen. Die Open-Source-Implementierung des Myon-Optimierers und die Freisetzung von vorgeborenen Modellen und Zwischenprüfpunkten sollen weitere Erforschung skalierbarer Optimierungstechniken erleichtern.

GitHub: https: //github.com/moonshotai/moonlight? tab = readme-ov-file

Huggingface: https: //huggingface.co/moonshotai/moonlight-16b-a3b

Papier: https://github.com/moonshotai/moonlight/blob/master/moonlight.pdf

Schlüsselpunkte:

Das Moonlight-Modell ist ein Mischungsmischungsmodell, das von Moonshot AI und UCLA gemeinsam entwickelt wurde. Es bietet 3 Milliarden und 16 Milliarden Parameterkonfigurationen und verwendet 5,7 Billionen Markierungen für das Training.

Der Myon-Optimierer verbessert die Effizienz und Stabilität des großflächigen Modelltrainings durch die Newton-Schultz-Iterationsmethode und die Gewichtsverfalltechnologie erheblich.

Empirische Ergebnisse zeigen, dass Moonlight besser als herkömmliche Adamw -Trainingsmodelle für mehrere Aufgaben ist und besseres Sprachverständnis und Funktionen der Codegenerierung zeigt.