Dans le domaine de l'intelligence artificielle, la formation de modèles de grands langues (LLM) est devenue une direction importante pour promouvoir les progrès technologiques. Cependant, à mesure que la taille du modèle et les ensembles de données continuent de se développer, les méthodes d'optimisation traditionnelles - en particulier l'ADAMW - ont progressivement révélé leurs limites. Les chercheurs sont confrontés à une série de défis tels que les coûts de calcul élevés et l'instabilité dans la formation, notamment la disparition de gradient ou l'explosion, les mises à jour de matrice de paramètres incohérentes et les exigences élevées en matière de ressources dans des environnements distribués. Par conséquent, des techniques d'optimisation plus efficaces et plus stables sont nécessaires d'urgence pour gérer ces complexités.

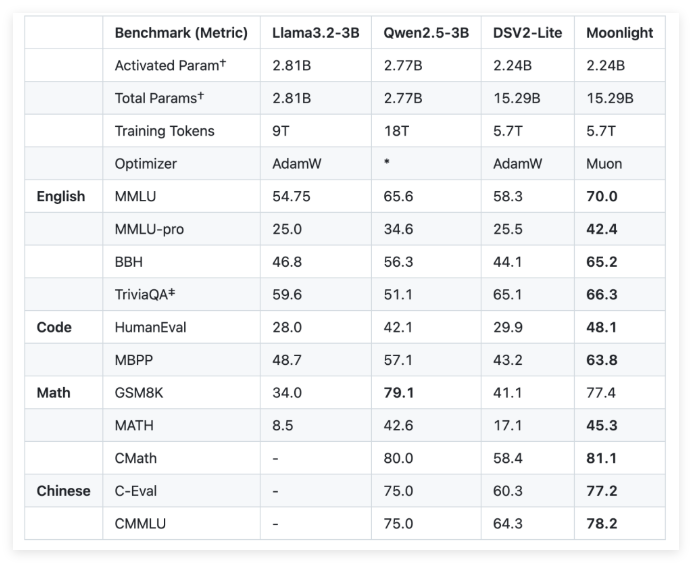

Pour relever ces défis, Moonshot Ai (côté sombre de la lune) et UCLA ont développé un moon au clair de lune, un modèle de mélange de l'expert (MOE) en utilisant l'optimiseur Muon. Moonlight fournit deux configurations: l'une est que le paramètre d'activation est de 3 milliards, et l'autre est le paramètre total est de 16 milliards et 5,7 billions de marques ont été utilisées pour la formation. L'innovation de l'optimiseur Muon réside dans l'utilisation de la méthode itérative de Newton-Schultz pour effectuer l'orthogonalisation de la matrice pour assurer l'uniformité des mises à jour du gradient dans l'espace des paramètres du modèle. Cette amélioration offre une alternative prometteuse à l'ADAMW traditionnel, améliorant l'efficacité de la formation et la stabilité.

En termes de détails techniques, Moonlight a fait deux ajustements clés à l'optimiseur Muon. Premièrement, la technologie de désintégration du poids est introduite pour contrôler la croissance des poids lors de l'entraînement de grands modèles et de grands marqueurs. Deuxièmement, l'amplitude de mise à jour de chaque paramètre est calibrée de sorte qu'elle est mise à l'échelle en fonction de la racine carrée de la dimension maximale de la matrice de poids, réalisant ainsi la cohérence des mises à jour.

Grâce à une évaluation empirique du clair de lune, les chercheurs ont constaté que ses performances aux points de contrôle intermédiaires étaient meilleures que le modèle de formation traditionnel ADAMW. Par exemple, dans la tâche de compréhension du langage, Moonlight a gagné des scores plus élevés sur la référence MMLU. Dans les tâches de génération de code, l'amélioration des performances est plus évidente, ce qui indique que le mécanisme d'optimisation de Muon a contribué positivement aux performances des tâches.

La mise en œuvre réussie du projet Moonlight apportera de nouvelles normes à la formation de modèles de grandes langues. La mise en œuvre open source de l'optimiseur Muon et la libération de modèles prélevés et de points de contrôle intermédiaires devraient faciliter des recherches supplémentaires sur les techniques d'optimisation évolutives.

github: https: //github.com/moonshotai/moonlight? tab = readme-ov-file

HuggingFace: https: //huggingface.co/moonshotai/moonlight-16b-a3b

Papier: https://github.com/moonshotai/moonlight/blob/master/moonlight.pdf

Points clés:

Le modèle au clair de lune est un modèle de mélange de l'expert développé conjointement par Moonshot AI et UCLA. Il fournit 3 milliards et 16 milliards de configurations de paramètres et utilise 5,7 billions de notes pour la formation.

L'optimiseur Muon améliore considérablement l'efficacité et la stabilité de la formation de modèles à grande échelle grâce à la méthode d'itération de Newton-Schultz et à la technologie de désintégration du poids.

Les résultats empiriques montrent que Moonlight est meilleur que les modèles de formation traditionnels ADAMW sur plusieurs tâches, montrant une meilleure compréhension du langage et des capacités de génération de code.