인공 지능 분야에서, LLMS (Lange Language Models)의 훈련은 기술 진보를 촉진하는 중요한 방향이되었습니다. 그러나 모델 크기와 데이터 세트가 계속 확장됨에 따라 전통적인 최적화 방법, 특히 ADAMW는 점차적으로 그 한계를 드러 냈습니다. 연구원들은 그라디언트 실종 또는 폭발, 일관되지 않은 매개 변수 매트릭스 업데이트 및 분산 환경의 높은 리소스 요구 사항을 포함하여 높은 계산 비용 및 교육 불안정성과 같은 일련의 과제에 직면 해 있습니다. 따라서 이러한 복잡성을 다루기 위해서는보다 효율적이고 안정적인 최적화 기술이 시급히 필요합니다.

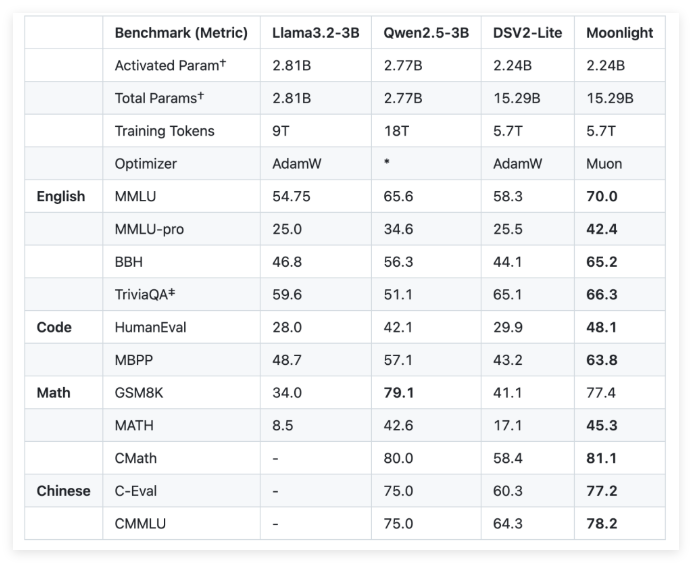

이러한 과제를 해결하기 위해 Moonshot AI (달의 어두운면)와 UCLA는 Muon Optimizer를 사용하는 혼합 엑스퍼트 (MOE) 모델 인 Moonlight를 공동으로 개발했습니다. Moonlight는 두 가지 구성을 제공합니다. 하나는 활성화 매개 변수가 30 억이고, 다른 하나는 총 매개 변수는 160 억, 5.7 조 점수는 훈련에 사용되었습니다. Muon Optimizer의 혁신은 Newton-Schultz 반복 방법을 사용하여 매트릭스 직교 화를 수행하여 모델 매개 변수 공간에서 그라디언트 업데이트의 균일 성을 보장합니다. 이러한 개선은 전통적인 ADAMW에 대한 유망한 대안을 제공하여 교육 효율성과 안정성을 향상시킵니다.

기술적 인 세부 사항 측면에서 Moonlight는 Muon Optimizer와 두 가지 주요 조정을했습니다. 먼저, 중량 붕괴 기술은 대형 모델과 대형 마커를 훈련하는 동안 가중치의 성장을 제어하기 위해 도입되었습니다. 둘째, 각 매개 변수의 업데이트 진폭은 가중치 매트릭스의 최대 치수의 제곱근에 따라 스케일링되도록 보정되어 업데이트의 일관성을 달성합니다.

연구자들은 달빛에 대한 경험적 평가를 통해 중간 체크 포인트에서의 성능이 전통적인 ADAMW 훈련 모델보다 낫다는 것을 발견했습니다. 예를 들어, 언어 이해 작업에서 Moonlight는 MMLU 벤치 마크에서 더 높은 점수를 얻었습니다. 코드 생성 작업에서 성능 향상이 더 분명하므로 Muon의 최적화 메커니즘이 작업 성능에 긍정적으로 기여했음을 나타냅니다.

Moonlight 프로젝트의 성공적인 구현은 대형 언어 모델의 훈련에 새로운 표준을 가져올 것입니다. Muon Optimizer의 오픈 소스 구현 및 미리 훈련 된 모델 및 중간 체크 포인트의 출시는 확장 가능한 최적화 기술에 대한 추가 연구를 촉진 할 것으로 예상됩니다.

github : https : //github.com/moonshotai/moonlight? tab = readme-ov-file

huggingface : https : //huggingface.co/moonshotai/moonlight-16b-a3b

종이 : https://github.com/moonshotai/moonlight/blob/master/moonlight.pdf

핵심 사항 :

Moonlight 모델은 Moonshot AI와 UCLA가 공동으로 개발 한 엑스퍼트 혼합 모델입니다. 30 억 및 160 억 파라미터 구성을 제공하며 교육을 위해 5.7 조 표시를 사용합니다.

Muon Optimizer는 Newton-Schultz 반복 방법 및 중량 붕괴 기술을 통해 대규모 모델 교육의 효율성과 안정성을 크게 향상시킵니다.

경험적 결과에 따르면 Moonlight는 여러 작업에 대한 전통적인 ADAMW 교육 모델보다 우수하여 언어 이해 및 코드 생성 기능을 보여줍니다.