ด้วยการพัฒนาอย่างรวดเร็วของเทคโนโลยีปัญญาประดิษฐ์รูปแบบภาษาขนาดใหญ่ (LLM) มีบทบาทสำคัญมากขึ้นในการใช้งานที่ทันสมัย ไม่ว่าจะเป็น chatbot, เครื่องกำเนิดรหัสหรืองานการประมวลผลภาษาธรรมชาติอื่น ๆ ความสามารถของ LLM ได้กลายเป็นไดรเวอร์หลัก อย่างไรก็ตามด้วยการขยายตัวของมาตราส่วนแบบจำลองอย่างต่อเนื่องและการเพิ่มขึ้นของความซับซ้อนปัญหาประสิทธิภาพในกระบวนการอนุมานได้ค่อยๆโดดเด่นโดยเฉพาะอย่างยิ่งเมื่อการประมวลผลข้อมูลขนาดใหญ่และการคำนวณที่ซับซ้อนการล่าช้าและการใช้ทรัพยากรได้กลายเป็นคอขวดที่จำเป็นต้องแก้ไข เร่งด่วน

ในฐานะที่เป็นองค์ประกอบหลักของ LLM กลไกความสนใจส่งผลโดยตรงต่อประสิทธิภาพการอนุมานของแบบจำลอง อย่างไรก็ตามกลไกการให้ความสนใจแบบดั้งเดิมเช่นการตั้งค่าแฟลชและการตั้งถิ่นฐานอย่างรวดเร็วมักจะทำงานได้ไม่ดีเมื่อต้องเผชิญกับปริมาณงานที่หลากหลายโหมดอินพุตแบบไดนามิกและข้อ จำกัด ของทรัพยากร GPU แฝงสูงคอขวดหน่วยความจำและการใช้ทรัพยากรต่ำได้ จำกัด ความสามารถในการปรับขนาดและความเร็วในการตอบสนองของการอนุมาน LLM อย่างจริงจัง ดังนั้นการพัฒนาโซลูชันที่มีประสิทธิภาพและยืดหยุ่นจึงกลายเป็นจุดสนใจของการวิจัยในปัจจุบัน

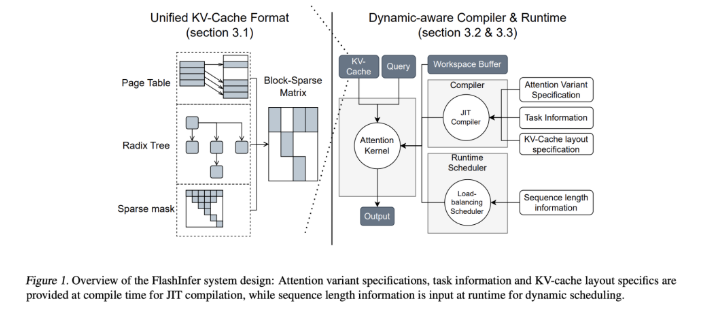

เพื่อจัดการกับความท้าทายนี้ทีมวิจัยจาก University of Washington, Nvidia, Perplexity AI และ Carnegie Mellon University ได้พัฒนา Flashinfer ร่วมกัน นี่คือห้องสมุดปัญญาประดิษฐ์และเครื่องกำเนิดเคอร์เนลที่ออกแบบมาโดยเฉพาะสำหรับการใช้เหตุผล LLM ออกแบบมาเพื่อเพิ่มประสิทธิภาพกลไกความสนใจหลายอย่างรวมถึงการตั้งค่าการแฟลชการตั้งถิ่นฐานที่น่าสนใจ ปรัชญาการออกแบบของ FlashInfer เน้นความยืดหยุ่นและประสิทธิภาพสามารถตอบสนองต่อความท้าทายที่สำคัญในการให้บริการการอนุมาน LLM ได้อย่างมีประสิทธิภาพและจัดหาโซลูชั่นที่เป็นประโยชน์สำหรับการอนุมานในรูปแบบภาษาขนาดใหญ่

คุณสมบัติทางเทคนิคหลักของ FlashInfer รวมถึงแง่มุมดังต่อไปนี้: ก่อนอื่นให้การสนับสนุนเคอร์เนลความสนใจที่ครอบคลุมซึ่งครอบคลุมกลไกต่าง ๆ เช่นการเติมก่อนการถอดรหัสและความสนใจเพิ่มเติม ประสิทธิภาพของการร้องขอและสถานการณ์บริการแบทช์ ประการที่สองผ่านความสนใจแบบสืบค้นแบบจัดกลุ่ม (GQA) และการฝังตำแหน่งการหมุน (เชือก) ความสนใจ FlashInfer บรรลุการปรับปรุงประสิทธิภาพที่สำคัญในการถอดรหัสที่รวดเร็วยาวเร็วกว่าความสนใจของหน้า VLLM 31 เท่า นอกจากนี้ตัวกำหนดตารางการปรับสมดุลโหลดแบบไดนามิกของ FlashInfer สามารถปรับแบบไดนามิกตามการเปลี่ยนแปลงอินพุตลดเวลาว่างของ GPU และให้แน่ใจว่ามีการใช้ทรัพยากรอย่างมีประสิทธิภาพ ความเข้ากันได้กับกราฟ CUDA ช่วยเพิ่มการบังคับใช้ในสภาพแวดล้อมการผลิต

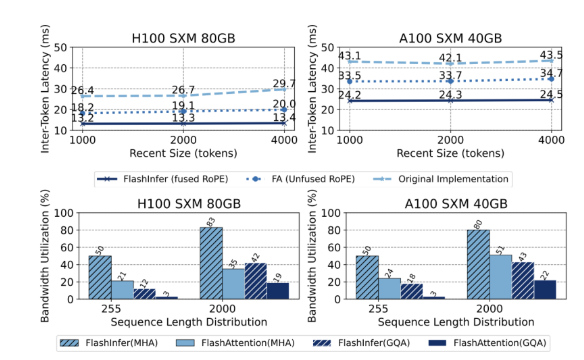

ในแง่ของประสิทธิภาพ FlashInfer ทำงานได้ดีในหลายเกณฑ์มาตรฐานโดยเฉพาะอย่างยิ่งเมื่อต้องรับมือกับการอนุมานบริบทที่ยาวนานและงานการสร้างแบบคู่ขนานลดเวลาแฝงอย่างมีนัยสำคัญ บน Nvidia H100 GPU FlashInfer จะได้รับการเพิ่มความเร็ว 13-17% ในงานการสร้างแบบคู่ขนาน ตัวกำหนดตารางเวลาแบบไดนามิกและแกนที่ดีที่สุดปรับปรุงแบนด์วิดท์และการใช้ประโยชน์จากฟลอพอย่างมีนัยสำคัญทำให้การใช้ประโยชน์จากทรัพยากร GPU อย่างมีประสิทธิภาพไม่ว่าจะเป็นความยาวไม่สม่ำเสมอหรือสม่ำเสมอ ข้อดีเหล่านี้ทำให้ FlashInfer เป็นเครื่องมือสำคัญในการส่งเสริมการพัฒนากรอบการบริการ LLM

ในฐานะที่เป็นโครงการโอเพนซอร์ส FlashInfer ไม่เพียง แต่ให้บริการโซลูชั่นที่มีประสิทธิภาพสำหรับความท้าทายด้านการใช้เหตุผล LLM แต่ยังส่งเสริมการทำงานร่วมกันและนวัตกรรมเพิ่มเติมในชุมชนการวิจัย ความสามารถในการออกแบบและการรวมที่ยืดหยุ่นช่วยให้สามารถปรับให้เข้ากับการเปลี่ยนแปลงความต้องการโครงสร้างพื้นฐาน AI และทำให้มั่นใจได้ว่าจะอยู่ข้างหน้าความเป็นผู้นำในการจัดการกับความท้าทายที่เกิดขึ้นใหม่ ด้วยความพยายามร่วมกันของชุมชนโอเพ่นซอร์ส FlashInfer คาดว่าจะมีบทบาทสำคัญในการพัฒนาเทคโนโลยี AI ในอนาคต

ทางเข้าโครงการ: https://github.com/flashinfer-ai/flashinfer

ประเด็นสำคัญ:

FlashInfer เป็นห้องสมุดปัญญาประดิษฐ์ที่เพิ่งเปิดตัวใหม่ที่ออกแบบมาสำหรับการใช้เหตุผลแบบจำลองภาษาขนาดใหญ่และสามารถปรับปรุงประสิทธิภาพได้อย่างมีนัยสำคัญ

ห้องสมุดนี้รองรับกลไกความสนใจหลายอย่างปรับการใช้ทรัพยากร GPU และลดเวลาแฝงการอนุมาน

ในฐานะโครงการโอเพ่นซอร์ส FlashInfer ยินดีต้อนรับนักวิจัยให้เข้าร่วมเพื่อส่งเสริมนวัตกรรมและการพัฒนาโครงสร้างพื้นฐาน AI