Благодаря быстрому развитию технологий искусственного интеллекта, модель большой языка (LLM) играет все более важную роль в современных приложениях. Будь то чат-бот, генератор кодов или другие задачи на основе обработки естественного языка, возможности LLM стали основным драйвером. Однако при непрерывном расширении масштаба моделей и увеличении сложности проблемы с эффективностью в процессе вывода постепенно становятся заметными, особенно при обработке крупномасштабных данных и сложных расчетов, задержка и потребление ресурсов стали узкими местами, которые необходимо решить срочно.

В качестве основного компонента LLM механизм внимания напрямую влияет на эффективность вывода модели. Тем не менее, традиционные механизмы внимания, такие как вспышка и разжигание, часто работают плохо, когда сталкиваются с разнообразными рабочими нагрузками, динамическими режимами ввода и ограничениями ресурсов GPU. Высокая задержка, узкие места памяти и низкое использование ресурсов серьезно ограничили масштабируемость и скорость отклика вывода LLM. Следовательно, разработка эффективного и гибкого решения стало в центре внимания.

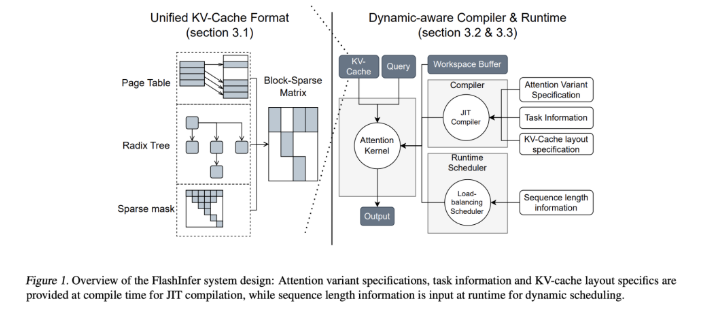

Чтобы решить эту проблему, исследовательские группы из Университета Вашингтона, Нвидия, AI Displexity AI и Университета Карнеги -Меллона, совместно разработали Flashinfer. Это библиотека искусственного интеллекта и генератор ядра, разработанный специально для рассуждений LLM, предназначенных для оптимизации множества механизмов внимания, включая вспышку, процентрирование, паджиатттификацию и выборку с помощью высокопроизводительных сердечников GPU. Философия дизайна FlashInfer подчеркивает гибкость и эффективность, может эффективно реагировать на ключевые проблемы в услугах LLM вывода и предоставляет практические решения для вывода в крупномасштабных языковых моделях.

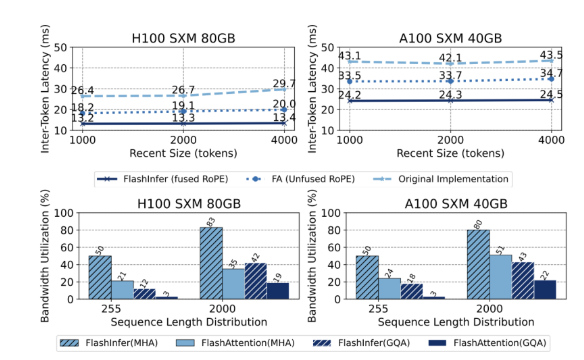

Основные технические особенности FlashInfer включают в себя следующие аспекты: во-первых, он обеспечивает всестороннюю поддержку ядра, охватывающая различные механизмы, такие как предварительное заполнение, декодирование и дополнительное внимание. Производительность сценариев обслуживания запросов и пакетов. Во -вторых, благодаря сгруппированному вниманию запроса (GQA) и слиянию вращательного положения, встраивающего (веревка), FlashInfer достигает значительных улучшений производительности при длительном быстроте декодировании, в 31 раза быстрее, чем внимание страницы VLLM. Кроме того, планировщик динамической балансировки нагрузки Flashinfer может динамически регулировать в соответствии с входными изменениями, сокращать время простоя GPU и обеспечить эффективное использование ресурсов. Его совместимость с графиками CUDA еще больше повышает его применимость в производственных средах.

С точки зрения производительности, FlashInfer хорошо работает в нескольких критериях, особенно при работе с длинным контекстом и параллельными задачами генерации, значительно снижая задержку. На графическом процессоре Nvidia H100 Flashinfer достигает повышения скорости на 13-17% в параллельных задачах генерации. Его динамический планировщик и оптимизированное ядро значительно улучшают использование полосы пропускания и провалов, что позволяет эффективно использовать ресурсы графических процессоров, будь то неровные или равномерные длины последовательности. Эти преимущества делают FlashInfer важным инструментом для содействия разработке платформы обслуживания LLM.

В качестве проекта с открытым исходным кодом FlashInfer не только предоставляет эффективные решения проблем рассуждений LLM, но и поощряет дальнейшее сотрудничество и инновации в исследовательском сообществе. Его гибкие возможности дизайна и интеграции позволяют адаптироваться к изменению потребностей в инфраструктуре ИИ и гарантировать, что они остаются впереди своего лидерства в решении возникающих проблем. Ожидается, что благодаря совместным усилиям сообщества с открытым исходным кодом, Flashinfer будет играть более важную роль в будущем разработке технологий ИИ.

Вход в проект: https://github.com/flashinfer-ai/flashinfer

Ключевые моменты:

FlashInfer - это недавно выпущенная библиотека искусственного интеллекта, предназначенная для рассуждений с большими языками и может значительно повысить эффективность.

Эта библиотека поддерживает множество механизмов внимания, оптимизирует использование ресурсов GPU и снижает задержку вывода.

В качестве проекта с открытым исходным кодом Flashinfer приветствует исследователей для участия в продвижении инноваций и развития инфраструктуры ИИ.