Dengan perkembangan cepat teknologi kecerdasan buatan, model bahasa besar (LLM) memainkan peran yang semakin penting dalam aplikasi modern. Apakah itu chatbot, generator kode, atau tugas berbasis bahasa alami lainnya, kemampuan LLM telah menjadi driver inti. Namun, dengan ekspansi skala model yang berkelanjutan dan peningkatan kompleksitas, masalah efisiensi dalam proses inferensi secara bertahap menjadi menonjol, terutama ketika memproses data skala besar dan perhitungan yang kompleks, keterlambatan dan konsumsi sumber daya telah menjadi hambatan yang perlu dipecahkan sangat.

Sebagai komponen inti LLM, mekanisme perhatian secara langsung mempengaruhi efisiensi inferensi model. Namun, mekanisme perhatian tradisional seperti flashattensi dan sparseattention sering berkinerja buruk ketika dihadapkan dengan beragam beban kerja, mode input dinamis, dan kendala sumber daya GPU. Latensi tinggi, hambatan memori dan pemanfaatan sumber daya yang rendah telah secara serius membatasi skalabilitas dan kecepatan respons inferensi LLM. Oleh karena itu, mengembangkan solusi yang efisien dan fleksibel telah menjadi fokus penelitian saat ini.

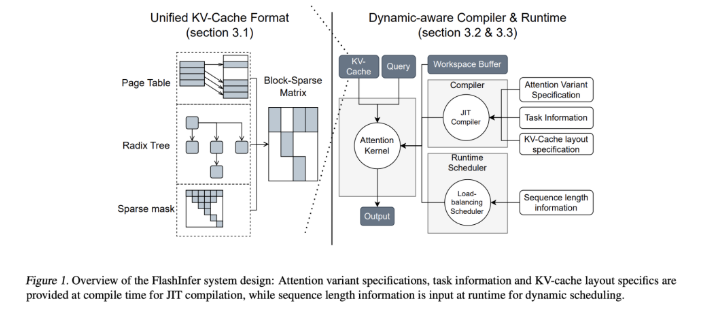

Untuk mengatasi tantangan ini, tim peneliti dari University of Washington, NVIDIA, AI yang salah dan Universitas Carnegie Mellon bersama -sama mengembangkan FlashInfer. Ini adalah perpustakaan kecerdasan buatan dan generator kernel yang dirancang khusus untuk penalaran LLM, yang dirancang untuk mengoptimalkan mekanisme perhatian berganda, termasuk flashattention, sparseattention, pageattention dan pengambilan sampel melalui inti GPU berkinerja tinggi. Filosofi desain Flashinfer menekankan fleksibilitas dan efisiensi, dapat secara efektif menanggapi tantangan utama dalam layanan inferensi LLM, dan memberikan solusi praktis untuk inferensi dalam model bahasa skala besar.

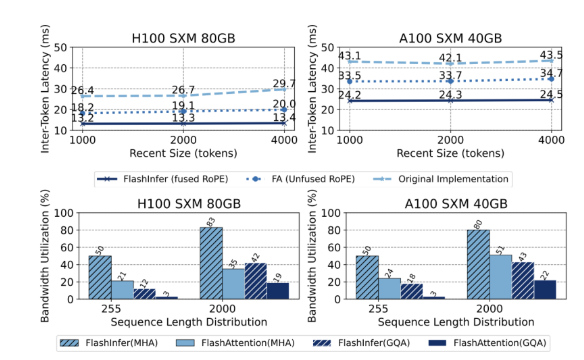

Fitur teknis inti dari FlashInfer mencakup aspek-aspek berikut: Pertama, ia memberikan dukungan kernel perhatian yang komprehensif, yang mencakup berbagai mekanisme seperti pra-pengisian, decoding dan perhatian tambahan. Kinerja skenario permintaan dan layanan batch. Kedua, melalui Perhatian Kueri yang dikelompokkan (GQA) dan Fusion Rotational Position Embedding (Rope) perhatian, FlashInfer mencapai peningkatan kinerja yang signifikan dalam decoding yang cepat, 31 kali lebih cepat daripada perhatian halaman VLLM. Selain itu, penjadwal penyeimbang beban dinamis FlashInfer dapat menyesuaikan secara dinamis sesuai dengan perubahan input, mengurangi waktu idle GPU dan memastikan penggunaan sumber daya yang efisien. Kompatibilitasnya dengan grafik CUDA lebih lanjut meningkatkan penerapannya di lingkungan produksi.

Dalam hal kinerja, FlashInfer berkinerja baik dalam berbagai tolok ukur, terutama ketika berhadapan dengan inferensi konteks panjang dan tugas generasi paralel, secara signifikan mengurangi latensi. Pada GPU NVIDIA H100, FlashInfer mencapai peningkatan kecepatan 13-17% dalam tugas generasi paralel. Penjadwal dinamis dan inti yang dioptimalkan secara signifikan meningkatkan pemanfaatan bandwidth dan flop, memungkinkan pemanfaatan sumber daya GPU yang efisien baik dalam panjang urutan yang tidak merata atau seragam. Keuntungan ini menjadikan FlashInfer alat penting untuk mempromosikan pengembangan kerangka kerja layanan LLM.

Sebagai proyek open source, FlashInfer tidak hanya memberikan solusi yang efisien untuk tantangan penalaran LLM, tetapi juga mendorong kolaborasi dan inovasi lebih lanjut dalam komunitas penelitian. Kemampuan desain dan integrasi yang fleksibel memungkinkannya untuk beradaptasi dengan perubahan kebutuhan infrastruktur AI dan memastikannya tetap di depan kepemimpinannya dalam mengatasi tantangan yang muncul. Melalui upaya bersama komunitas open source, FlashInfer diharapkan memainkan peran yang lebih penting dalam pengembangan teknologi AI di masa depan.

Pintu masuk proyek: https://github.com/flashinfer-ai/flashinfer

Poin -Poin Kunci:

FlashInfer adalah perpustakaan kecerdasan buatan yang baru dirilis yang dirancang untuk penalaran model bahasa besar dan dapat secara signifikan meningkatkan efisiensi.

Perpustakaan ini mendukung berbagai mekanisme perhatian, mengoptimalkan pemanfaatan sumber daya GPU dan mengurangi latensi inferensi.

Sebagai proyek open source, FlashInfer menyambut para peneliti untuk berpartisipasi untuk mempromosikan inovasi dan pengembangan infrastruktur AI.