Mit der raschen Entwicklung der Technologie für künstliche Intelligenz spielt das LLM (Language Language Model) eine immer wichtigere Rolle in modernen Anwendungen. Unabhängig davon, ob es sich um einen Chatbot, einen Codegenerator oder eine andere auf natürlichen Sprachverarbeitungsbasis basierende Aufgaben handelt, sind die Funktionen von LLM zum Kerntreiber geworden. Angesichts der kontinuierlichen Ausdehnung der Modellskala und der Zunahme der Komplexität sind die Effizienzprobleme im Inferenzprozess allmählich herausgestellt, insbesondere bei der Verarbeitung großer Daten und komplexen Berechnungen, Verzögerungen und Ressourcenverbrauch sind zu Engpässen geworden, die gelöst werden müssen dringend.

Als Kernkomponente von LLM wirkt sich der Aufmerksamkeitsmechanismus direkt auf die Inferenz -Effizienz des Modells aus. Traditionelle Aufmerksamkeitsmechanismen wie Flashattention und Sparstention funktionieren jedoch häufig schlecht, wenn sie mit verschiedenen Arbeitsbelastungen, dynamischen Eingabemodi und GPU -Ressourcenbeschränkungen konfrontiert sind. Hohe Latenz, Speicher Engpässe und niedrige Ressourcenauslastung haben die Skalierbarkeit und Reaktionsgeschwindigkeit der LLM -Inferenz ernsthaft eingeschränkt. Die Entwicklung einer effizienten und flexiblen Lösung ist daher der Schwerpunkt der aktuellen Forschung geworden.

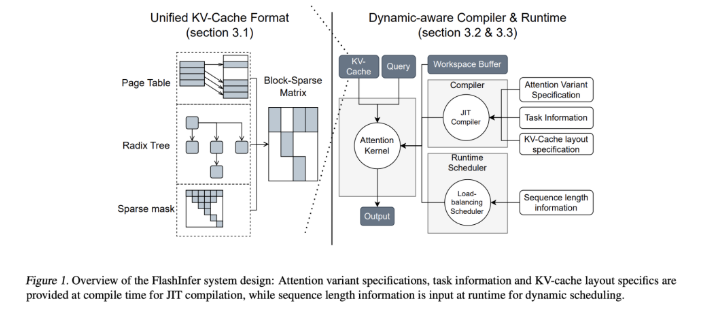

Um diese Herausforderung anzugehen, entwickelten Forschungsteams der University of Washington, Nvidia, der Verwirrigkeit AI und der Carnegie Mellon University gemeinsam FlashInfer. Dies ist eine künstliche Intelligenzbibliothek und ein Kernelgenerator, das speziell für LLM-Argumentation entwickelt wurde und die mehrere Aufmerksamkeitsmechanismen optimiert, einschließlich Flashattention, Sparseattention, Pagetention und Probenahme durch leistungsstarke GPU-Kerne. Die Designphilosophie von FlashInfer betont Flexibilität und Effizienz, kann effektiv auf wichtige Herausforderungen in LLM-Inferenzdiensten reagieren und praktische Lösungen für Inferenz in groß angelegten Sprachmodellen bietet.

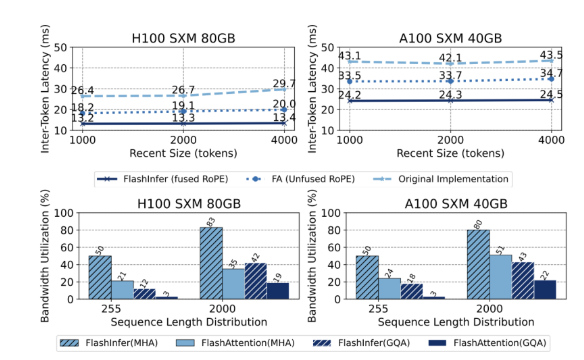

Die technischen Kernmerkmale von FlashInfer umfassen die folgenden Aspekte: Erstens bietet es eine umfassende Aufmerksamkeits-Kernel-Unterstützung, die verschiedene Mechanismen wie Vorfüllung, Dekodierung und zusätzliche Aufmerksamkeit abdeckt. Leistung von Anfrage- und Batch -Service -Szenarien. Zweitens erreicht FlashInfer durch gruppierte Aufmerksamkeit für die Aufmerksamkeit (GQA) und die Aufmerksamkeit der Rotationsposition (Seil) erhebliche Leistungsverbesserungen bei der langen Schnelldekodierung, 31 -mal schneller als die Aufmerksamkeit von VllMs Seitenaufmerksamkeit. Darüber hinaus kann der dynamische Lastausgleichsplaner von FlashInfer entsprechend den Eingangsänderungen dynamisch einstellen, die Leerlaufzeit des GPU verkürzen und eine effiziente Verwendung von Ressourcen sicherstellen. Seine Kompatibilität mit CUDA -Diagrammen verbessert seine Anwendbarkeit in Produktionsumgebungen weiter.

In Bezug auf die Leistung spielt FlashInfer in mehreren Benchmarks eine gute Leistung, insbesondere wenn es sich um lange Kontextinferenz- und Parallelerzeugungsaufgaben handelt, was die Latenz erheblich verringert. Bei NVIDIA H100 GPU erreicht FlashInfer einen Geschwindigkeitsschub von 13-17% bei parallelen Erzeugungsaufgaben. Sein dynamischer Zeitplaner und der optimierte Kern verbessern die Bandbreite und die Flop -Nutzung signifikant und ermöglichen eine effiziente Nutzung von GPU -Ressourcen, ob in ungleichmäßigen oder gleichmäßigen Sequenzlängen. Diese Vorteile machen FlashInfer zu einem wichtigen Instrument zur Förderung der Entwicklung des LLM -Service -Frameworks.

Als Open -Source -Projekt bietet FlashInfer nicht nur effiziente Lösungen für LLM -Argumentationsherausforderungen, sondern fördert auch eine weitere Zusammenarbeit und Innovation in der Forschungsgemeinschaft. Die flexiblen Design- und Integrationsfunktionen ermöglichen es ihm, sich an die sich ändernden Anforderungen an die KI -Infrastruktur anzupassen und sicherzustellen, dass sie der Führung bei der Bewältigung der aufkommenden Herausforderungen weiter bleibt. Durch die gemeinsamen Bemühungen der Open -Source -Community wird von FlashInfer eine wichtigere Rolle bei der zukünftigen Entwicklung der KI -Technologie spielen.

Projekteingang: https://github.com/flashinfer-ai/flashinfer

Schlüsselpunkte:

FlashInfer ist eine neu veröffentlichte Bibliothek für künstliche Intelligenz, die für das Denken von großer Sprache entwickelt wurde und die Effizienz erheblich verbessern kann.

Diese Bibliothek unterstützt mehrere Aufmerksamkeitsmechanismen, optimiert die Nutzung der GPU -Ressourcen und verringert die Inferenzlatenz.

Als Open -Source -Projekt begrüßt FlashInfer die Forscher, um die Innovation und Entwicklung der AI -Infrastruktur zu fördern.