Con el rápido desarrollo de la tecnología de inteligencia artificial, el modelo de lenguaje grande (LLM) juega un papel cada vez más importante en las aplicaciones modernas. Ya sea que se trate de un chatbot, un generador de código u otras tareas basadas en el procesamiento del lenguaje natural, las capacidades de LLM se han convertido en el controlador central. Sin embargo, con la expansión continua de la escala del modelo y el aumento de la complejidad, los problemas de eficiencia en el proceso de inferencia se han vuelto prominentes gradualmente, especialmente cuando se procesan datos a gran escala y cálculos complejos, retraso y consumo de recursos se han convertido en cuellos de botella que deben resolverse urgentemente.

Como componente central de LLM, el mecanismo de atención afecta directamente la eficiencia de inferencia del modelo. Sin embargo, los mecanismos de atención tradicionales, como la flashatención y la escasezeación, a menudo funcionan mal cuando se enfrentan a diversas cargas de trabajo, modos de entrada dinámicos y limitaciones de recursos de GPU. Alta latencia, cuellos de botella de memoria y baja utilización de recursos han restringido seriamente la escalabilidad y la velocidad de respuesta de la inferencia de LLM. Por lo tanto, desarrollar una solución eficiente y flexible se ha convertido en el foco de la investigación actual.

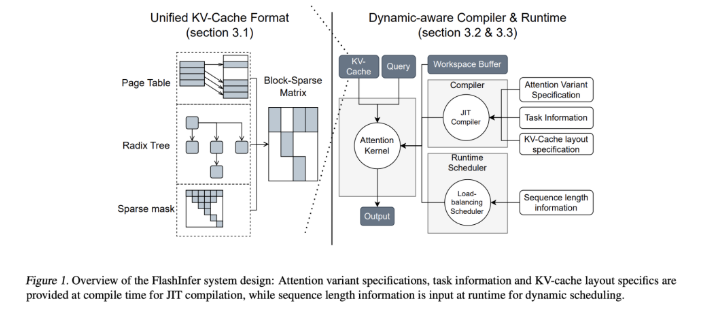

Para abordar este desafío, los equipos de investigación de la Universidad de Washington, Nvidia, Perpleity AI y Carnegie Mellon University desarrollaron conjuntamente Flashinfer. Esta es una biblioteca de inteligencia artificial y un generador de núcleo diseñado específicamente para el razonamiento de LLM, diseñado para optimizar múltiples mecanismos de atención, que incluyen flashatencion, escasezeattention, pageattention y muestreo a través de núcleos de GPU de alto rendimiento. La filosofía de diseño de Flashinfer enfatiza la flexibilidad y la eficiencia, puede responder efectivamente a los desafíos clave en los servicios de inferencia de LLM y proporciona soluciones prácticas para la inferencia en los modelos de lenguaje a gran escala.

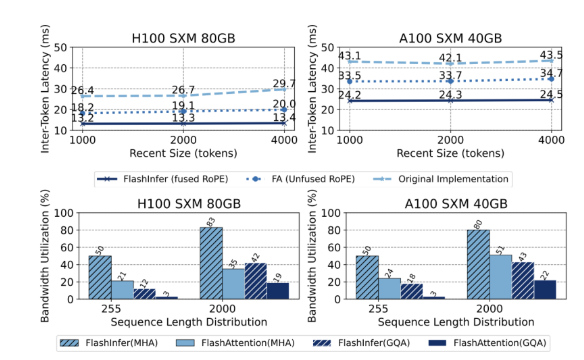

Las características técnicas centrales de FlashInfer incluyen los siguientes aspectos: Primero, proporciona soporte de núcleo de atención integral, que cubre varios mecanismos, como el repleto, la decodificación y la atención adicional. Rendimiento de la solicitud y escenarios de servicio por lotes. En segundo lugar, a través de la atención de consulta agrupada (GQA) y la atención de incrustación de posición rotacional fusionada (cuerda), FlashInfer logra mejoras significativas de rendimiento en la decodificación larga de inmediato, 31 veces más rápido que la atención de la página de VLLM. Además, el planificador de equilibrio de carga dinámico de Flashinfer puede ajustar dinámicamente de acuerdo con los cambios de entrada, reducir el tiempo de inactividad de GPU y garantizar el uso eficiente de los recursos. Su compatibilidad con los gráficos CUDA mejora aún más su aplicabilidad en los entornos de producción.

En términos de rendimiento, FlashInfer funciona bien en múltiples puntos de referencia, especialmente cuando se trata de una larga inferencia de contexto y tareas de generación paralela, reduciendo significativamente la latencia. En NVIDIA H100 GPU, FlashInfer logra un aumento de velocidad del 13-17% en las tareas de generación paralela. Su planificador dinámico y su núcleo optimizado mejoran significativamente el ancho de banda y la utilización del flop, lo que permite una utilización eficiente de los recursos de GPU, ya sea en longitudes de secuencia desiguales o uniformes. Estas ventajas hacen que Flashinfer sea una herramienta importante para promover el desarrollo del marco de servicio LLM.

Como proyecto de código abierto, FlashInfer no solo proporciona soluciones eficientes a los desafíos de razonamiento de LLM, sino que también fomenta una mayor colaboración e innovación en la comunidad de investigación. Sus capacidades flexibles de diseño e integración le permiten adaptarse a las cambiantes necesidades de infraestructura de IA y garantizar que se mantenga por delante de su liderazgo para abordar los desafíos emergentes. A través de los esfuerzos conjuntos de la comunidad de código abierto, se espera que Flashinfer juegue un papel más importante en el desarrollo futuro de la tecnología de IA.

Entrada del proyecto: https://github.com/flashinfer-ai/flashinfer

Puntos clave:

FlashInfer es una biblioteca de inteligencia artificial recientemente lanzada diseñada para un razonamiento de modelos de lenguaje grande y puede mejorar significativamente la eficiencia.

Esta biblioteca admite múltiples mecanismos de atención, optimiza la utilización de los recursos de GPU y reduce la latencia de inferencia.

Como proyecto de código abierto, FlashInfer da la bienvenida a los investigadores a participar para promover la innovación y el desarrollo de la infraestructura de IA.