การฝึกอบรมและการเพิ่มประสิทธิภาพของแบบจำลองภาษาขนาดใหญ่ (LLMS) เป็นความท้าทายที่สำคัญในด้านปัญญาประดิษฐ์ วิธีการฝึกอบรมที่มีประสิทธิภาพและการส่งออกแบบจำลองที่สอดคล้องกับคุณค่าของมนุษย์นั้นสำคัญมาก การเรียนรู้การเสริมแรงและข้อเสนอแนะของมนุษย์ (RLHF) เป็นวิธีการฝึกอบรม LLM หลัก เพื่อจุดประสงค์นี้ทีมงาน Big Model Bytedance Doubao เปิดกรอบ RLHF ที่เรียกว่า Hybridflow โดยมีวัตถุประสงค์เพื่อแก้ปัญหาเหล่านี้และนำความเป็นไปได้ใหม่ ๆ มาสู่การฝึกอบรม LLM ด้วยการออกแบบที่เป็นนวัตกรรมกรอบนี้ช่วยเพิ่มประสิทธิภาพและความยืดหยุ่นของการฝึกอบรม LLM

โมเดลขนาดใหญ่ (LLM) เช่น GPT และ LLAMA ได้ทำการปฏิวัติในด้านปัญญาประดิษฐ์ แต่วิธีการฝึกอบรมแบบจำลองขนาดใหญ่เหล่านี้อย่างมีประสิทธิภาพและทำให้พวกเขาสอดคล้องกับคุณค่าของมนุษย์ยังคงเป็นปัญหาที่ยาก

การเรียนรู้การเสริมแรงและข้อเสนอแนะของมนุษย์ (RLHF) ถูกนำมาใช้อย่างกว้างขวางในช่วงไม่กี่ปีที่ผ่านมาเป็นวิธีการฝึกอบรม LLM ที่สำคัญ แต่กรอบ RLHF แบบดั้งเดิมมีข้อ จำกัด ด้านความยืดหยุ่นประสิทธิภาพและความยืดหยุ่น

เพื่อแก้ปัญหาเหล่านี้ให้ Open Source Team Open Source ของ Framework RLHF ที่เรียกว่า HybridFlow นำความเป็นไปได้ใหม่ ๆ มาสู่การฝึกอบรม LLM

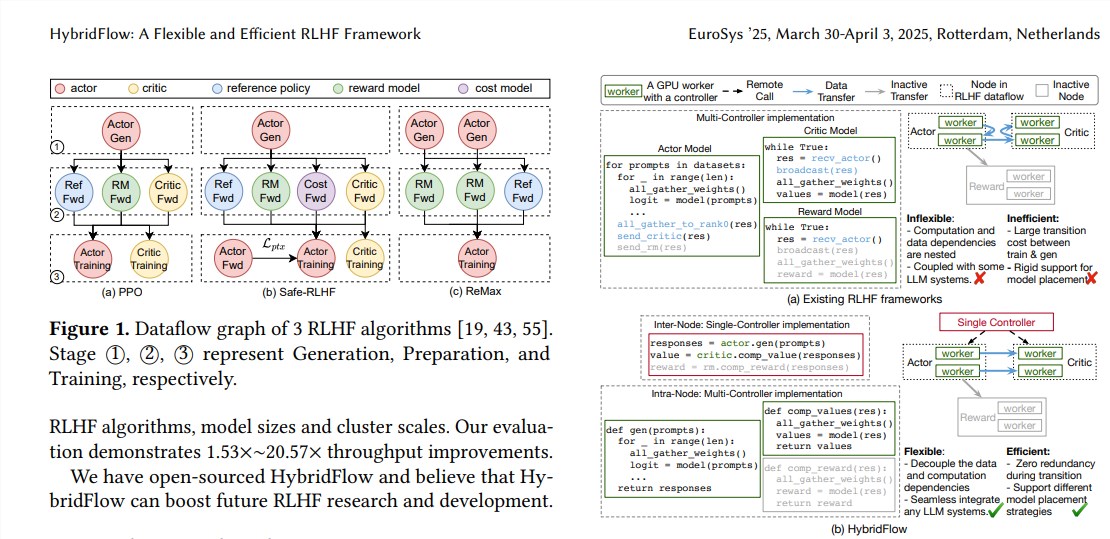

RLHF มักจะประกอบด้วยสามขั้นตอน:

ขั้นแรกรูปแบบนักแสดงสร้างข้อความตามพรอมต์อินพุต;

ในที่สุดผลการประเมินเหล่านี้จะใช้ในการฝึกอบรมแบบจำลองนักแสดงเพื่อสร้างข้อความที่สอดคล้องกับการตั้งค่าของมนุษย์มากขึ้น เฟรมเวิร์ก RLHF แบบดั้งเดิมมักจะใช้คอนโทรลเลอร์เดียวเพื่อจัดการสตรีมข้อมูลทั้งหมด แต่นี่ไม่มีประสิทธิภาพสำหรับ LLM ที่ต้องใช้การคำนวณแบบกระจาย

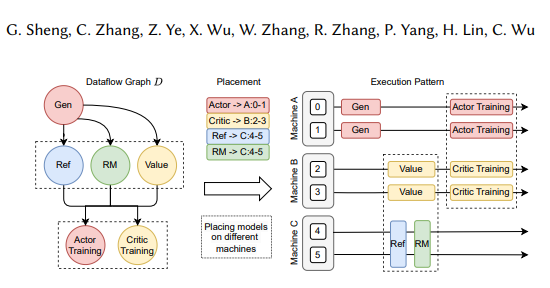

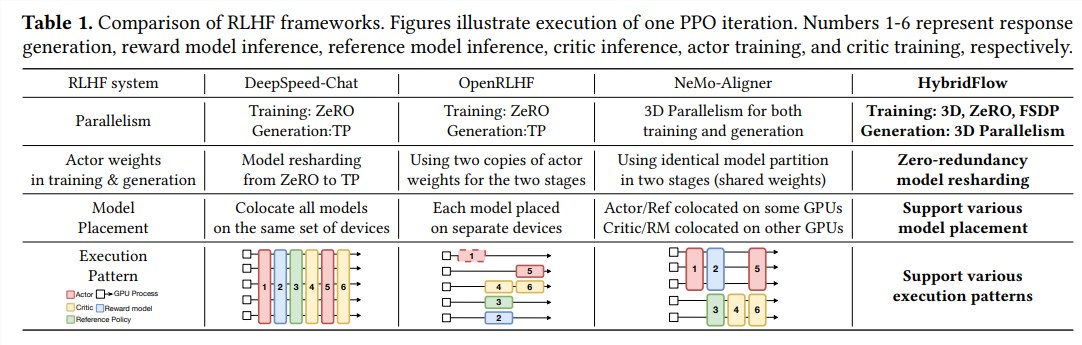

เฟรมเวิร์กไฮบริดโฟลว์ได้รวมโหมดเดี่ยวและหลายตัวควบคุมอย่างสร้างสรรค์และ decouples คอมพิวเตอร์ที่ซับซ้อนและการพึ่งพาข้อมูลผ่านการออกแบบ API แบบลำดับชั้นช่วยให้การเป็นตัวแทนที่ยืดหยุ่นและการดำเนินการอย่างมีประสิทธิภาพของสตรีมข้อมูล RLHF

ข้อดีของลูกผสมส่วนใหญ่สะท้อนให้เห็นในสามด้านต่อไปนี้:

การสนับสนุนที่ยืดหยุ่นสำหรับอัลกอริทึมและรุ่น RLHF ที่หลากหลาย: HybridFlow ให้ API แบบแยกส่วนซึ่งผู้ใช้สามารถนำไปใช้และขยายอัลกอริทึม RLHF ที่หลากหลายเช่น PPO, REMAX และ Safe-RLHF

การปรับโครงสร้างน้ำหนักแบบจำลองที่มีประสิทธิภาพ: ส่วนประกอบ 3D-hybridEngine รองรับโมเดลนักแสดงเพื่อจัดระเบียบน้ำหนักแบบจำลองใหม่อย่างมีประสิทธิภาพในระหว่างขั้นตอนการฝึกอบรมและการสร้างลดความซ้ำซ้อนของหน่วยความจำและค่าใช้จ่ายในการสื่อสาร

การปรับใช้โมเดลอัตโนมัติและการเลือกนโยบายแบบขนาน: ส่วนประกอบการแมปอัตโนมัติสามารถแมปโมเดลกับอุปกรณ์ต่าง ๆ โดยอัตโนมัติตามการโหลดแบบจำลองและการพึ่งพาข้อมูลและเลือกนโยบายคู่ขนานที่ดีที่สุดซึ่งทำให้กระบวนการปรับใช้แบบจำลองง่ายขึ้นและปรับปรุงประสิทธิภาพการฝึกอบรม

ผลการทดลองแสดงให้เห็นว่าปริมาณงานของไฮบริดโฟลว์เพิ่มขึ้นอย่างมีนัยสำคัญเมื่อใช้อัลกอริทึม RLHF ต่างๆสูงสุด 20.57 ครั้ง โอเพ่นซอร์สของไฮบริดโฟลจะจัดหาเครื่องมือที่มีประสิทธิภาพสำหรับการวิจัยและพัฒนา RLHF เพื่อส่งเสริมการพัฒนาเทคโนโลยี LLM ในอนาคต

ที่อยู่กระดาษ: https://arxiv.org/pdf/2409.19256

แหล่งที่มาของเฟรมเวิร์กไฮบริดโฟลว์เป็นวิธีที่มีประสิทธิภาพในการปรับปรุงกระบวนการฝึกอบรม LLM เราหวังว่าจะได้ไฮบริดโฟลว์มีบทบาทมากขึ้นในการวิจัย LLM ในอนาคต