Обучение и оптимизация крупных языковых моделей (LLMS) являются ключевыми проблемами в области искусственного интеллекта. Эффективные методы обучения и выход модели, которые соответствуют человеческим ценностям, имеют решающее значение. Обучение подкреплению и отзывы человека (RLHF) являются основным методом обучения LLM. Для этой цели команда Bytedance Doubao Big Model открыла RLHF -структуру под названием Hybridflow, стремясь решить эти проблемы и принести новые возможности для обучения LLM. Благодаря инновационному дизайну эта структура повышает эффективность и гибкость обучения LLM.

Большие модели (LLM), такие как GPT и Llama, вызвали революцию в области искусственного интеллекта, но как эффективно тренировать эти огромные модели и сделать их в соответствии с человеческими ценностями, остается сложной проблемой.

Подкрепление обучения и обратной связи человека (RLHF) широко использовались в последние годы в качестве важного метода обучения LLM, но традиционная структура RLHF имеет ограничения в гибкости, эффективности и масштабируемости.

Чтобы решить эти проблемы, Bytedance Doubao Big Model Team Open Source Framework RLHF под названием Hybridflow, обеспечивая новые возможности для обучения LLM.

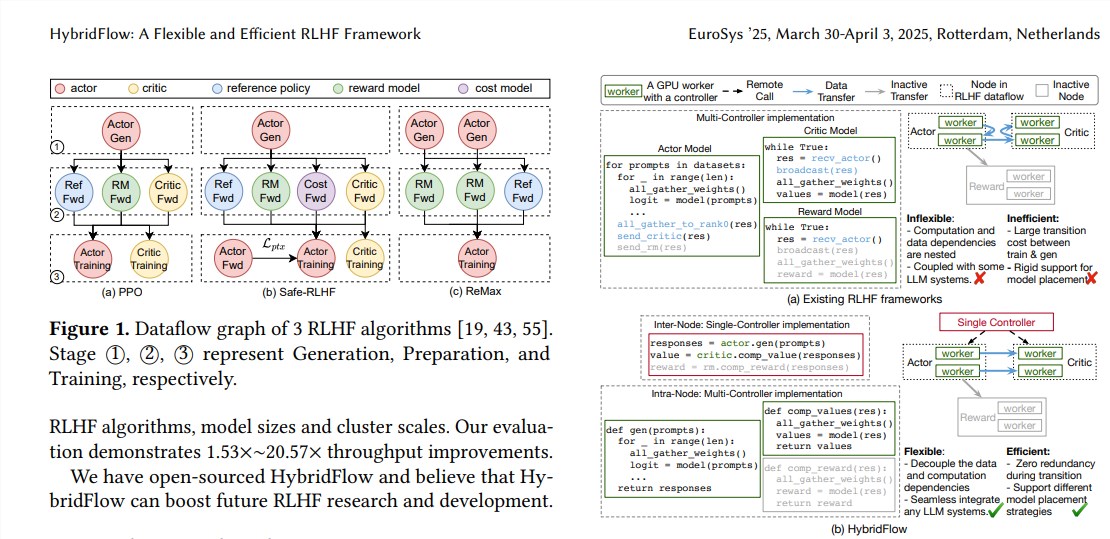

RLHF обычно состоит из трех этапов:

Во -первых, модель актера генерирует текст на основе входных подсказок;

Наконец, эти результаты оценки используются для обучения модели актера для создания текста, который в большей степени соответствует человеческим предпочтениям. Традиционные фреймворки RLHF обычно используют один контроллер для управления всем потоком данных, но это неэффективно для LLM, которые требуют распределенных вычислений.

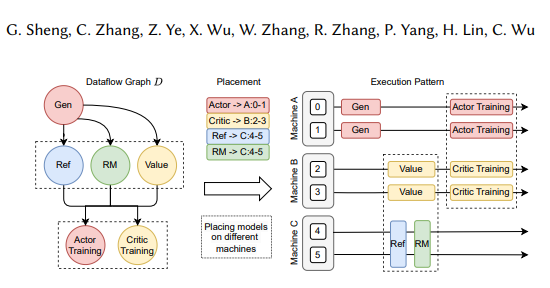

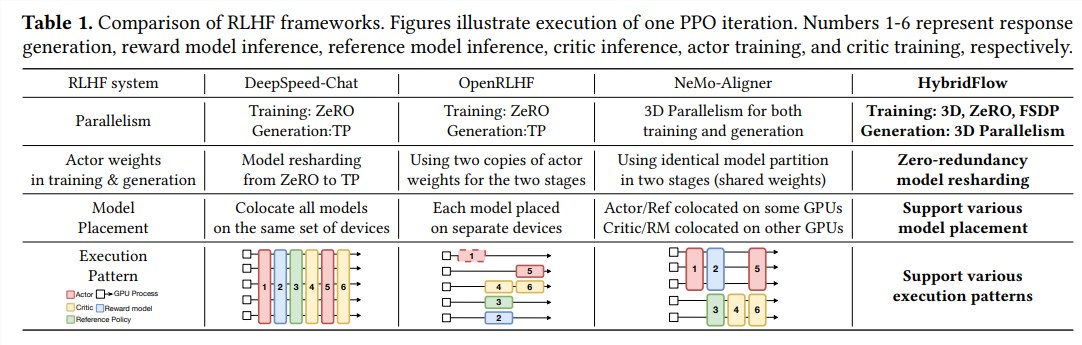

Гибридная структура инновационно сочетает в себе однополучие и многоконтроллерные режимы и декулирует сложные вычисления и зависимости данных с помощью иерархического дизайна API, обеспечивая гибкое представление и эффективное выполнение потоков данных RLHF.

Преимущества гибридного потока в основном отражены в следующих трех аспектах:

Гибкая поддержка различных алгоритмов и моделей RLHF: Hybridflow предоставляет модульный API, где пользователи могут легко реализовать и расширять различные алгоритмы RLHF, такие как PPO, Remax и Safe-RLHF.

Эффективная реорганизация веса модели: компонент 3D-гибридгина поддерживает модели актеров для эффективного реорганизации весов модели на этапах обучения и генерации, минимизируя избыточность памяти и накладные расходы на общение.

Автоматизированное развертывание модели и выбор параллельной политики: компоненты автоматического отображения могут автоматически отображать модели на разные устройства на основе нагрузки на модель и зависимости данных и выбирать наилучшую параллельную политику, тем самым упрощая процесс развертывания модели и повышая эффективность обучения.

Экспериментальные результаты показывают, что пропускная способность гибридного потока значительно увеличивается при запуске различных алгоритмов RLHF, до 20,57 раз. Открытый исходный код Hybridflow предоставит мощные инструменты для исследований и разработок RLHF для продвижения разработки технологии LLM в будущем.

Бумажный адрес: https://arxiv.org/pdf/2409.19256

Открытый источник гибридного потока обеспечивает эффективный способ улучшения процесса обучения LLM. Мы с нетерпением ждем, чтобы Hybridflow играл большую роль в будущих исследованиях LLM.