대형 언어 모델 (LLM)의 교육 및 최적화는 인공 지능 분야에서 중요한 과제입니다. 인간 값을 준수하는 효율적인 교육 방법과 모델 출력이 중요합니다. 강화 학습 및 인간 피드백 (RLHF)은 주류 LLM 교육 방법입니다. 이를 위해 Bytedance Doubao Big Model 팀은 HybridFlow라는 RLHF 프레임 워크를 열었으며 이러한 문제를 해결하고 LLM 교육에 새로운 가능성을 제공합니다. 이 프레임 워크는 혁신적인 디자인을 통해 LLM 교육의 효율성과 유연성을 향상시킵니다.

GPT 및 LLAMA와 같은 대형 모델 (LLM)은 인공 지능 분야에서 혁명을 일으켰지 만 이러한 거대한 모델을 효율적으로 훈련시키고 인간의 가치에 부응하는 방법은 여전히 어려운 문제로 남아 있습니다.

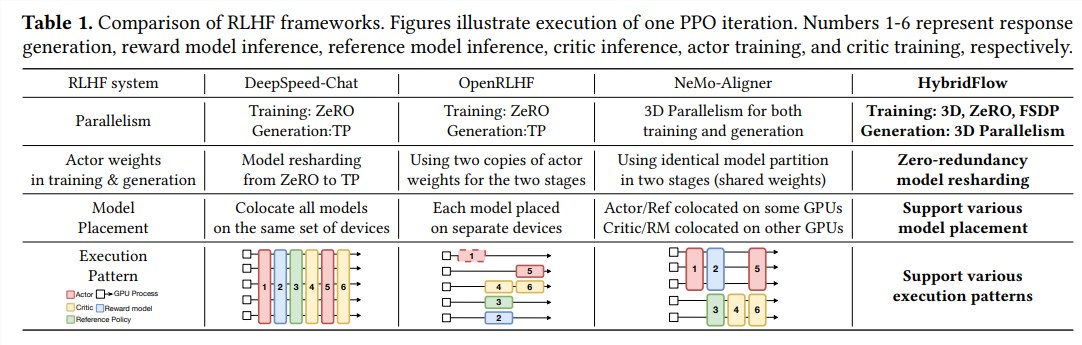

강화 학습 및 인간 피드백 (RLHF)은 최근 몇 년 동안 중요한 LLM 교육 방법으로 널리 사용되어 왔지만 전통적인 RLHF 프레임 워크는 유연성, 효율성 및 확장성에 한계가 있습니다.

이러한 문제를 해결하기 위해 Bytedance Doubao Big Model Team Open Source HybridFlow라는 RLHF 프레임 워크를 통해 LLM 교육에 새로운 가능성이 제공됩니다.

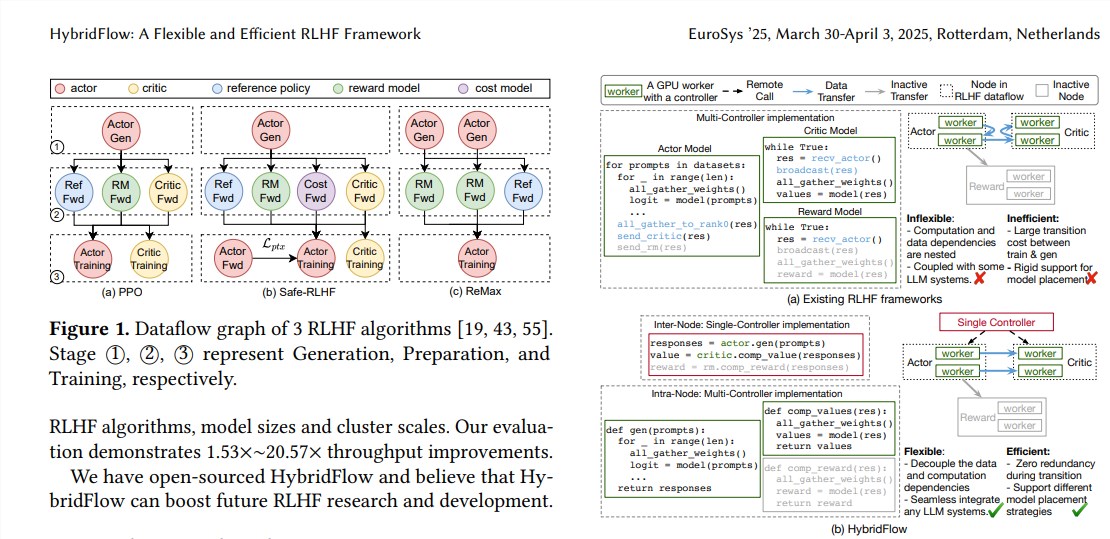

RLHF는 일반적으로 세 단계로 구성됩니다.

먼저, 액터 모델은 입력 프롬프트를 기반으로 텍스트를 생성하고, 중요한 모델, 참조 모델 및 보상 모델은 생성 된 텍스트를 평가하고 해당 값, 참조 확률 및 보상 값을 계산합니다.

마지막으로, 이러한 평가 결과는 배우 모델을 훈련하여 인간의 선호도에 더 부합하는 텍스트를 생성하는 데 사용됩니다. 기존의 RLHF 프레임 워크는 일반적으로 단일 컨트롤러를 사용하여 전체 데이터 스트림을 관리하지만 분산 컴퓨팅이 필요한 LLM에 비효율적입니다.

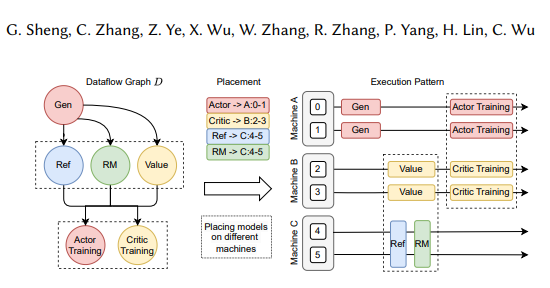

하이브리드 플로우 프레임 워크는 혁신적으로 단일 및 멀티 컨트롤러 모드와 복잡한 컴퓨팅 및 데이터 종속성을 계층 적 API 디자인을 통해 혁신적으로 결합하여 유연한 표현과 RLHF 데이터 스트림의 효율적인 실행을 가능하게합니다.

하이브리드 흐름의 장점은 주로 다음 세 가지 측면에 반영됩니다.

다양한 RLHF 알고리즘 및 모델에 대한 유연한 지원 : HybridFlow는 모듈 식 API를 제공합니다. 여기서 사용자는 PPO, Remax 및 Safe-RLHF와 같은 다양한 RLHF 알고리즘을 쉽게 구현하고 확장 할 수 있습니다.

효율적인 모델 중량 재구성 : 3D-HybridEngine 구성 요소는 액터 모델을 지원하여 훈련 및 생성 단계에서 모델 가중치를 효율적으로 재구성하여 메모리 중복성 및 통신 오버 헤드를 최소화합니다.

자동화 된 모델 배포 및 병렬 정책 선택 : 자동 매핑 구성 요소는 모델로드 및 데이터 종속성을 기반으로 모델을 자동으로 매핑하고 최상의 병렬 정책을 선택하여 모델 배포 프로세스를 단순화하고 교육 효율성을 향상시킬 수 있습니다.

실험 결과에 따르면 다양한 RLHF 알고리즘을 실행할 때 최대 20.57 배까지 하이브리드 플로우의 처리량이 크게 증가합니다. HybridFlow의 오픈 소스는 향후 LLM 기술 개발을 촉진하기 위해 RLHF 연구 및 개발을위한 강력한 도구를 제공 할 것입니다.

종이 주소 : https://arxiv.org/pdf/2409.19256

하이브리드 플로우 프레임 워크의 오픈 소스는 LLM 교육 프로세스를 개선하는 효과적인 방법을 제공합니다. 우리는 향후 LLM 연구에서 하이브리드 흐름이 더 큰 역할을하기를 기대합니다.