O treinamento e otimização de grandes modelos de linguagem (LLMs) são os principais desafios no campo da inteligência artificial. Métodos de treinamento eficientes e saída de modelo que estão em conformidade com os valores humanos são cruciais. O aprendizado de reforço e o feedback humano (RLHF) é um método de treinamento LLM convencional. Para esse fim, a equipe de Bybao Doubao Big Model abriu a estrutura RLHF chamada HybridFlow, com o objetivo de resolver esses problemas e trazer novas possibilidades ao treinamento da LLM. Através do design inovador, essa estrutura melhora a eficiência e a flexibilidade do treinamento de LLM.

Os grandes modelos (LLM), como GPT e LLAMA, desencadearam uma revolução no campo da inteligência artificial, mas como treinar com eficiência esses modelos enormes e fazer com que os valores humanos continuem sendo um problema difícil.

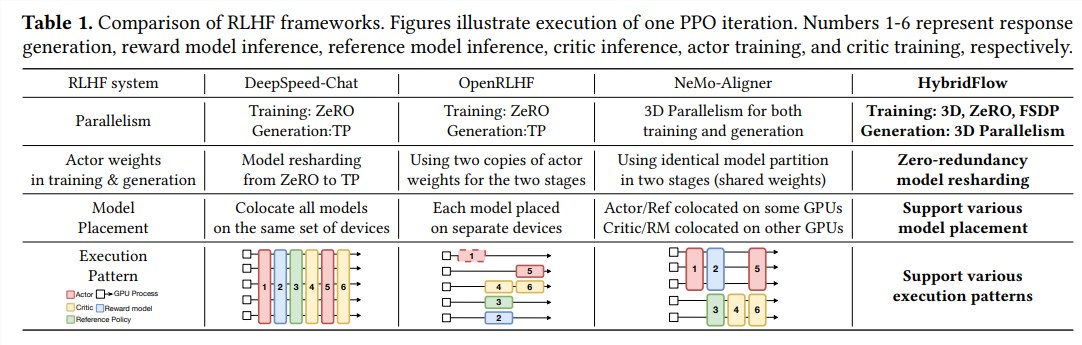

A aprendizagem de reforço e o feedback humano (RLHF) tem sido amplamente utilizado nos últimos anos como um importante método de treinamento de LLM, mas a estrutura tradicional do RLHF tem limitações em flexibilidade, eficiência e escalabilidade.

Para resolver esses problemas, o Bydance Doubao Big Model Team Open Source The RLHF Framework chamado HybridFlow, trazendo novas possibilidades ao treinamento de LLM.

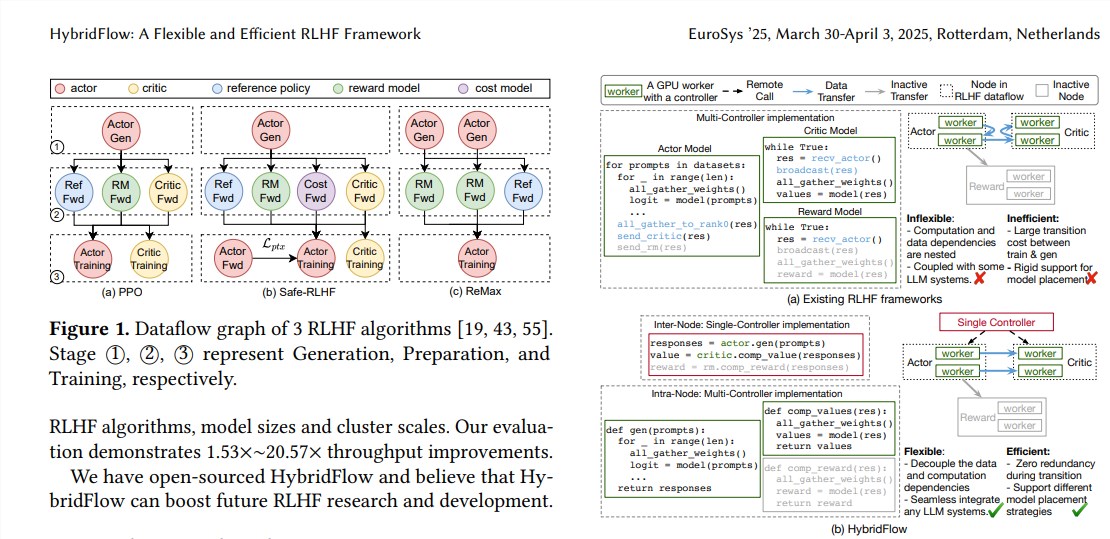

O RLHF geralmente consiste em três estágios:

Primeiro, o modelo do ator gera texto com base nos avisos de entrada;

Finalmente, esses resultados de avaliação são usados para treinar o modelo de ator para gerar texto que está mais alinhado com as preferências humanas. As estruturas RLHF tradicionais geralmente usam um único controlador para gerenciar todo o fluxo de dados, mas isso é ineficiente para LLMs que requerem computação distribuída.

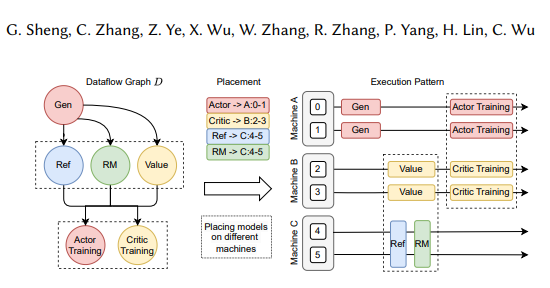

A estrutura HybridFlow combina inovadoramente modos e dependências complexas de computação e dados complexos por meio de design hierárquico da API, permitindo a representação flexível e a execução eficiente de fluxos de dados RLHF.

As vantagens do fluxo de hibrides são refletidas principalmente nos três aspectos a seguir:

Suporte flexível para uma variedade de algoritmos e modelos RLHF: o HybridFlow fornece uma API modular, onde os usuários podem implementar e ampliar facilmente vários algoritmos RLHF, como PPO, Remax e Safe-RLHF.

Reorganização eficiente do peso do modelo: O componente 3D-hybridengine suporta modelos de atores para reorganizar com eficiência os pesos do modelo durante os estágios de treinamento e geração, minimizando a redundância da memória e a sobrecarga de comunicação.

A implantação automatizada de modelos e seleção de políticas paralelas: os componentes de mapeamento automático podem mapear automaticamente modelos para diferentes dispositivos com base na carga do modelo e dependências de dados e selecionar a melhor política paralela, simplificando assim o processo de implantação do modelo e melhorando a eficiência do treinamento.

Os resultados experimentais mostram que a taxa de transferência do HybridFlow aumenta significativamente ao executar vários algoritmos RLHF, até 20,57 vezes. O código aberto da HybridFlow fornecerá ferramentas poderosas para a pesquisa e desenvolvimento da RLHF para promover o desenvolvimento da tecnologia LLM no futuro.

Endereço em papel: https://arxiv.org/pdf/2409.19256

O código aberto da estrutura do HybridFlow fornece uma maneira eficaz de melhorar o processo de treinamento do LLM. Estamos ansiosos para o HybridFlow desempenhando um papel maior na futura pesquisa da LLM.