يعد التدريب وتحسين نماذج اللغة الكبيرة (LLMS) تحديات رئيسية في مجال الذكاء الاصطناعي. أساليب التدريب الفعالة وإخراج النموذج الذي يتوافق مع القيم الإنسانية أمر بالغ الأهمية. التعلم التعزيز والتعليقات البشرية (RLHF) هي طريقة تدريب LLM السائدة. لهذا الغرض ، فتح فريق Doubao Big Model فريق RLHF الذي يسمى Hybridflow ، بهدف حل هذه المشكلات وجلب إمكانيات جديدة لتدريب LLM. من خلال التصميم المبتكر ، يحسن هذا الإطار من كفاءة ومرونة تدريب LLM.

أدت النماذج الكبيرة (LLM) مثل GPT و LLAMA إلى ثورة في مجال الذكاء الاصطناعي ، ولكن كيفية تدريب هذه النماذج الضخمة بكفاءة وجعلها تتماشى مع القيم الإنسانية لا تزال مشكلة صعبة.

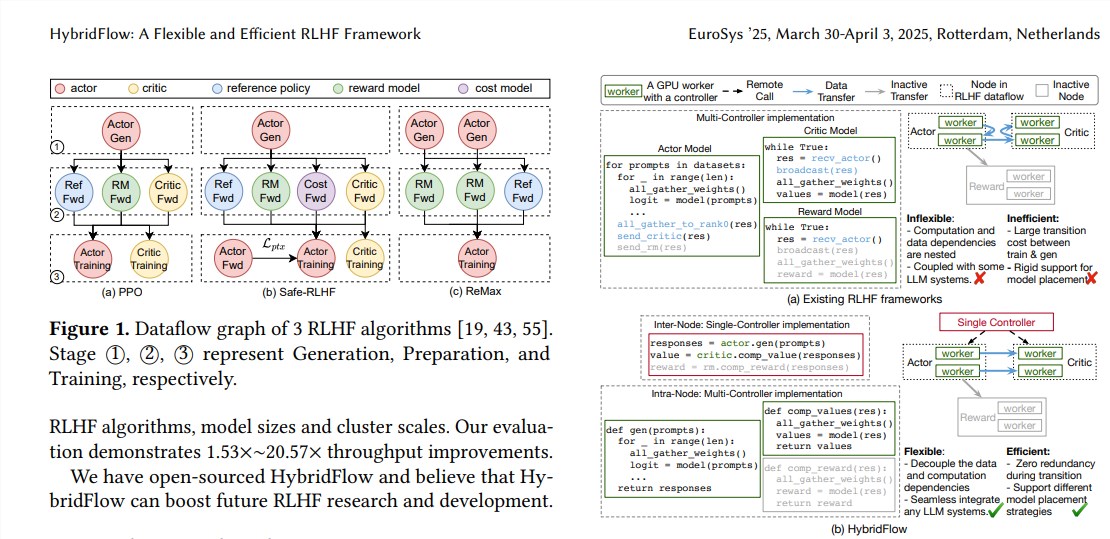

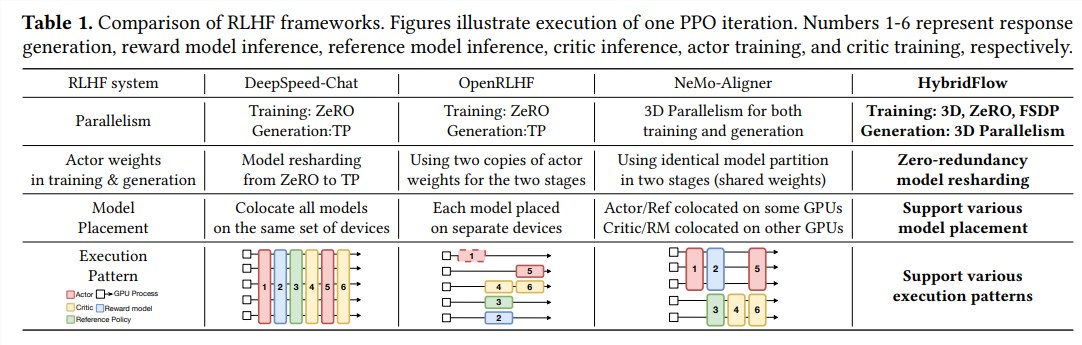

تم استخدام التعلم التعزيز والتعليقات البشرية (RLHF) على نطاق واسع في السنوات الأخيرة كوسيلة تدريب مهمة LLM ، ولكن إطار RLHF التقليدي له قيود في المرونة والكفاءة وقابلية التوسع.

لحل هذه المشكلات ، Openance Doubao Big Model Open Open Source Framework RLHF يسمى Hybridflow ، مما يجلب إمكانيات جديدة لتدريب LLM.

يتكون RLHF عادة من ثلاث مراحل:

أولاً ، يقوم نموذج الممثل بإنشاء نص بناءً على مطالبات الإدخال ؛

أخيرًا ، يتم استخدام نتائج التقييم هذه لتدريب نموذج الممثل لإنشاء نص يتماشى أكثر مع التفضيلات البشرية. عادةً ما تستخدم أطر RLHF التقليدية وحدة تحكم واحدة لإدارة دفق البيانات بأكمله ، ولكن هذا غير فعال بالنسبة لـ LLMs التي تتطلب الحوسبة الموزعة.

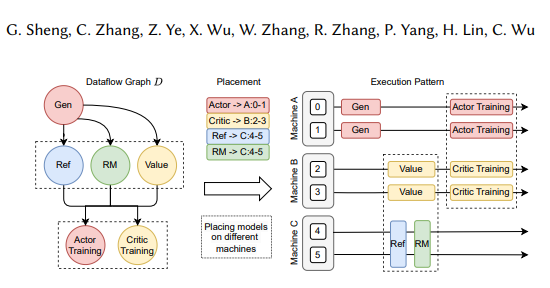

يجمع إطار Hybridflow بشكل مبتكر بين أوضاع أحادية ومتعددة التحكم ، وينكفض التبعيات المعقدة للحوسبة والبيانات من خلال تصميم API الهرمي ، وتمكين التمثيل المرن والتنفيذ الفعال لتيارات بيانات RLHF.

تنعكس مزايا التدفق الهجين بشكل أساسي في الجوانب الثلاثة التالية:

الدعم المرن لمجموعة متنوعة من خوارزميات ونماذج RLHF: يوفر Hybridflow واجهة برمجة تطبيقات معيارية ، حيث يمكن للمستخدمين تنفيذ وتوسيع نطاق خوارزميات RLHF المختلفة بسهولة ، مثل PPO و Remax و Safe-RLHF.

إعادة تنظيم وزن النموذج الفعال: يدعم مكون المكون ثلاثي الأبعاد نماذج الممثلون لإعادة تنظيم الأوزان النموذجية خلال مراحل التدريب والتوليد ، مما يقلل من التكرار في الذاكرة واتصالات الاتصال.

نشر النماذج الآلية واختيار السياسة المتوازية: يمكن لمكونات رسم الخرائط التلقائية تلقائيًا تعيين النماذج لأجهزة مختلفة استنادًا إلى تبعيات تحميل النماذج وبيانات وتحديد أفضل سياسة متوازية ، وبالتالي تبسيط عملية النشر النموذجية وتحسين كفاءة التدريب.

تظهر النتائج التجريبية أن إنتاجية Hybridflow تزداد بشكل كبير عند تشغيل خوارزميات RLHF المختلفة ، حتى 20.57 مرة. سيوفر المصدر المفتوح لـ HybridFlow أدوات قوية للبحث والتطوير في RLHF لتعزيز تطوير تكنولوجيا LLM في المستقبل.

عنوان الورق: https://arxiv.org/pdf/2409.19256

يوفر المصدر المفتوح لإطار العمل الهجين وسيلة فعالة لتحسين عملية تدريب LLM. نتطلع إلى لعب Hybridflow دورًا أكبر في أبحاث LLM المستقبلية.