中文 | Английский

Реальные агенты - это структура планирования, которая объединяет традиционные методы искусственного интеллекта с большими языковыми моделями (LLM) и подходит для генеративных агентов ИИ. Он включает в себя плагин Unity и демонстрационный проект.

Причиной разработки этого проекта является завершение моей диссертации бакалавриата (дизайн) и моего личного интереса к ИИ ИГО.

Большие языковые модели могут выполнять проблемы с рассуждениями, принятием решений и планирования. У нас уже есть много зрелых средств агента, чтобы помочь пользователям управлять некоторыми инструментами, такими как поиск документов и создание веб -страниц.

Но я думаю, что есть несколько проблем при его реализации в игре:

Трудно отлаживать: если выполнение поведения зависит от LLM, оно приведет к тому, что это будет трудно использовать использование токенов и как справиться с исключениями агента;

Медленный ответ: например, если состояние в игре изменяется, нам может потребоваться восстановить быстрое слово и контекст. Если вы позволите NPC генерировать планы, как в Generative AI, потребуется много времени, чтобы подождать, пока будет сгенерирован LLM, который не может быть применен к играм в реальном времени.

Поэтому я попытался сделать LLM на основе традиционного метода ИИ, позволяя агенту планировать, понимая взаимосвязь между величинами и поведением состояния, в то время как программа завершается поведением и мониторинг статуса, и агент будет запускать действия по планированию только при изменении статуса. Полем

{

"dependencies" : {

"com.cysharp.unitask" : " https://github.com/Cysharp/UniTask.git?path=src/UniTask/Assets/Plugins/UniTask " ,

"com.huggingface.sharp-transformers" : " https://github.com/AkiKurisu/sharp-transformers.git " ,

"com.kurisu.akiai" : " https://github.com/AkiKurisu/AkiAI.git " ,

"com.kurisu.akibt" : " https://github.com/AkiKurisu/AkiBT.git " ,

"com.kurisu.akiframework" : " https://github.com/AkiKurisu/AkiFramework.git " ,

"com.kurisu.akigoap" : " https://github.com/AkiKurisu/AkiGOAP.git " ,

"com.kurisu.unichat" : " https://github.com/AkiKurisu/UniChat.git "

}

}Загрузите версию Windows Build со страницы выпуска

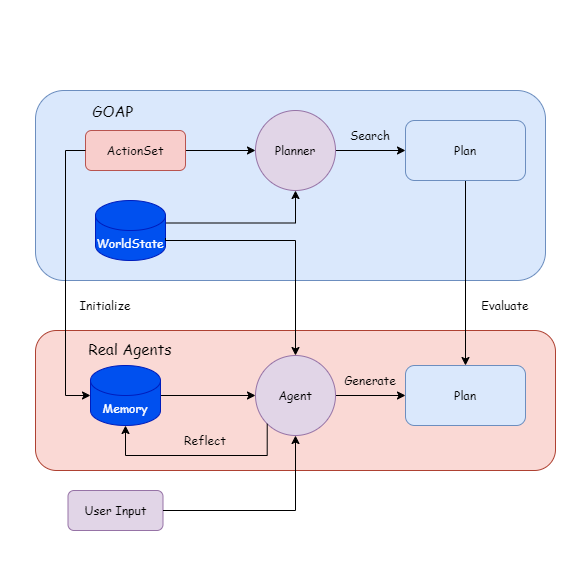

Сначала используйте LLM для маркировки действий и цели на основе данных кожи.

Пусть агент и планировщик генерируют и поиск планов, основанных на мировых штатах (Worldstates) во время выполнения.

Сравните план, LLM отражает и итерации на памяти.

Затем вы можете закрыть планировщик и позволить агенту генерировать план.

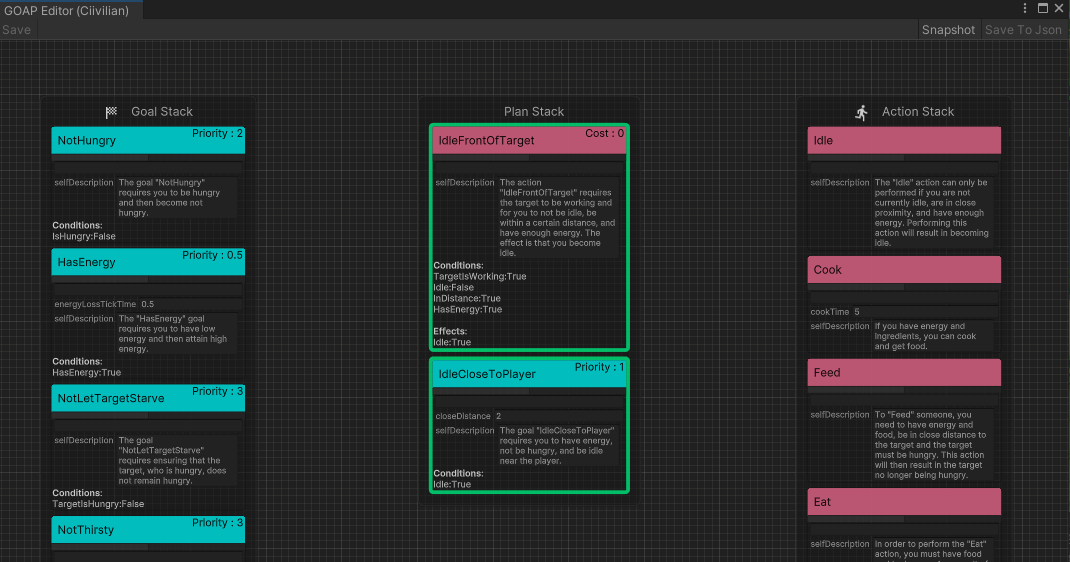

Во -первых, разработчик определяет исполняемый набор действий ( ActionSet ) и набор целей ( GoalSet ).

Каждое поведение основано на правилах кожи и имеет предварительное Precondition и Effect эффекта.

public class Eat : DescriptiveTask

{

protected sealed override void SetupDerived ( )

{

Preconditions [ States . HasFood ] = true ;

Preconditions [ States . IsHungry ] = true ;

}

protected sealed override void SetupEffects ( )

{

Effects [ States . IsHungry ] = false ;

}

} Во-вторых, входное Action к модели большого языка, суммируйте его в естественном языке как первоначальное впечатление агента по поведению ( InitialImpression ) и долговременной памяти ( Summary ), и оставьте кратковременную память ( Comments ).

"Name" : " Cook " ,

"InitialImpression" : " To Cook, you need to have energy and ingredients, and as a result, you will have food. " ,

"Summary" : " Latest summary " ,

"Comments" : [

" " ,

" " ,

" " ,

" " ,

" "

] Goal ввода в модель большого языка и позвольте LLM генерировать естественный язык в качестве объяснения ( Explanation ) для использования цели. И объединить их, чтобы получить интерпретацию набора G.

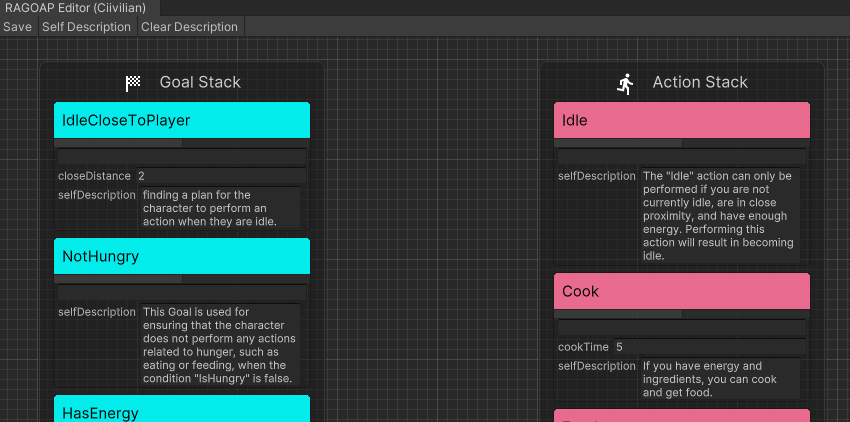

В реальных агентах вы можете напрямую щелкнуть Self Description в редакторе RealAgentSet , чтобы сгенерировать приведенные выше данные.

Отрегулируйте режим агента ( AgentMode ) и установите его на Training .

Plan , работающий в это время, искал планировщик, а агент генерирует Plan одновременно. Если есть разница в поведении, LLM отражает причину и генерирует Comment как кратковременную память.

Когда кратковременная память достигает порога, агент суммирует его на основе начального впечатления, комментариев и текущей долгосрочной памяти, перезаписывает долговременную память и итерации.

Основываясь на целях, вставленных извне, агент рассуждает в режиме реального времени в виртуальном пространстве.

LLM находит подходящий Plan , основанный на собственной памяти о каждом поведении. Поскольку нет сравнения планировщиков, оно только определяет, является ли Plan возможным. Если нет, LLM генерирует ( Comment ) и вводит его в память.

Эксперимент использует CHATGPT3.5 OpenAI в качестве модели вывода. Вам нужно заполнить свой собственный ключ API в интерфейсе настроек игры.

Грань

Для моделей VRM, пожалуйста, смотрите лицензионные заявления отдельных авторов.

Полигоновое фантастическое королевство - платный актив.

https://assetstore.unity.com/packages/3d/environments/fantasy/polygon-fantasy-kingdom-low-poly-3d-art-by-synty-164532

Пример сцены оптимизируется оптимизатором сцены, созданными процедурными мирами.

Среда Lowpoly может быть загружена в AssetStore бесплатно.

https://assetstore.unity.com/packages/3d/environments/lowpoly-environment-nature-free-medieval-fantasy-series-187052

Жара - Полный современный пользовательский интерфейс - платный актив.

https://assetstore.unity.com/packages/2d/gui/heat-complete-modern-ui-264857

GUI-Casualfantasy-это платный актив.

https://assetstore.unity.com/packages/2d/gui/gui-casual-fantasy-265651

Unity Chan Animation принадлежит Unity Technology Japan и по лицензии UC2.

Medieval Animations Mega Pack - это платный актив.

https://assetstore.unity.com/packages/3d/animations/medieval-animations-mega-pack-12141

Starter Asset Unity находится под лицензией Unity Companion и может быть загружен в Assetstore бесплатно.

https://assetstore.unity.com/packages/essentials/starter-assets-thirdperson-updates-in-new-charactercontroller-pa-196526

Univrm находится под лицензией MIT.

https://github.com/vrm-c/univrm

Akiframework находится под лицензией MIT.

https://github.com/akikurisu/akiframework

Другие ресурсы анимации, музыки, пользовательского интерфейса и шрифтов, используемых в демонстрации, являются сетевыми ресурсами и не должны использоваться в коммерческих целях.

@misc{realagents,

author = {YiFei Feng},

title = {Real Agents: An planning framework for generative artificial intelligence agents},

year = {2024},

publisher = {GitHub},

journal = {https://github.com/AkiKurisu/Real-Agents},

school = {East China University of Political Science and Law},

location = {Shanghai, China}

}

Стив Рабин, Game AI Pro 3: Собранная мудрость профессионалов ИИ , Международная стандартная книга.

[Оркин 06] Оркин, J. 2006. 3 Штаты и план: ИИ страха , конференция разработчиков игр, Сан -Франциско, Калифорния.

Джун Сунг Парк, Джозеф С. О'Брайен, Кэрри Дж. Кай, Мередит Ринглет Моррис, Перси Лян и Майкл С. Бернштейн. 2023. Генеративные агенты: интерактивная симулякра человеческого поведения.

Wang, Zihao et al. «Опишите, объясните, планируйте и выберите: интерактивное планирование с большими языковыми моделями позволяет многозадачному открытому миру». Arxiv Abs/2302.01560 (2023): n. паг

Lin J, Zhao H, Zhang A, et al. Агентсими: песочница с открытым исходным кодом для оценки большой языковой модели [J]. Arxiv Preprint arxiv: 2308.04026, 2023.

XI, Z., Chen, W., Guo, X., He, W., Ding, Y., Hong, B., Zhang, M., Wang, J., Jin, S., Zhou, E., Zheng, R., Fan, X., Wang, X., Xiong, L., Liu, Q., Z., x, x, x, x., x. Yin, Z., Dou, S., Weng, R., Cheng, W., Zhang, Q., Qin, W., Zheng, Y., Qiu, X., Huan, X. & Gui, T. (2023). Рост и потенциал агентов на основе крупных языковых моделей: опрос. Arxiv, ABS/2309.07864.