中文 | Englisch

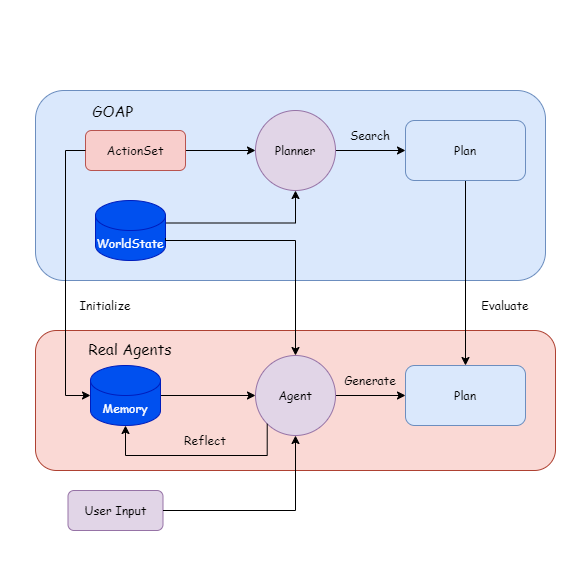

Real Agents ist ein Planungsrahmen, der traditionelle Methoden für künstliche Intelligenz mit großartigen Modellen (LPO -Modellen) kombiniert und für generative AI -Agenten geeignet ist. Es enthält ein Einheit-Plug-In- und Demonstrationsprojekt.

Der Grund für die Entwicklung dieses Projekts besteht darin, meine These (Design) und mein persönliches Interesse an Spiele KI zu vervollständigen.

Großsprachenmodelle können Argumentation, Entscheidungsfindung und Planungsprobleme durchführen. Wir haben bereits viele ausgereifte Agent -Frameworks, mit denen Benutzer einige Tools betreiben können, z. B. nach Dokumenten und das Erstellen von Webseiten.

Aber ich denke, es gibt mehrere Probleme, wenn es im Spiel implementiert wird:

Schwierig zu debuggen: Wenn die Verhaltensausführung auf LLM beruht, wird dies schwer zu schätzen die Nutzung von Token und die Umgang mit Agentenausnahmen führen.

Langsame Antwort: Zum Beispiel, wenn sich der Staat im Spiel ändert, müssen wir möglicherweise das schnelle Wort und den Kontext rekonstruieren. Wenn Sie NPC Pläne wie in Generative AI generieren lassen, dauert es viel Zeit, bis LLM generiert wird, was nicht auf Echtzeitspiele angewendet werden kann.

Daher habe ich versucht, LLM auf der Grundlage der herkömmlichen KI -Methode zu erstellen, damit der Agent planen kann, indem er die Beziehung zwischen Zustandsgrößen und Verhaltensweisen versteht, während die Ausführung und die Statusüberwachung des Verhaltens vom Programm abgeschlossen werden, und der Agent löst die Planungsaktionen nur dann aus, wenn sich der Status ändert. .

{

"dependencies" : {

"com.cysharp.unitask" : " https://github.com/Cysharp/UniTask.git?path=src/UniTask/Assets/Plugins/UniTask " ,

"com.huggingface.sharp-transformers" : " https://github.com/AkiKurisu/sharp-transformers.git " ,

"com.kurisu.akiai" : " https://github.com/AkiKurisu/AkiAI.git " ,

"com.kurisu.akibt" : " https://github.com/AkiKurisu/AkiBT.git " ,

"com.kurisu.akiframework" : " https://github.com/AkiKurisu/AkiFramework.git " ,

"com.kurisu.akigoap" : " https://github.com/AkiKurisu/AkiGOAP.git " ,

"com.kurisu.unichat" : " https://github.com/AkiKurisu/UniChat.git "

}

}Laden Sie die Windows -Build -Version von der Release -Seite herunter

Verwenden Sie zuerst LLM, um Aktion und Ziel basierend auf GOAP -Daten zu kennzeichnen.

Lassen Sie Agent und Planer während der Laufzeit auf der Grundlage von Weltstaaten (WorldStates) erstellen und suchen.

Vergleichen Sie den Plan, LLM reflektiert und iteriert den Speicher.

Sie können dann den Planer schließen und den Agenten den Plan generieren lassen.

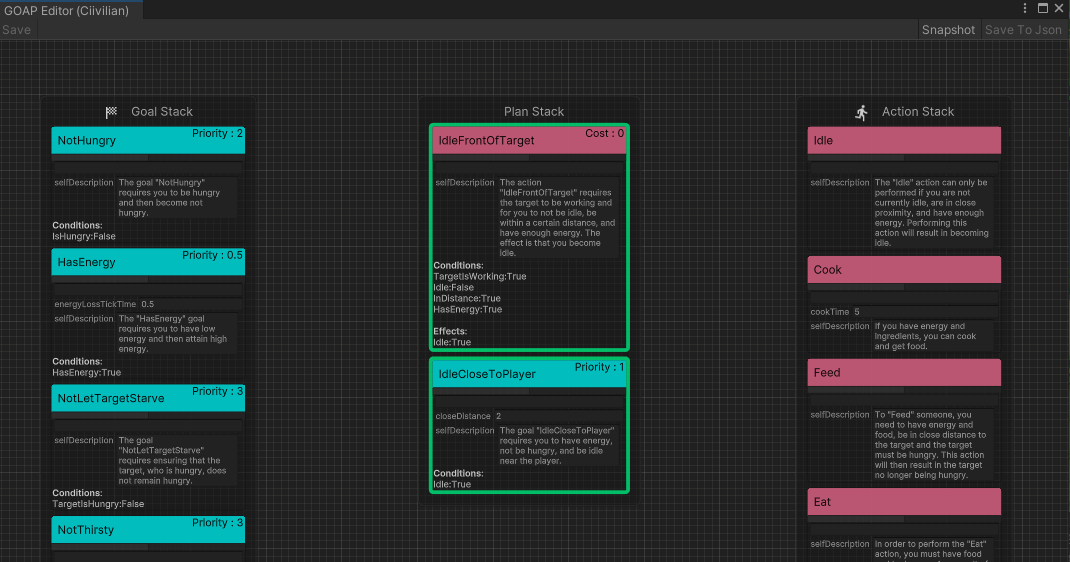

Zunächst definiert der Entwickler eine ausführbare Aktion ( ActionSet ) und einen Zielsatz ( GoalSet SET).

Jedes Verhalten basiert auf GOAP -Regeln und hat eine Precondition und einen Effect .

public class Eat : DescriptiveTask

{

protected sealed override void SetupDerived ( )

{

Preconditions [ States . HasFood ] = true ;

Preconditions [ States . IsHungry ] = true ;

}

protected sealed override void SetupEffects ( )

{

Effects [ States . IsHungry ] = false ;

}

} Zweitens, Action in das Großsprachenmodell, fassen Sie es in natürliche Sprache als den ersten Eindruck des Verhaltens ( InitialImpression ) und Langzeitgedächtnis ( Summary ) zusammen und lassen Sie den Kurzzeitgedächtnis ( Comments ) leer.

"Name" : " Cook " ,

"InitialImpression" : " To Cook, you need to have energy and ingredients, and as a result, you will have food. " ,

"Summary" : " Latest summary " ,

"Comments" : [

" " ,

" " ,

" " ,

" " ,

" "

] Goal für das große Sprachmodell und lass LLM natürliche Sprache als Erklärung ( Explanation ) für die Verwendung des Ziels generieren. Und kombinieren Sie sie, um die Interpretation des Satzes G zu erhalten.

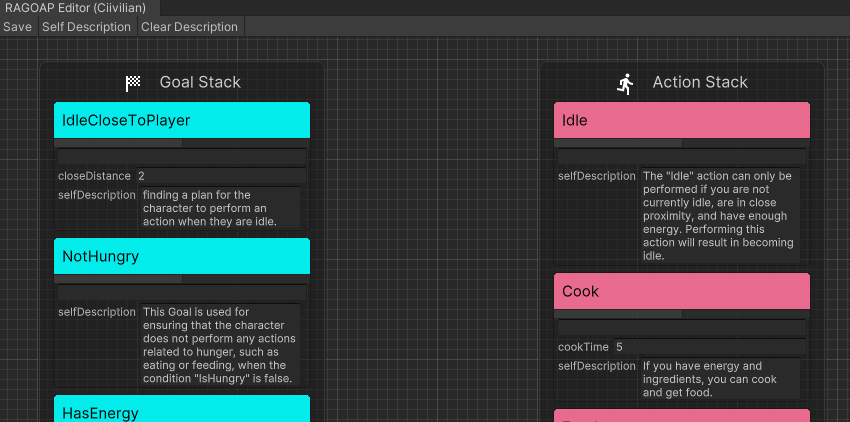

In Real Agents können Sie direkt auf Self Description im Editor von RealAgentSet klicken, um die oben genannten Daten zu generieren.

Passen Sie den Agentenmodus ( AgentMode ) an und stellen Sie ihn auf Training ein.

Der zu diesem Zeitpunkt ausgeführte Plan wird vom Planer durchsucht, und der Agent generiert gleichzeitig einen Plan . Wenn es einen Verhaltensunterschied gibt, reflektiert LLM den Grund und generiert einen Comment als Kurzzeitgedächtnis.

Wenn das Kurzzeitgedächtnis den Schwellenwert erreicht, fasst der Agent ihn anhand des ersten Eindrucks, Kommentare und aktuelles Langzeitgedächtnis zusammen, überschreibt das Langzeitgedächtnis und iteriert.

Basierend auf den Zielen, die von außen eingegeben werden, begründet der Agent in Echtzeit im virtuellen Bereich.

LLM findet einen geeigneten Plan , der auf seiner eigenen Erinnerung an jedes Verhalten basiert. Da es keinen Planervergleich gibt, bestimmt es nur, ob der Plan machbar ist. Wenn nicht, generiert LLM ( Comment ) und injiziert es in den Speicher.

Das Experiment verwendet OpenAIs Chatgpt3.5 als Inferenzmodell. Sie müssen Ihre eigene API -Schlüssel in der Schnittstelle für Spieleinstellungen ausfüllen.

MIT

Für VRM -Modelle finden Sie die Lizenzerklärungen des einzelnen Autors.

Polygon Fantasy Kingdom ist ein bezahltes Kapital.

https://assetstore.unity.com/packages/environments/fantasy/polygon-fantasy-kingdom-low-poly-3d-art-by-synty-164532

Die Beispielszene wird durch den Szenenoptimierer optimiert, der von prozeduralen Welten erstellt wurde.

Lowpoly -Umgebung kann kostenlos in AssetStore heruntergeladen werden.

https://assetstore.unity.com/packages/3d/environments/lowpoly-environment-nature-free-medieval-fantasy-series-187052

Wärme - Komplette moderne Benutzeroberfläche wird bezahlt.

https://assetstore.unity.com/packages/gui/heat-complete-modern-ui-264857

GUI-Casualfantasy wird bezahltem Vermögenswert.

https://assetstore.unity.com/packages/gui/gui-casual-fantasy-265651

Unity Chan Animation gehört der Unity Technology Japan und unter UC2 -Lizenz.

Mittelalterliche Animationen Mega Pack wird bezahlt.

https://assetstore.unity.com/packages/animations/medieval-animations-mega-pack-12141

Unity Starter Asset steht unter der Unity Companion -Lizenz und kann kostenlos in AssetStore heruntergeladen werden.

https://assetstore.unity.com/packages/essentials/starter-assets-thirdperson-updates-in-new-charactercontroller-pa-196526

UNIVRM steht unter MIT -Lizenz.

https://github.com/vrm-c/univrm

Akiframework steht unter MIT -Lizenz.

https://github.com/akikurisu/akiframework

Andere Animationen, Musik-, Benutzeroberflächen- und Schriftressourcen, die in der Demo verwendet werden, sind Netzwerkressourcen und sollten nicht für kommerzielle Zwecke verwendet werden.

@misc{realagents,

author = {YiFei Feng},

title = {Real Agents: An planning framework for generative artificial intelligence agents},

year = {2024},

publisher = {GitHub},

journal = {https://github.com/AkiKurisu/Real-Agents},

school = {East China University of Political Science and Law},

location = {Shanghai, China}

}

Steve Rabin, Game AI Pro 3: Sammelte Weisheit von Game AI Professionals , Internationales Standardbuch.

[Orkin 06] Orkin, J. 2006. 3 Staaten und ein Plan: Die KI der Angst , Game Developers Conference, San Francisco, CA.

Joon Sung Park, Joseph C. O'Brien, Carrie J. Cai, Meredith Ringel Morris, Percy Liang und Michael S. Bernstein. 2023. Generative Agents: Interaktive Simulacra des menschlichen Verhaltens.

Wang, Zihao et al. "Beschreiben, erklären, planen und auswählen: Interaktive Planung mit großsprachigen Modellen ermöglicht Open-World Multi-Task-Agenten." ARXIV ABS/2302.01560 (2023): n. Pag.

Lin J., Zhao H., Zhang A. et al. Agenten: Ein Open-Source-Sandkasten für die Bewertung des Modells in großer Sprache [j]. ARXIV Preprint Arxiv: 2308.04026, 2023.

Xi, Z., Chen, W., Guo, X., He, W., Ding, Y., Hong, B., Zhang, M., Wang, J., Jin, S., Zhou, E., Zheng, R., Fan, X., Wang, X., Xiong, L., Liu, Q. Yin, Z., Dou, S., Weng, R., Cheng, W., Zhang, Q., Qin, W., Zheng, Y., Qiu, X., Huan, X. & Gui, T. (2023). Der Anstieg und das Potenzial von modellbasierten Wirkstoffen in großer Sprache: Eine Umfrage. Arxiv, ABS/2309.07864.