A startup de inteligência artificial chinesa Deepseek lançou recentemente seu mais recente modelo de linguagem em larga escala, Deepseek-V3-0324, que atraiu atenção generalizada na indústria de inteligência artificial. O modelo aparece na biblioteca de recursos da IA abraçando o rosto de 641 GB, continuando o estilo discreto habitual de Deepseek. Ele não realiza publicidade em larga escala e só vem com um arquivo readme vazio e pesos de modelo.

Este modelo é licenciado com o MIT, permitindo que ele seja usado gratuitamente para fins comerciais e pode ser executado diretamente em hardware de nível de consumo, como o Apple Mac Studio com o M3 Ultra Chip. O pesquisador da IA Awni Hannun revelou nas mídias sociais que a versão quantitativa de 4 bits do DeepSeek-V3-0324 funciona mais rápido que 20 tokens por segundo em um chip Ultra de 512 GB M3. Apesar do alto preço do Mac Studio, poder executar um modelo de grande escala quebra localmente a dependência anterior da IA principal nos data centers.

Deepseek-V3-0324 adota uma arquitetura de especialista em híbrido (MOE), que ativa apenas cerca de 37 bilhões de parâmetros em vez de todos os 685 bilhões de parâmetros ao executar tarefas, melhorando bastante a eficiência. Ao mesmo tempo, o modelo também incorpora as tecnologias de longa atenção potencial (MLA) e previsão de vários toques (MTP). O MLA aprimora a capacidade de compreensão contextual do modelo em textos longos. O MTP permite que o modelo gere vários tokens por vez, e a velocidade de saída é aumentada em quase 80%. A versão quantizada de 4 bits reduz a demanda de armazenamento para 352 GB, possibilitando a execução em hardware de nível de consumo de ponta.

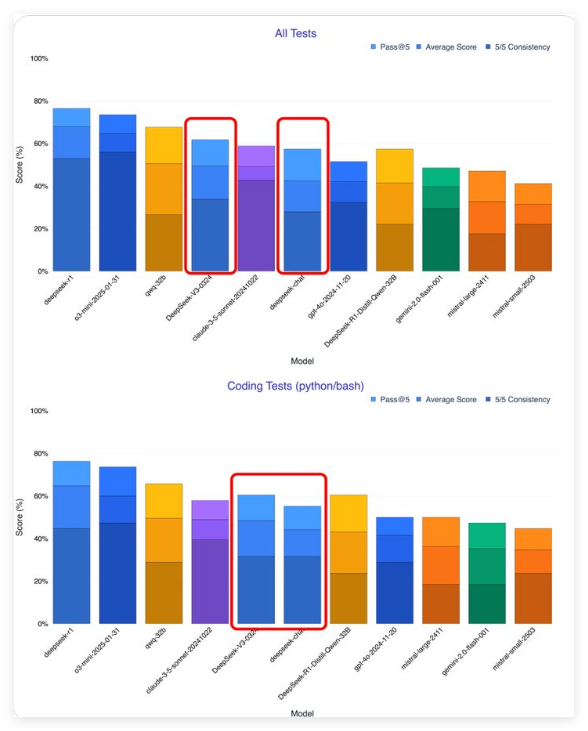

Segundo os primeiros testadores, o Deepseek-V3-0324 melhorou significativamente em comparação com a versão anterior. O pesquisador da IA Xeophon afirma que o modelo deu um grande salto em todas as métricas de teste, superando o Soneto Claude 3.5 do Anthropic Anthropic para se tornar o melhor modelo de não inferência. Além disso, diferentemente do soneto que precisa ser inscrito, o peso do Deepseek-V3-0324 pode ser baixado gratuitamente.

A estratégia de liberação de código aberto da Deepseek contrasta nítidas com as empresas ocidentais de IA. O OpenAI e Antrópico dos Estados Unidos estabeleceram limiares de pagamento para modelos, enquanto as empresas de IA chinesas estão cada vez mais inclinadas a perder licenças de código aberto. Essa estratégia acelerou o desenvolvimento do ecossistema de IA da China, e gigantes da tecnologia como Baidu, Alibaba e Tencent também seguiram o exemplo e lançaram os modelos de IA de código aberto. Enfrentando as restrições de chips da NVIDIA, as empresas chinesas transformaram suas desvantagens em vantagens competitivas, enfatizando a eficiência e a otimização.

Deepseek-V3-0324 provavelmente será a base do próximo modelo de inferência Deepseek-R2. A atual demanda de computação do modelo de inferência é enorme. Se o Deepseek-R2 tiver um bom desempenho, ele representará um desafio direto para o rumores do GPT-5 do Openai.

Para usuários e desenvolvedores que desejam experimentar Deepseek-V3-0324, o peso completo do modelo pode ser baixado do Hugging Face, mas os arquivos são grandes e requerem recursos altos de armazenamento e computação. Você também pode escolher serviços em nuvem, como o OpenRouter, que fornece acesso gratuito à API e uma interface de bate -papo amigável; A interface de bate -papo da Deepseek também pode ter sido atualizada para oferecer suporte a novas versões. Os desenvolvedores também podem integrar o modelo por meio de provedores de serviços de raciocínio, como laboratórios hiperbólicos.

Vale a pena notar que o DeepSeek-V3-0324 mudou no estilo de comunicação, de um estilo de diálogo humano para um estilo mais formal e técnico. Essa mudança pretende se adaptar aos cenários de aplicação profissional e técnica, mas pode afetar seu apelo em aplicativos orientados ao consumidor.

A estratégia de código aberto da Deepseek está remodelando o cenário global da IA. Anteriormente, a lacuna de IA da China com os Estados Unidos estava de 1 a 2 anos de distância, mas agora diminuiu significativamente para 3-6 meses, e algumas áreas chegaram a alcançar o atraso. Assim como os sistemas Android ganham domínio global por meio de código aberto, o modelo de IA de código aberto deve se destacar na competição com uma ampla gama de aplicações e inovações coletivas de desenvolvedores e promover a aplicação mais ampla da tecnologia de IA.