Das chinesische Startup für künstliche Intelligenz Deepseek hat kürzlich sein neuestes groß angelangtes Sprachmodell Deepseek-V3-0324 veröffentlicht, das in der künstlichen Intelligenzbranche weit verbreitete Aufmerksamkeit auf sich gezogen hat. Das Modell erscheint in der AI Resource Library, die das Gesicht mit 641 GB umarmt und Deepseeks üblicher zurückhaltender Stil fortsetzt. Es führt keine groß angelegte Werbung durch und verfügt nur über eine leere LEADME-Datei- und Modellgewichte.

Dieses Modell ist mit MIT lizenziert, sodass es kostenlos für kommerzielle Zwecke verwendet werden kann und direkt auf Hardware für Verbraucher wie dem Apple Mac Studio mit dem M3 Ultra-Chip ausgeführt werden kann. AI-Forscher Awni Hannun enthüllte in den sozialen Medien, dass die 4-Bit-quantitative Version von Deepseek-V3-0324 bei einem 512 GB M3 Ultra-Chip schneller als 20 Token pro Sekunde verläuft. Trotz des hohen Preises von MAC Studio bricht die in der Lage, ein so groß angelegtes Modell lokal die vorherige Abhängigkeit der Top-KI von Rechenzentren zu betreiben.

Deepseek-V3-0324 verwendet eine MOE-Architektur (Hybrid Expert), die nur etwa 37 Milliarden Parameter anstelle aller 685 Milliarden Parameter bei der Ausführung von Aufgaben aktiviert und damit die Effizienz erheblich verbessert. Gleichzeitig umfasst das Modell auch lange potenzielle Aufmerksamkeit (MLA) und Multi-Tooken-Vorhersage (MTP) -Technologien. MLA verbessert die kontextbezogene Verständnisfähigkeit des Modells in langen Texten. MTP ermöglicht es dem Modell, mehrere Token gleichzeitig zu erzeugen, und die Ausgangsgeschwindigkeit wird um fast 80%erhöht. Die 4-Bit-quantisierte Version reduziert den Speicherbedarf auf 352 GB, wodurch die Hardware für High-End-Verbraucher betrieben wird.

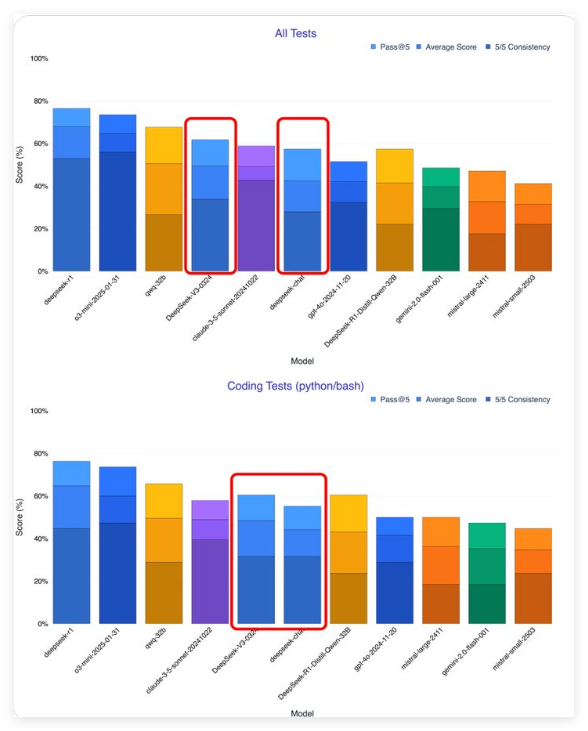

Laut frühen Tester hat sich Deepseek-V3-0324 im Vergleich zur vorherigen Version erheblich verbessert. Der KI-Forscher Xeophon behauptet, dass das Modell in allen Testmetriken einen großen Sprung gemacht habe und das Claude-Sonnet 3.5 von Anthropic übertroffen hat, um das beste Nicht-Inferenzmodell zu werden. Im Gegensatz zu Sonett, das abonniert werden muss, kann das Gewicht von Deepseek-V3-0324 kostenlos heruntergeladen werden.

Deepseeks Open -Source -Release -Strategie steht in scharfem Gegensatz zu westlichen KI -Unternehmen. Openai und Anthropic der Vereinigten Staaten haben Zahlungsschwellen für Modelle festgelegt, während chinesische KI -Unternehmen zunehmend dazu neigen, Open -Source -Lizenzen zu verlieren. Diese Strategie hat die Entwicklung des Chinas AI -Ökosystems beschleunigt, und Technologiegiganten wie Baidu, Alibaba und Tencent haben ebenfalls Open -Source -KI -Modelle verfolgt und veröffentlicht. Angesichts der Nvidia -Chip -Beschränkungen haben chinesische Unternehmen ihre Nachteile in Wettbewerbsvorteile verwandelt, indem sie Effizienz und Optimierung hervorheben.

Deepseek-V3-0324 ist wahrscheinlich die Grundlage für das bevorstehende Deepseek-R2-Inferenzmodell. Der aktuelle Inferenzmodell -Computerbedarf ist enorm. Wenn Deepseek-R2 gut abschneidet, wird dies eine direkte Herausforderung für die gemunkelte GPT-5 von OpenAI stellen.

Für Benutzer und Entwickler, die Deepseek-V3-0324 erleben möchten, kann das vollständige Modellgewicht aus dem Umarmungsgesicht heruntergeladen werden. Die Dateien sind jedoch groß und erfordern hohe Speicher- und Rechenressourcen. Sie können auch Cloud -Dienste wie OpenRouter auswählen, die einen kostenlosen API -Zugriff und eine freundliche Chat -Oberfläche bieten. Deepseeks eigene Chat -Oberfläche wurde möglicherweise auch aktualisiert, um neue Versionen zu unterstützen. Entwickler können das Modell auch durch Argumentation von Dienstanbietern wie hyperbolischen Labors integrieren.

Es ist erwähnenswert, dass sich Deepseek-V3-0324 im Kommunikationsstil von einem menschlichen Dialogstil zu einem formellen und technischen Stil verändert hat. Diese Verschiebung soll sich an professionelle und technische Anwendungsszenarien anpassen, kann jedoch die Attraktivität in verbraucherorientierten Anwendungen beeinflussen.

Deepseeks Open -Source -Strategie ist die Umgestaltung der globalen KI -Landschaft. Zuvor war Chinas KI-Lücke mit den Vereinigten Staaten 1-2 Jahre entfernt, aber jetzt hat es sich erheblich auf 3-6 Monate eingeengt, und einige Gebiete haben sogar ein Nachholen erreicht. So wie Android -Systeme durch Open Source globale Dominanz erlangen, wird das Open -Source -KI -Modell voraussichtlich im Wettbewerb mit einer breiten Palette von Anwendungen und kollektiven Innovationen von Entwicklern abgehalten und die breitere Anwendung der KI -Technologie fördern.