Site Web officiel www.binance.com/ZH-CN :Entrez le site officiel ☜☜

Application: ☞☞Official App Download☜☜

La startup d'intelligence artificielle chinoise Deepseek a récemment publié tranquillement son dernier modèle de langue à grande échelle, Deepseek-V3-0324, qui a attiré une attention généralisée dans l'industrie de l'intelligence artificielle. Le modèle apparaît sur la bibliothèque de ressources AI étreignant le visage à 641 Go, en continuant le style discret habituel de Deepseek. Il ne fait pas de publicité à grande échelle et n'est livré qu'avec un fichier de lecture vide et des poids de modèle.

Ce modèle est licencié avec le MIT, ce qui lui permet d'être utilisé gratuitement à des fins commerciales et peut fonctionner directement sur le matériel de qualité grand public, comme le studio Apple Mac avec la puce M3 Ultra. Le chercheur de l'IA, Awni Hannun, a révélé sur les réseaux sociaux que la version quantitative 4 bits de Deepseek-V3-0324 fonctionne plus rapidement que 20 jetons par seconde sur une puce ultra M3 de 512 Go. Malgré le prix élevé de Mac Studio, être capable d'exécuter un modèle aussi à grande échelle intervient localement la dépendance précédente de la meilleure IA sur les centres de données.

Deepseek-V3-0324 adopte une architecture experte hybride (MOE), qui n'active que 37 milliards de paramètres au lieu des 685 milliards de paramètres lors de l'exécution de tâches, améliorant ainsi considérablement l'efficacité. Dans le même temps, le modèle intègre également les technologies de prédiction (MTP) à longue attention potentielle (MLA) et multi-token (MTP). MLA améliore la capacité de compréhension contextuelle du modèle dans les textes longs. MTP permet au modèle de générer plusieurs jetons à la fois, et la vitesse de sortie est augmentée de près de 80%. La version quantifiée à 4 bits réduit la demande de stockage à 352 Go, ce qui permet de fonctionner sur du matériel grand public.

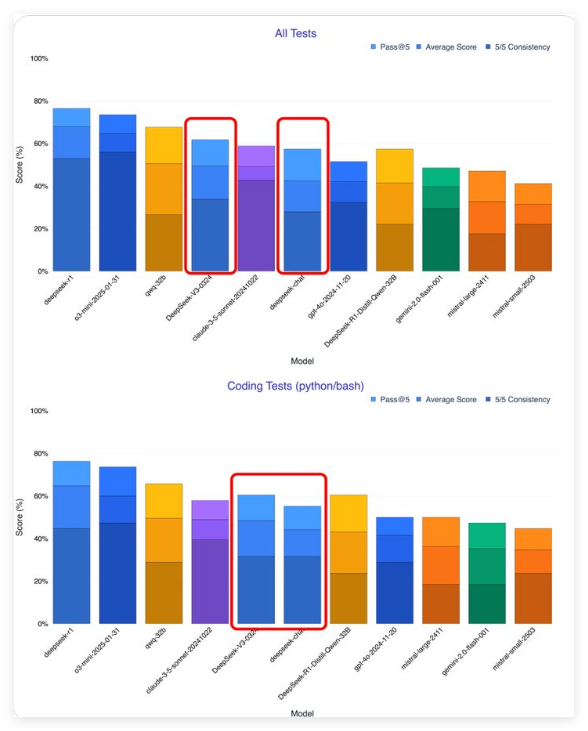

Selon les premiers testeurs, Deepseek-V3-0324 s'est considérablement amélioré par rapport à la version précédente. Le chercheur d'IA, Xeophon, affirme que le modèle a fait un énorme saut dans toutes les mesures de test, dépassant Claude Sonnet 3.5 d'Anthropic pour devenir le meilleur modèle non d'inférence. De plus, contrairement à Sonnet qui doit être abonné, le poids de Deepseek-V3-0324 peut être téléchargé gratuitement.

La stratégie de libération open source de Deepseek contraste fortement avec les sociétés de l'IA occidentale. Les États-Unis OpenAI et anthropic ont fixé des seuils de paiement pour les modèles, tandis que les sociétés d'IA chinois sont de plus en plus enclines à perdre des licences open source. Cette stratégie a accéléré le développement de l'écosystème de l'IA chinois, et les géants de la technologie tels que Baidu, Alibaba et Tencent ont également emboîté le pas et publié des modèles d'IA open source. Face aux restrictions des puces NVIDIA, les entreprises chinoises ont transformé leurs inconvénients en avantages concurrentiels en mettant l'accent sur l'efficacité et l'optimisation.

Deepseek-V3-0324 est probablement la base du prochain modèle d'inférence Deepseek-R2. La demande de calcul du modèle d'inférence actuel est énorme. Si Deepseek-R2 fonctionne bien, il posera un défi direct au GPT-5 de l'Openai.

Pour les utilisateurs et les développeurs qui souhaitent découvrir Deepseek-V3-0324, le poids complet du modèle peut être téléchargé en étreinte, mais les fichiers sont grands et nécessitent des ressources de stockage et informatiques élevées. Vous pouvez également choisir des services cloud, tels que OpenRouter, qui offre un accès API gratuit et une interface de chat amicale; L'interface de chat de Deepseek peut également avoir été mise à jour pour prendre en charge de nouvelles versions. Les développeurs peuvent également intégrer le modèle par le biais de fournisseurs de services de raisonnement tels que les laboratoires hyperboliques.

Il convient de noter que Deepseek-V3-0324 a changé dans le style de communication, d'un style de dialogue de type humain à un style plus formel et technique. Ce changement est destiné à s'adapter aux scénarios d'application professionnelle et technique, mais peut affecter son attrait dans les applications axées sur les consommateurs.

La stratégie open source de Deepseek est de remodeler le paysage mondial de l'IA. Auparavant, l'espace de l'IA de la Chine avec les États-Unis était dans 1 à 2 ans, mais maintenant il s'est considérablement réduit à 3 à 6 mois, et certaines régions ont même atteint le rattrapage. Tout comme les systèmes Android acquièrent une domination mondiale grâce à l'open source, le modèle d'IA open source devrait se démarquer dans la concurrence avec un large éventail d'applications et des innovations collectives de développeurs et promouvoir l'application plus large de la technologie d'IA.