Sitio web oficial www.binance.com/zh-cn :ingrese el sitio web oficial ☜☜

Aplicación: ☞☞Official App Download☜☜

La startup de inteligencia artificial china Deepseek recientemente lanzó en silencio su último modelo lingüístico a gran escala, Deepseek-V3-0324, que ha atraído una atención generalizada en la industria de la inteligencia artificial. El modelo aparece en la Biblioteca de Recursos AI que abraza la cara a 641GB, continuando con el estilo discreto habitual de Deepseek. No lleva a cabo publicidad a gran escala, y solo viene con un archivo readme vacío y pesas de modelo.

Este modelo tiene licencia de MIT, lo que permite que se use de forma gratuita con fines comerciales y puede ejecutarse directamente en hardware de grado de consumo, como el Apple Mac Studio con el M3 Ultra Chip. El investigador de AI, Awni Hannun, reveló en las redes sociales que la versión cuantitativa de 4 bits de Deepseek-V3-0324 se extiende más rápido que 20 tokens por segundo en un Chip Ultra de 512 GB M3. A pesar del alto precio de Mac Studio, poder ejecutar un modelo tan a gran escala rompe localmente la dependencia previa de la IA superior en los centros de datos.

Deepseek-V3-0324 adopta una arquitectura de experto híbrido (MOE), que activa solo unos 37 mil millones de parámetros en lugar de todos los 685 mil millones de parámetros al realizar tareas, mejorando en gran medida la eficiencia. Al mismo tiempo, el modelo también incorpora tecnologías de atención potencial (MLA) y predicción múltiple (MTP). MLA mejora la capacidad de comprensión contextual del modelo en textos largos. MTP permite que el modelo genere múltiples tokens a la vez, y la velocidad de salida aumenta en casi un 80%. La versión cuantificada de 4 bits reduce la demanda de almacenamiento a 352 GB, lo que permite ejecutarse en hardware de alta gama.

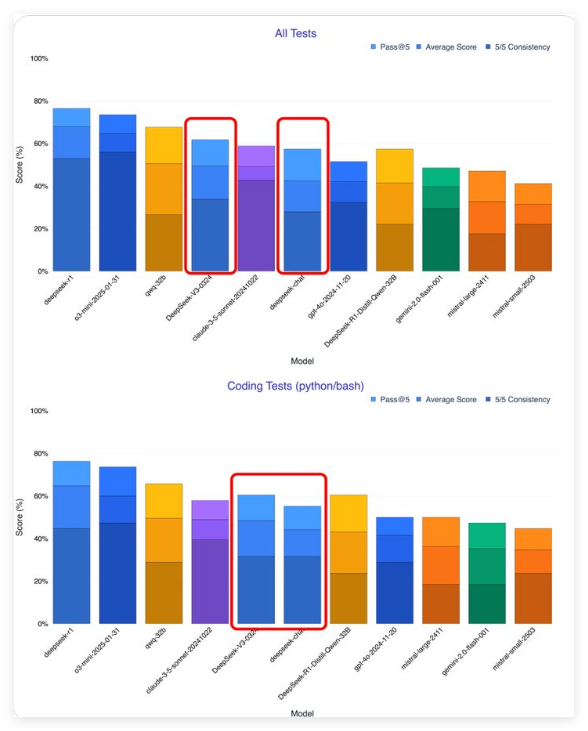

Según los primeros probadores, Deepseek-V3-0324 ha mejorado significativamente en comparación con la versión anterior. El investigador de IA Xeophon afirma que el modelo ha dado un gran salto en todas las métricas de prueba, superando el soneto 3.5 de Claude de Anthrope para convertirse en el mejor modelo de no inferencia. Además, a diferencia del soneto al que debe suscribirse, el peso de Deepseek-V3-0324 se puede descargar de forma gratuita.

La estrategia de lanzamiento de código abierto de Deepseek contrasta con las compañías de IA occidentales. El OpenAI y Anthrope de los Estados Unidos han establecido umbrales de pago para los modelos, mientras que las compañías chinas de IA están cada vez más inclinadas a perder las licencias de código abierto. Esta estrategia ha acelerado el desarrollo del ecosistema de IA de China, y los gigantes tecnológicos como Baidu, Alibaba y Tencent también han seguido su ejemplo y han lanzado modelos de IA de código abierto. Enfrentando las restricciones de chips nvidia, las compañías chinas han transformado sus desventajas en ventajas competitivas al enfatizar la eficiencia y la optimización.

Es probable que Deepseek-V3-0324 sea la base del próximo modelo de inferencia Deepseek-R2. La demanda de computación del modelo de inferencia actual es enorme. Si Deepseek-R2 funciona bien, planteará un desafío directo al rumoreado GPT-5 de OpenAI.

Para los usuarios y desarrolladores que desean experimentar Deepseek-V3-0324, el peso del modelo completo se puede descargar de la cara abrazada, pero los archivos son grandes y requieren altos recursos de almacenamiento y computación. También puede elegir servicios en la nube, como OpenRouter, que proporciona acceso a API gratuito y una interfaz de chat amigable; La propia interfaz de chat de Deepseek también puede haberse actualizado para admitir nuevas versiones. Los desarrolladores también pueden integrar el modelo a través de proveedores de servicios de razonamiento, como laboratorios hiperbólicos.

Vale la pena señalar que Deepseek-V3-0324 ha cambiado en estilo de comunicación, desde un estilo de diálogo humano hasta un estilo más formal y técnico. Este cambio está destinado a adaptarse a escenarios de aplicaciones profesionales y técnicas, pero puede afectar su atractivo en aplicaciones orientadas al consumidor.

La estrategia de código abierto de Deepseek es remodelar el panorama global de IA. Anteriormente, la brecha de IA de China con Estados Unidos estaba a 1-2 años de distancia, pero ahora se ha reducido significativamente a 3-6 meses, y algunas áreas incluso han logrado ponerse al día. Así como los sistemas Android obtienen dominio global a través de código abierto, se espera que el modelo de IA de código abierto se destaque en la competencia con una amplia gama de aplicaciones e innovaciones colectivas de desarrolladores y promueva la aplicación más amplia de la tecnología de IA.