Recentemente, a Universidade de Stanford divulgou os últimos resultados da lista de avaliação de grandes modelos HELM MMLU, que atraiu ampla atenção na indústria. Com seus rigorosos padrões de avaliação e processo de avaliação transparente, esta lista fornece uma referência confiável para a avaliação de desempenho de grandes modelos. Os resultados da lista mostram que o modelo Tongyi Qianwen Qwen2-72B da Alibaba se destaca entre muitos modelos e alcançou resultados impressionantes, demonstrando o progresso significativo da tecnologia de grandes modelos da China.

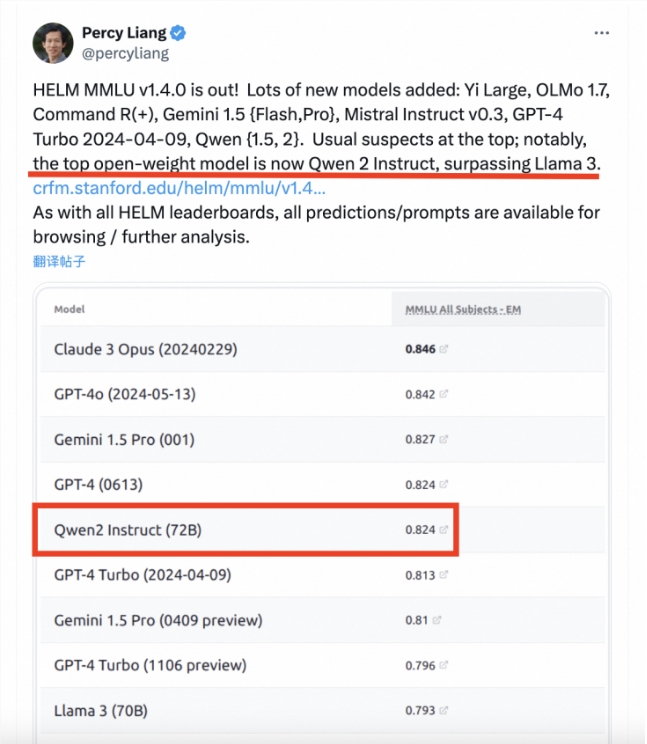

Recentemente, a grande lista de avaliação de modelos da Universidade de Stanford, HELM MMLU, divulgou os resultados mais recentes. Percy Liang, diretor do Centro de Pesquisa de Modelos Básicos da Universidade de Stanford, publicou um artigo apontando que o modelo Tongyi Qianwen Qwen2-72B do Alibaba ultrapassou o Llama3-70B nas classificações e se tornou o grande modelo de código aberto com melhor desempenho. MMLU (Massive Multitask Language Understanding) é um dos benchmarks de avaliação de grandes modelos mais influentes do setor. Abrange 57 tarefas, incluindo matemática básica, ciência da computação, direito, história, etc., e é projetado para testar o conhecimento mundial e as habilidades de resolução de problemas em grandes modelos. No entanto, na avaliação real, os resultados de diferentes modelos muitas vezes carecem de consistência e comparabilidade. Isto deve-se principalmente à utilização de tecnologia de palavra rápida não padronizada e à incapacidade de adoptar uniformemente quadros de avaliação de código aberto.

O excelente desempenho do Qwen2-72B não reflete apenas a forte força técnica do Alibaba no campo da IA, mas também injeta um forte impulso no desenvolvimento de grandes modelos na China. Acredito que, no futuro, mais grandes modelos chineses mostrarão a sua notável força no cenário internacional.