Recientemente, la Universidad de Stanford publicó los últimos resultados de la lista de evaluación de modelos grandes HELM MMLU, que ha atraído una amplia atención en la industria. Con sus estrictos estándares de evaluación y su proceso de evaluación transparente, esta lista proporciona una referencia confiable para la evaluación del desempeño de modelos grandes. Los resultados de la lista muestran que el modelo Tongyi Qianwen Qwen2-72B de Alibaba se destaca entre muchos modelos y ha logrado resultados impresionantes, lo que demuestra el progreso significativo de la tecnología de modelos grandes de China.

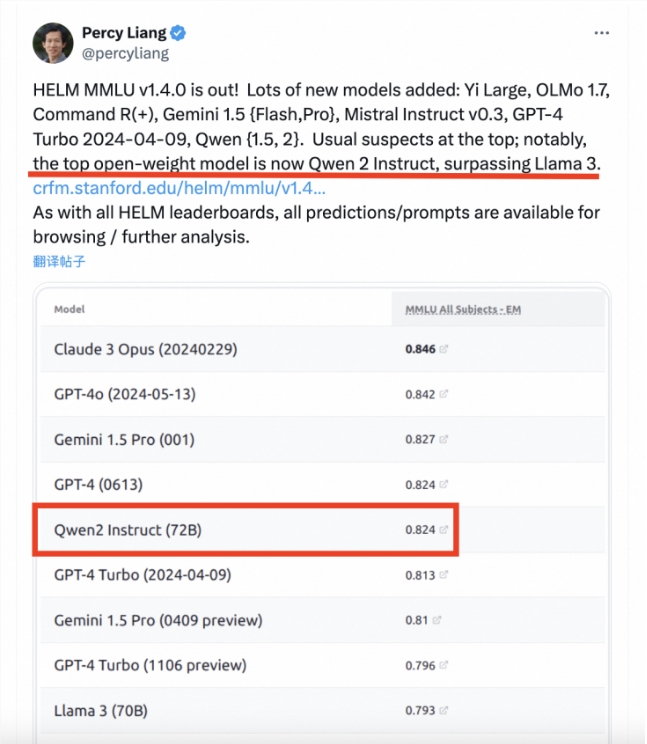

Recientemente, la gran lista de evaluación de modelos HELM MMLU de la Universidad de Stanford publicó los últimos resultados. Percy Liang, director del Centro de Investigación de Modelos Básicos de la Universidad de Stanford, publicó un artículo señalando que el modelo Tongyi Qianwen Qwen2-72B de Alibaba superó a Llama3-70B en la clasificación y se convirtió en el modelo grande de código abierto con mejor rendimiento. MMLU (Massive Multitask Language Understanding) es uno de los puntos de referencia de evaluación de modelos grandes más influyentes de la industria. Cubre 57 tareas que incluyen matemáticas básicas, informática, derecho, historia, etc., y está diseñado para evaluar el conocimiento mundial y las habilidades de resolución de problemas en modelos grandes. Sin embargo, en la evaluación real, los resultados de diferentes modelos a menudo carecen de coherencia y comparabilidad. Esto se debe principalmente al uso de tecnología de palabras rápidas no estándar y a la falta de adopción uniforme de marcos de evaluación de código abierto.

El excelente desempeño del Qwen2-72B no solo refleja la sólida fortaleza técnica de Alibaba en el campo de la IA, sino que también inyecta un fuerte impulso al desarrollo de modelos grandes en China. Creo que en el futuro, más modelos grandes chinos mostrarán su destacada fuerza en el escenario internacional.