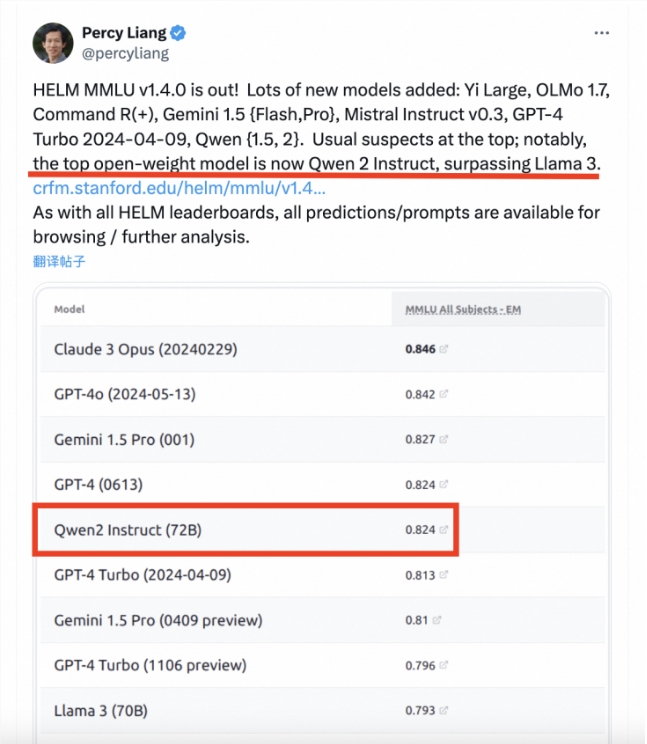

Récemment, l'Université de Stanford a publié les derniers résultats de la liste d'évaluation des grands modèles HELM MMLU, qui ont attiré une large attention dans l'industrie. Avec ses normes d'évaluation strictes et son processus d'évaluation transparent, cette liste constitue une référence fiable pour l'évaluation des performances des grands modèles. Les résultats de la liste montrent que le modèle Tongyi Qianwen Qwen2-72B d'Alibaba se démarque parmi de nombreux modèles et a obtenu des résultats impressionnants, démontrant les progrès significatifs de la technologie chinoise des grands modèles.

Récemment, la liste d'évaluation des grands modèles de l'Université de Stanford, HELM MMLU, a publié les derniers résultats. Percy Liang, directeur du Basic Model Research Center de l'Université de Stanford, a publié un article soulignant que le modèle Tongyi Qianwen Qwen2-72B d'Alibaba a dépassé le Llama3-70B dans le classement et est devenu le grand modèle open source le plus performant. MMLU (Massive Multitask Language Understanding) est l'un des critères d'évaluation de grands modèles les plus influents du secteur. Il couvre 57 tâches, dont les mathématiques de base, l'informatique, le droit, l'histoire, etc., et est conçu pour tester les connaissances du monde et les capacités de résolution de problèmes dans de grands modèles. Cependant, dans l'évaluation réelle, les résultats des différents modèles manquent souvent de cohérence et de comparabilité. Cela est principalement dû à l'utilisation d'une technologie de mots d'invite non standard et à l'incapacité d'adopter uniformément des cadres d'évaluation open source.

Les performances exceptionnelles du Qwen2-72B reflètent non seulement la forte force technique d’Alibaba dans le domaine de l’IA, mais donnent également une forte impulsion au développement de grands modèles en Chine. Je crois qu'à l'avenir, davantage de grands modèles chinois montreront leur force exceptionnelle sur la scène internationale.