أصدرت جامعة ستانفورد مؤخرًا أحدث نتائج قائمة تقييم النماذج الكبيرة HELM MMLU، والتي جذبت اهتمامًا واسع النطاق في الصناعة. بفضل معايير التقييم الصارمة وعملية التقييم الشفافة، توفر هذه القائمة مرجعًا موثوقًا لتقييم أداء النماذج الكبيرة. وتظهر نتائج القائمة أن نموذج Tongyi Qianwen Qwen2-72B الخاص بشركة علي بابا يبرز بين العديد من النماذج وقد حقق نتائج مبهرة، مما يدل على التقدم الكبير الذي حققته تكنولوجيا النماذج الكبيرة في الصين.

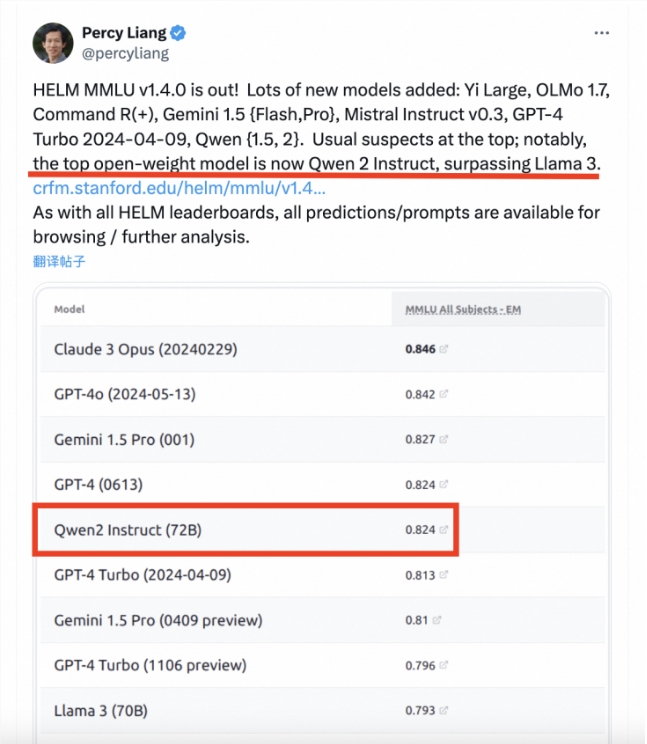

في الآونة الأخيرة، أصدرت قائمة تقييم النماذج الكبيرة لجامعة ستانفورد HELM MMLU أحدث النتائج. نشر بيرسي ليانغ، مدير مركز أبحاث النماذج الأساسية في جامعة ستانفورد، مقالًا يشير فيه إلى أن نموذج Tongyi Qianwen Qwen2-72B التابع لشركة علي بابا قد تجاوز Llama3-70B في التصنيفات وأصبح النموذج الكبير مفتوح المصدر الأفضل أداءً. يعد MMLU (فهم اللغة متعدد المهام الضخم) واحدًا من أكثر معايير تقييم النماذج الكبيرة تأثيرًا في الصناعة. ويغطي 57 مهمة بما في ذلك الرياضيات الأساسية وعلوم الكمبيوتر والقانون والتاريخ وما إلى ذلك، وهو مصمم لاختبار المعرفة العالمية وقدرات حل المشكلات في نماذج كبيرة. ومع ذلك، في التقييم الفعلي، غالبًا ما تفتقر نتائج النماذج المختلفة إلى الاتساق وقابلية المقارنة. ويرجع ذلك أساسًا إلى استخدام تقنية الكلمات السريعة غير القياسية والفشل في اعتماد أطر التقييم مفتوحة المصدر بشكل موحد.

لا يعكس الأداء المتميز لـ Qwen2-72B القوة التقنية القوية لشركة علي بابا في مجال الذكاء الاصطناعي فحسب، بل يضخ أيضًا زخمًا قويًا في تطوير النماذج الكبيرة في الصين. وأعتقد أنه في المستقبل، ستظهر المزيد من النماذج الصينية الكبيرة قوتها المتميزة على الساحة الدولية.