RL for Question Generation

1.0.0

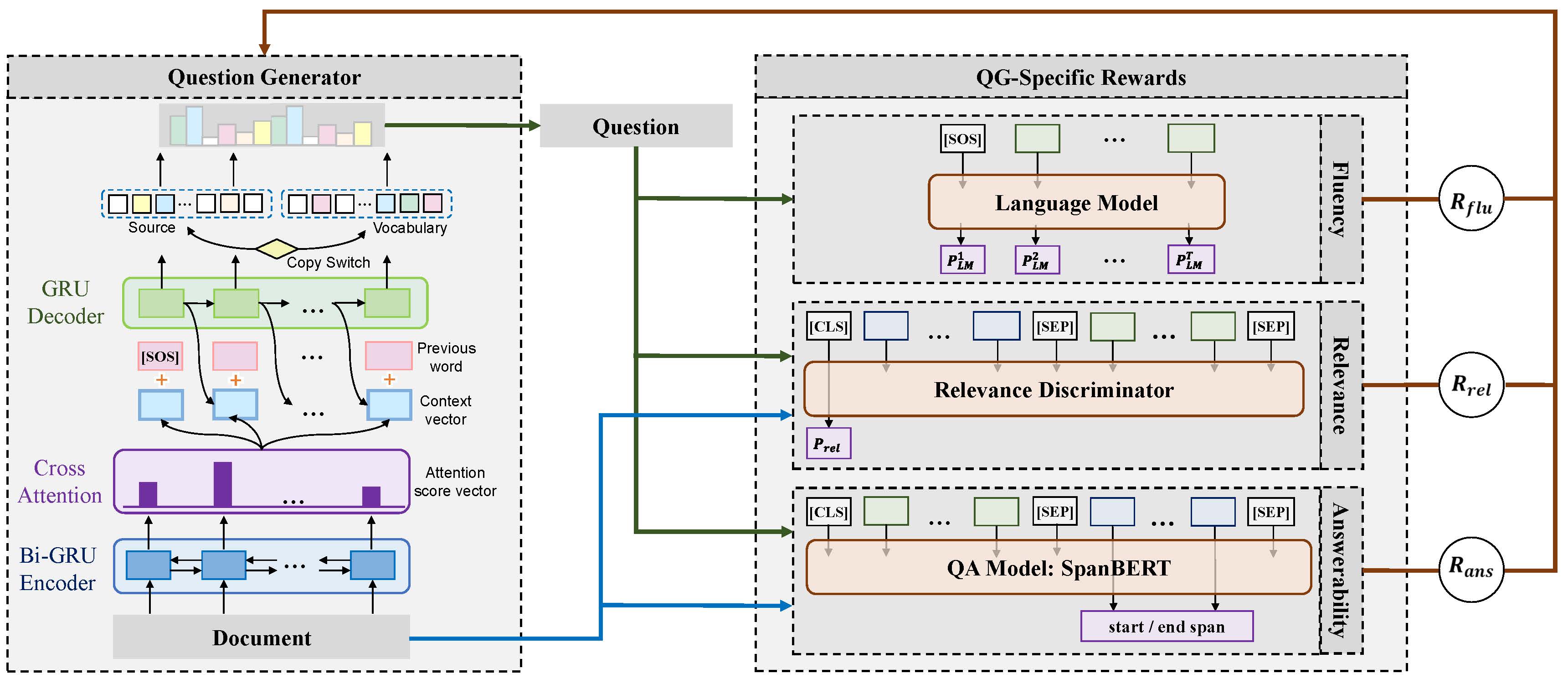

Este repositório contém códigos e modelos para o artigo: Explorando recompensas específicas de perguntas para gerar perguntas profundas (Coling 2020 Oral). Abaixo está a estrutura do nosso modelo proposto.

pytorch 1.4.0

nltk 3.4.4

numpy 1.18.1

tqdm 4.32.2

scripts/train_example.sh para treinar o modelo de conjunto que utiliza todas as três recompensas. scripts/translate_example.sh para obter a previsão no conjunto de dados de validação. Tomamos o uso dos códigos de avaliação para a geração de legendas MS para avaliação em métricas automáticas.

pip install git+https://github.com/salaniz/pycocoevalcap

prediction.txt , execute: python evaluate_metrics.py prediction.txt

@inproceedings{xie-etal-2020-RLQG,

title = {Exploring Question-Specific Rewards for Generating Deep Questions},

author = {Xie, Yuxi and Pan, Liangming and Wang, Dongzhe and Kan, Min-Yen and Feng, Yansong},

booktitle = {The 28th International Conference on Computational Linguistics (COLING 2020)},

year = {2020}

}