RL for Question Generation

1.0.0

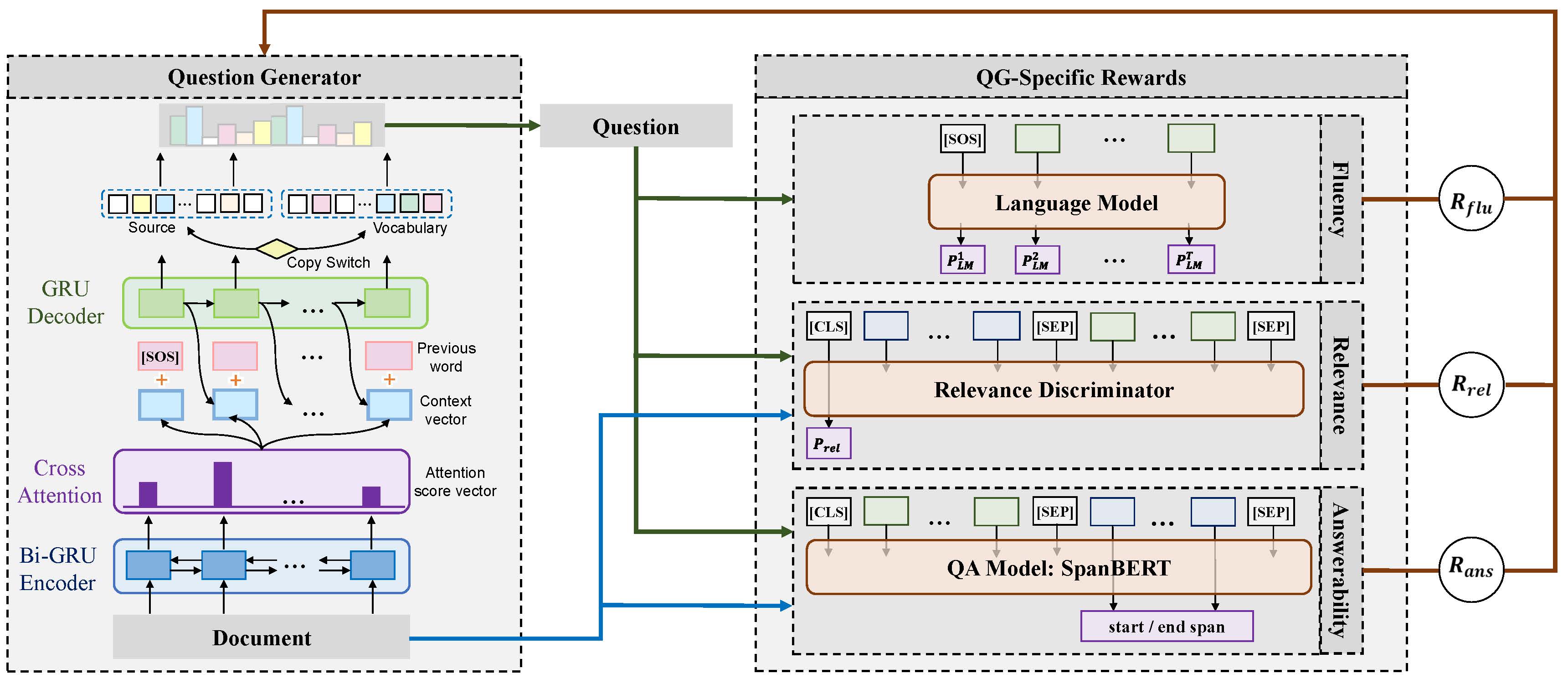

이 저장소에는 논문에 대한 코드와 모델이 포함되어 있습니다. 깊은 질문을 생성하기위한 질문 별 보상 (Coling 2020 Oral). 아래는 제안 된 모델의 프레임 워크입니다.

pytorch 1.4.0

nltk 3.4.4

numpy 1.18.1

tqdm 4.32.2

scripts/train_example.sh 를 실행하여 세 가지 보상을 모두 사용하는 앙상블 모델을 훈련시킵니다. scripts/translate_example.sh 실행하여 유효성 검사 데이터 세트에서 예측을 받으십시오. 자동 지표에 대한 평가를 위해 MS Coco 캡션 생성에 대한 평가 코드를 사용합니다.

pip install git+https://github.com/salaniz/pycocoevalcap

prediction.txt , run : python evaluate_metrics.py prediction.txt

@inproceedings{xie-etal-2020-RLQG,

title = {Exploring Question-Specific Rewards for Generating Deep Questions},

author = {Xie, Yuxi and Pan, Liangming and Wang, Dongzhe and Kan, Min-Yen and Feng, Yansong},

booktitle = {The 28th International Conference on Computational Linguistics (COLING 2020)},

year = {2020}

}