RL for Question Generation

1.0.0

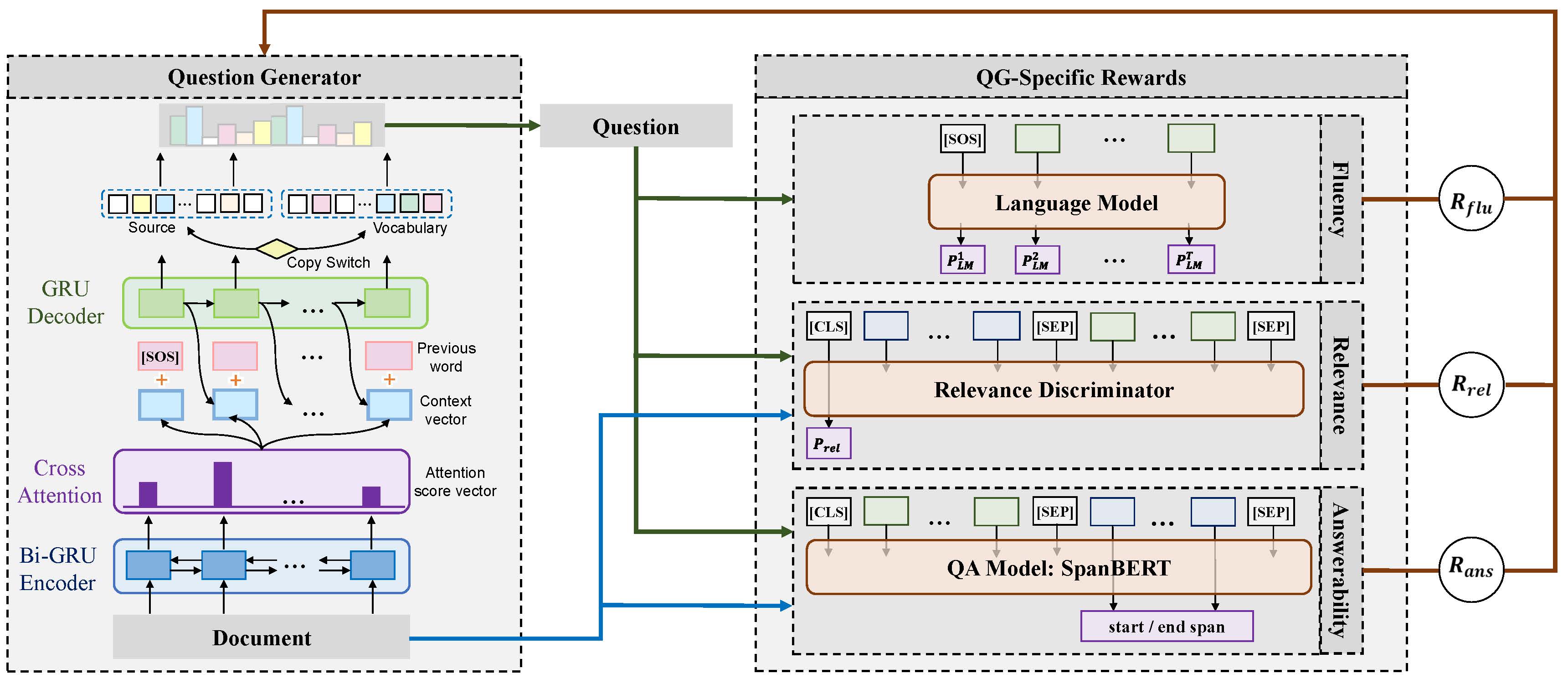

Ce référentiel contient des codes et des modèles pour l'article: explorer des récompenses spécifiques à des questions pour générer des questions profondes (coling 2020 oral). Vous trouverez ci-dessous le cadre de notre modèle proposé.

pytorch 1.4.0

nltk 3.4.4

numpy 1.18.1

tqdm 4.32.2

scripts/train_example.sh pour former le modèle d'ensemble qui utilise les trois récompenses. scripts/translate_example.sh pour obtenir la prédiction sur l'ensemble de données de validation. Nous utilisons les codes d'évaluation pour la génération de légendes de MS Coco pour l'évaluation des mesures automatiques.

pip install git+https://github.com/salaniz/pycocoevalcap

prediction.txt , exécuter: python evaluate_metrics.py prediction.txt

@inproceedings{xie-etal-2020-RLQG,

title = {Exploring Question-Specific Rewards for Generating Deep Questions},

author = {Xie, Yuxi and Pan, Liangming and Wang, Dongzhe and Kan, Min-Yen and Feng, Yansong},

booktitle = {The 28th International Conference on Computational Linguistics (COLING 2020)},

year = {2020}

}