RL for Question Generation

1.0.0

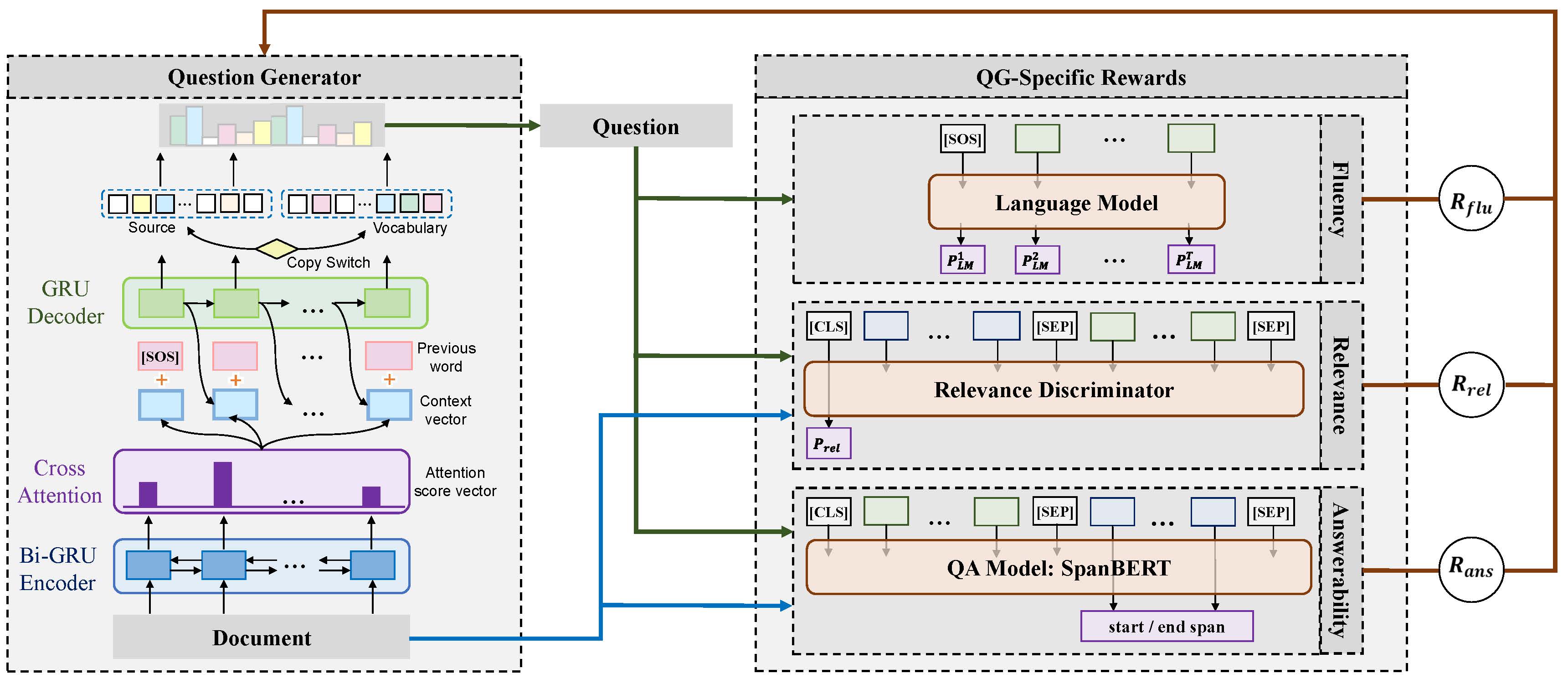

Este repositorio contiene códigos y modelos para el documento: explorar recompensas específicas de las preguntas para generar preguntas profundas (Coling 2020 Oral). A continuación se muestra el marco de nuestro modelo propuesto.

pytorch 1.4.0

nltk 3.4.4

numpy 1.18.1

tqdm 4.32.2

scripts/train_example.sh para entrenar el modelo de conjunto que utiliza las tres recompensas. scripts/translate_example.sh para obtener la predicción en el conjunto de datos de validación. Tomamos el uso de los códigos de evaluación para la generación de subtítulos de Coco para la evaluación de métricas automáticas.

pip install git+https://github.com/salaniz/pycocoevalcap

prediction.txt , ejecutar: python evaluate_metrics.py prediction.txt

@inproceedings{xie-etal-2020-RLQG,

title = {Exploring Question-Specific Rewards for Generating Deep Questions},

author = {Xie, Yuxi and Pan, Liangming and Wang, Dongzhe and Kan, Min-Yen and Feng, Yansong},

booktitle = {The 28th International Conference on Computational Linguistics (COLING 2020)},

year = {2020}

}