RL for Question Generation

1.0.0

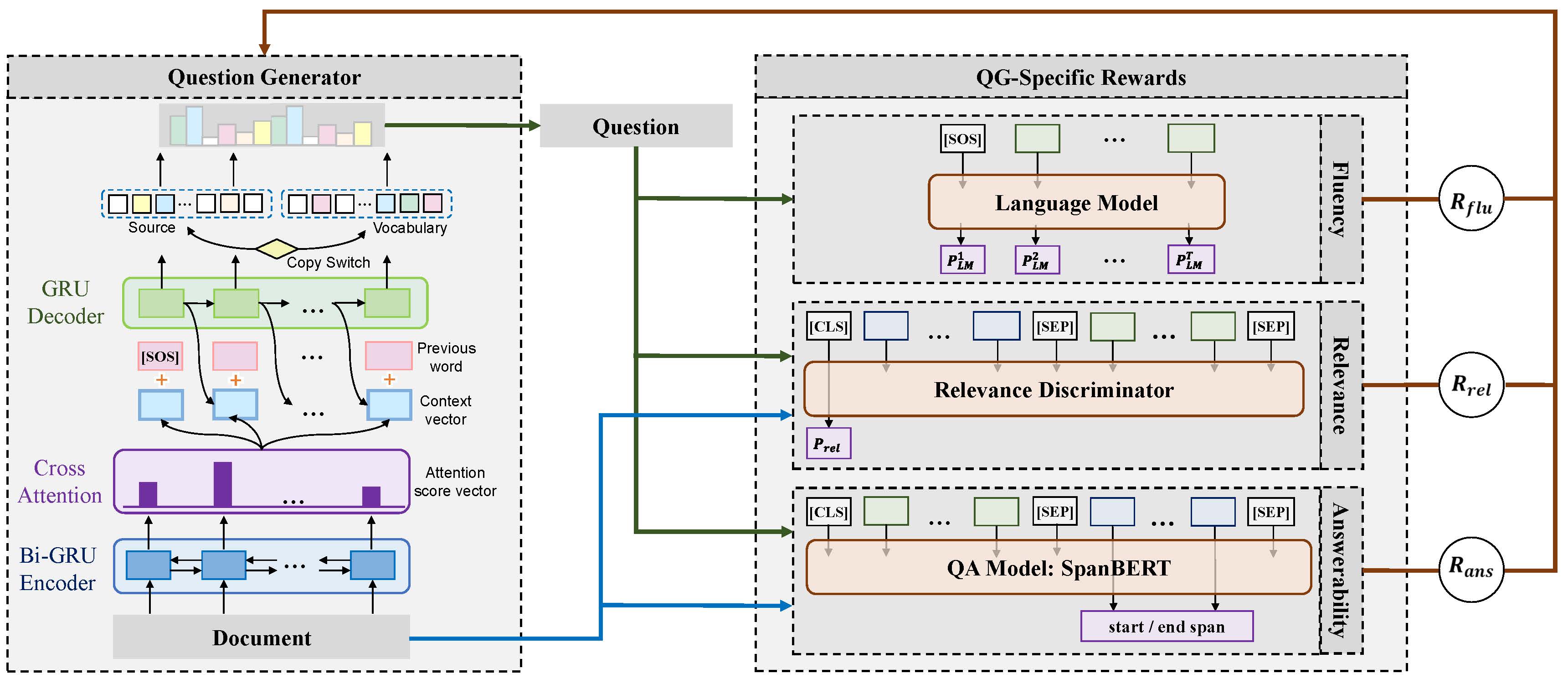

Dieses Repository enthält Codes und Modelle für das Papier: Erkundung von fragebetriebenen Belohnungen für die Erzeugung von tiefen Fragen (Coling 2020 Oral). Unten ist der Rahmen unseres vorgeschlagenen Modells.

pytorch 1.4.0

nltk 3.4.4

numpy 1.18.1

tqdm 4.32.2

scripts/train_example.sh um das Ensemble -Modell zu trainieren, das alle drei Belohnungen verwendet. scripts/translate_example.sh um die Vorhersage im Validierungsdatensatz zu erhalten. Wir verwenden die Bewertungscodes für die Erzeugung von MS Coco caption zur Bewertung der automatischen Metriken.

pip install git+https://github.com/salaniz/pycocoevalcap

prediction.txt , zu bewerten, rennen Sie: python evaluate_metrics.py prediction.txt

@inproceedings{xie-etal-2020-RLQG,

title = {Exploring Question-Specific Rewards for Generating Deep Questions},

author = {Xie, Yuxi and Pan, Liangming and Wang, Dongzhe and Kan, Min-Yen and Feng, Yansong},

booktitle = {The 28th International Conference on Computational Linguistics (COLING 2020)},

year = {2020}

}