Reproduzindo aprendizado neural de representação discreta

Projeto do curso para IFT 6135 - Aprendizagem de representação

Link do relatório do projeto: final_project.pdf

Instruções

- Para treinar o VQVAE com argumentos padrão, conforme discutido no relatório, execute:

python vqvae.py --data-folder /tmp/miniimagenet --output-folder models/vqvae

- Para treinar o pixelcnn antes dos latentes, execute:

python pixelcnn_prior.py --data-folder /tmp/miniimagenet --model models/vqvae --output-folder models/pixelcnn_prior

Conjuntos de dados testados

Imagem

- Mnist

- FashionMnist

- Cifar10

- Mini-imagena

Vídeo

- Atari 2600 - Código de boxe (academia OpenAi)

Reconstruções de VQ-VAE

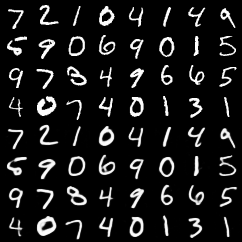

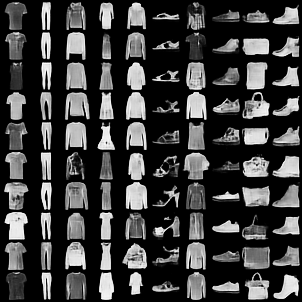

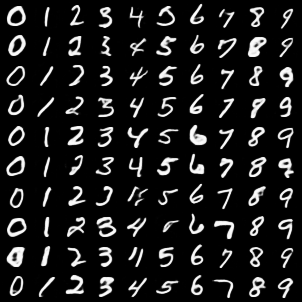

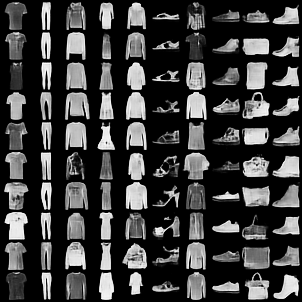

As 4 principais linhas são imagens originais. 4 linhas inferiores são reconstruções.

Mnist

Moda mnist

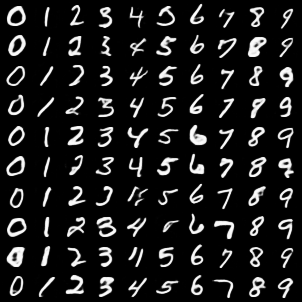

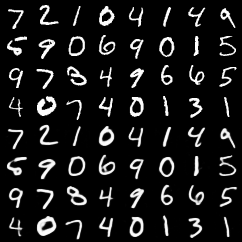

Amostras de classe condicionais de VQVAE com pixelcnn antes dos latentes

Mnist

Moda mnist

Comentários

- Percebemos que a implementação da nossa própria função de Pytorch de vetorquantização acelerou o treinamento de VQ-VAE em quase 3x. O código mais lento, mas mais simples, estiver nesse compromisso.

- Adicionamos alguns testes básicos para as funções de quantização do vetor (com base no

pytest ). Para executar esses testes

Autores

- Rithesh Kumar

- Tristan Deleu

- Evan Racah