استنساخ التعلم التمثيل المنفصل العصبي

مشروع الدورة لـ IFT 6135 - التعلم التمثيل

رابط تقرير المشروع: final_project.pdf

تعليمات

- لتدريب Vqvae مع الحجج الافتراضية كما تمت مناقشتها في التقرير ، تنفيذ:

python vqvae.py --data-folder /tmp/miniimagenet --output-folder models/vqvae

- لتدريب pixelcnn مسبقا على اللاتينات ، تنفيذ:

python pixelcnn_prior.py --data-folder /tmp/miniimagenet --model models/vqvae --output-folder models/pixelcnn_prior

تم اختبار مجموعات البيانات

صورة

- mnist

- الموضة

- CIFAR10

- تصورات مصغرة

فيديو

- Atari 2600 - رمز الملاكمة (Openai Gym)

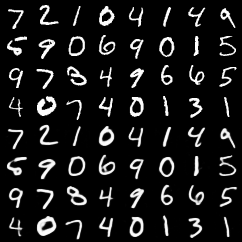

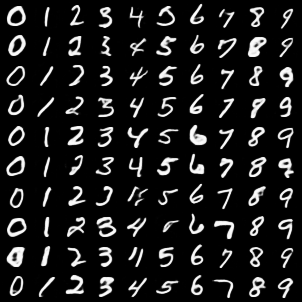

عمليات إعادة البناء من VQ-VAE

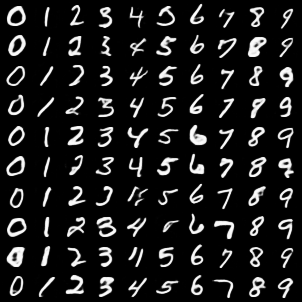

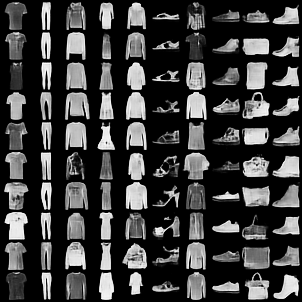

أفضل 4 صفوف هي صور أصلية. الصفوف السفلية 4 هي إعادة البناء.

mnist

الموضة mnist

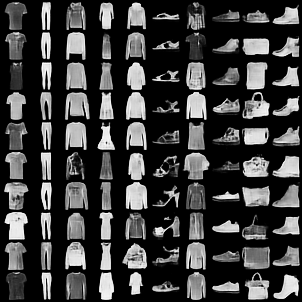

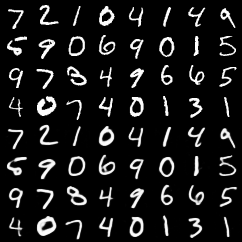

عينات تقليدية من VQVAE مع Pixelcnn قبل على اللاتينات

mnist

الموضة mnist

تعليقات

- لقد لاحظنا أن تنفيذ تدريبات Pytorch Pytorch المتجهة الخاصة بنا قد تسببت في تدريب VQ-VAE بمقدار 3x تقريبًا. رمز أبطأ ، ولكن أبسط في هذا الالتزام.

- أضفنا بعض الاختبارات الأساسية لوظائف تقدير المتجه (استنادًا إلى

pytest ). لتشغيل هذه الاختبارات

المؤلفون

- ريثش كومار

- تريستان ديليو

- إيفان راكاه