Reproduisant l'apprentissage de la représentation discrète neuronale

Projet de cours pour IFT 6135 - Apprentissage de la représentation

Lien de rapport de projet: final_project.pdf

Instructions

- Pour former le VQVAE avec des arguments par défaut comme discuté dans le rapport, exécutez:

python vqvae.py --data-folder /tmp/miniimagenet --output-folder models/vqvae

- Pour former le pixelcnn précédent sur les latents, exécutez:

python pixelcnn_prior.py --data-folder /tmp/miniimagenet --model models/vqvae --output-folder models/pixelcnn_prior

Ensembles de données testés

Image

- MNIST

- Mode

- Cifar10

- Mini-imagenet

Vidéo

- ATARI 2600 - Code de boxe (gymnase Openai)

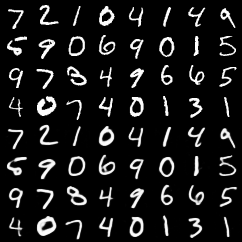

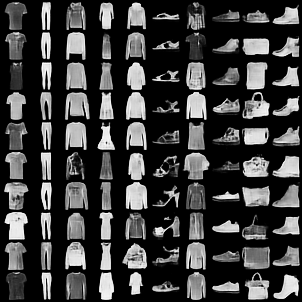

Reconstructions de VQ-VAE

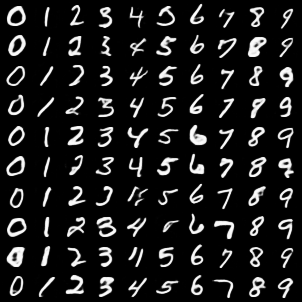

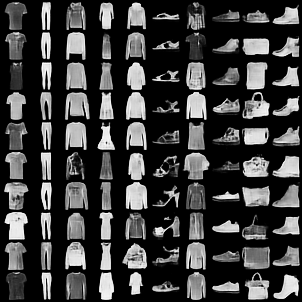

Les 4 meilleures lignes sont des images originales. Les 4 lignes inférieures sont des reconstructions.

MNIST

Mnist de la mode

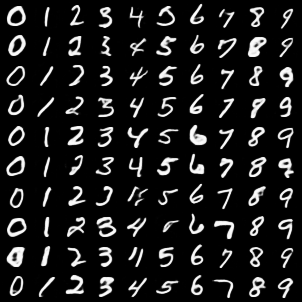

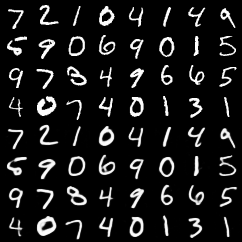

Échantillons de classe conditionnels de VQVAE avec Pixelcnn Prior sur les lameurs

MNIST

Mnist de la mode

Commentaires

- Nous avons remarqué que la mise en œuvre de notre propre fonction Pytorch de laquantication vectorielle a accéléré la formation de VQ-VAE de près de 3x. Le code plus lent, mais plus simple, est dans cette validation.

- Nous avons ajouté quelques tests de base pour les fonctions de quantification vectorielle (basée sur

pytest ). Pour exécuter ces tests

Auteurs

- Rithesh Kumar

- Tristan Deleu

- Evan Racah