Reproducir el aprendizaje de representación discreta neuronal

Proyecto del curso para IFT 6135 - Learning Representation

Enlace del informe del proyecto: final_project.pdf

Instrucciones

- Para capacitar a los VQVAE con argumentos predeterminados como se discutió en el informe, ejecute:

python vqvae.py --data-folder /tmp/miniimagenet --output-folder models/vqvae

- Para entrenar el PixelCnn Prior en los Latentes, ejecute:

python pixelcnn_prior.py --data-folder /tmp/miniimagenet --model models/vqvae --output-folder models/pixelcnn_prior

Conjuntos de datos probados

Imagen

- Mnista

- Fashionmnist

- Cifar10

- Mini iMagenet

Video

- Atari 2600 - Código de boxeo (gimnasio de Openai)

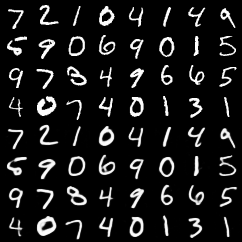

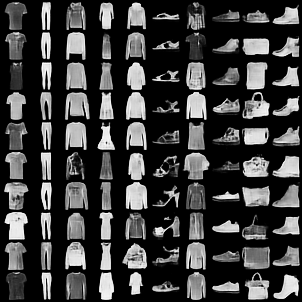

Reconstrucciones de VQ-VAE

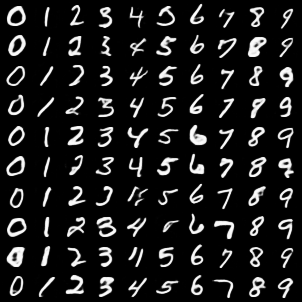

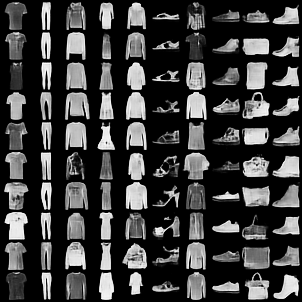

Las 4 filas principales son imágenes originales. Las 4 filas inferiores son reconstrucciones.

Mnista

Mnist de la moda

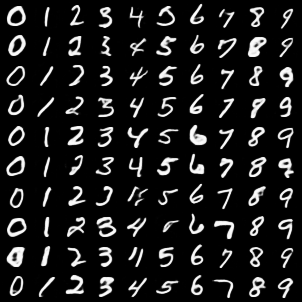

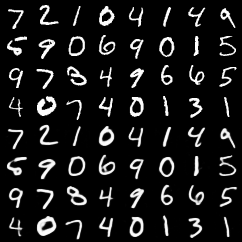

Muestras condicionales de clase de vqvae con Pixelcnn Prior en los latentes

Mnista

Mnist de la moda

Comentario

- Notamos que implementar nuestra propia función de Pytorch VectorCantización aceleró el entrenamiento de VQ-VAE en casi 3 veces. El código más lento pero más simple está en esta confirmación.

- Agregamos algunas pruebas básicas para las funciones de cuantización vectorial (basadas en

pytest ). Para ejecutar estas pruebas

Autores

- Rithesh Kumar

- Tristan Deleu

- Evan Racah