Reproduktion der neuronalen diskreten Repräsentation Lernen

Kursprojekt für IFT 6135 - Repräsentationslernen

Projektbericht Link: Final_project.pdf

Anweisungen

- Um die VQVAE mit Standardargumenten zu schulen, wie im Bericht erläutert, finden Sie aus:

python vqvae.py --data-folder /tmp/miniimagenet --output-folder models/vqvae

- Um die Pixelcnn -Vorgänger in den Latenten zu trainieren, führen Sie aus:

python pixelcnn_prior.py --data-folder /tmp/miniimagenet --model models/vqvae --output-folder models/pixelcnn_prior

Datensätze getestet

Bild

- MNIST

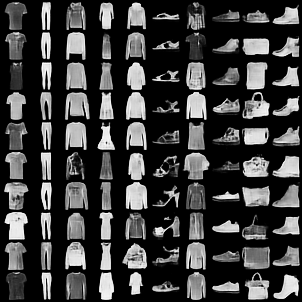

- FashionMnist

- CIFAR10

- Mini-Imagenet

Video

- Atari 2600 - Boxcode (OpenAI -Fitnessstudio)

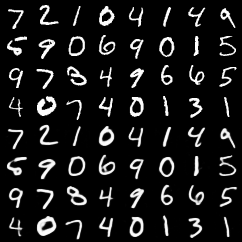

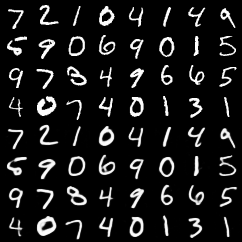

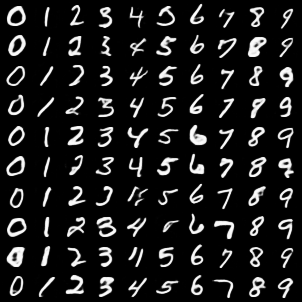

Rekonstruktionen von VQ-Vae

Top 4 Zeilen sind Originalbilder. Untere 4 Zeilen sind Rekonstruktionen.

MNIST

Mode mnist

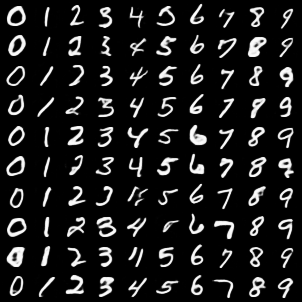

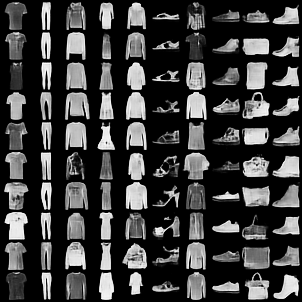

Klassenkonditionelle Proben aus VQVAE mit Pixelcnn vor den Latenten

MNIST

Mode mnist

Kommentare

- Wir haben festgestellt, dass die Implementierung unserer eigenen Vectorquantisation Pytorch-Funktion das Training von VQ-VAE um fast 3x beschleunigte. Der langsamere, aber einfachere Code ist in diesem Commit.

- Wir haben einige grundlegende Tests für die Vektorquantisierungsfunktionen hinzugefügt (basierend auf

pytest ). Diese Tests durchführen

Autoren

- Rithesh Kumar

- Tristan Deleu

- Evan Racah