De chatbots de pano a assistentes de código e pipelines agênticos complexos e além, construa sistemas LLM que funcionam melhor, mais rápidos e baratos com rastreamento, avaliações e painéis.

Site • Comunidade Slack • Twitter • Documentação

O Opik é uma plataforma de código aberto para avaliar, testar e monitorar aplicativos LLM. Construído por cometa.

Você pode usar o Opik para:

Desenvolvimento:

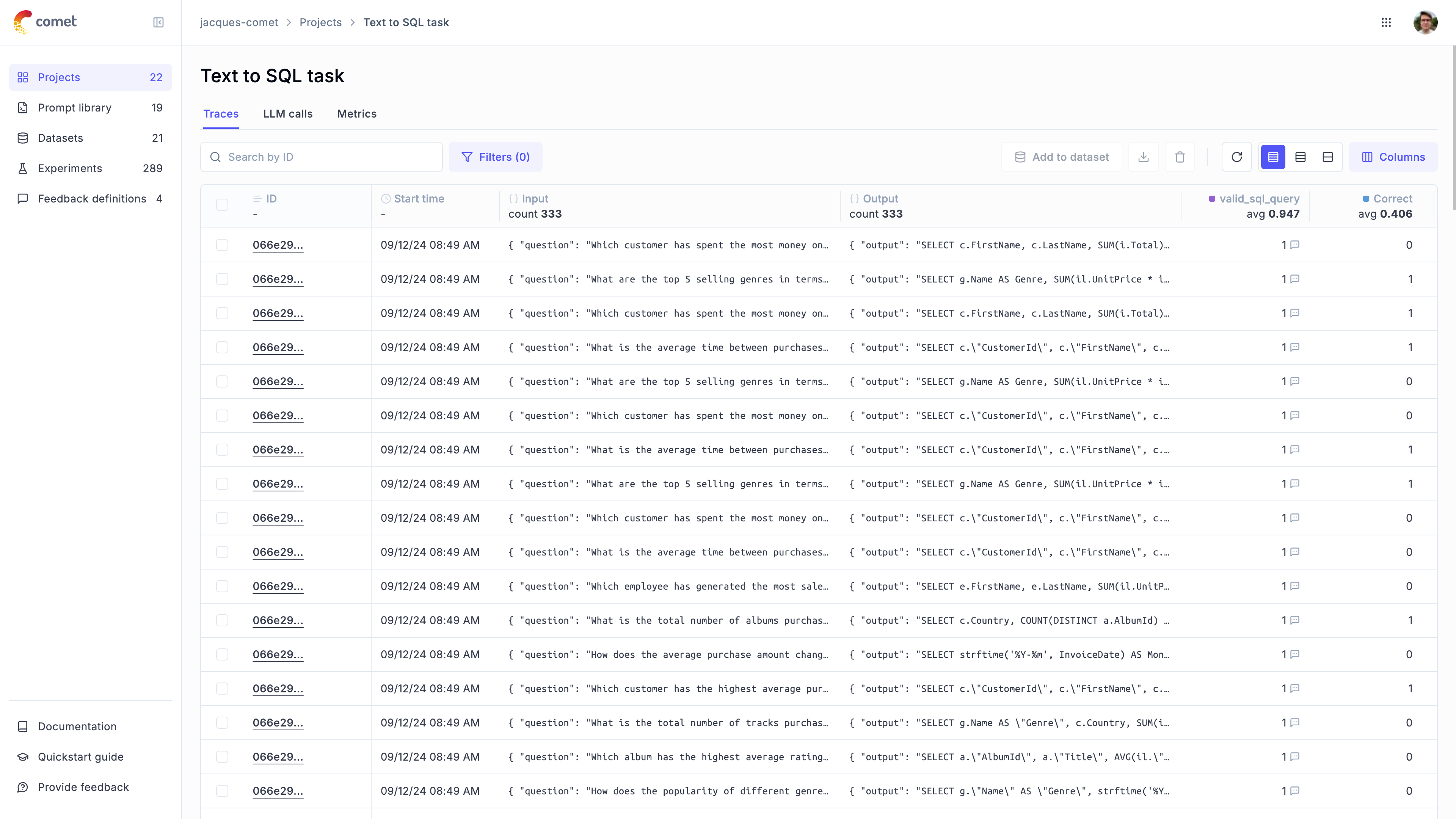

Rastreamento: Rastreie todas as chamadas e traços de LLM durante o desenvolvimento e produção (Quickstart, integrações

Anotações: anote suas chamadas LLM registrando as pontuações de feedback usando o Python SDK ou a interface do usuário.

Playground :: Experimente instruções e modelos diferentes no Playground Playground

Avaliação : automatize o processo de avaliação do seu aplicativo LLM:

Conjuntos de dados e experimentos : armazenar casos de teste e executar experimentos (conjuntos de dados, avaliar seu aplicativo LLM)

LLM como métricas de juiz : use o Opik's LLM como uma métrica de juiz para questões complexas, como detecção de alucinação, moderação e avaliação de pano (relevância da resposta, precisão do contexto

Integração do CI/CD : Execute avaliações como parte do seu pipeline CI/CD usando nossa integração de pytest

Monitoramento da produção :

Registre todos os seus traços de produção : o OPIK foi projetado para suportar altos volumes de traços, facilitando o monitoramento de seus aplicativos de produção. Até pequenas implantações podem ingerir mais de 40 milhões de traços por dia!

Monitorando os painéis : revise suas pontuações de feedback, contagem de rastreamentos e tokens ao longo do tempo no painel do Opik.

Métricas de avaliação on -line : pontuam facilmente todos os seus traços de produção usando o LLM como métricas de juiz e identifique qualquer problema com o seu aplicativo Production LLM graças às métricas de avaliação on -line da Opik

Dica

Se você está procurando recursos que o Opik não possui hoje, aumente uma nova solicitação de recurso

O Opik está disponível como uma instalação local de código aberto ou usando o Comet.com como uma solução hospedada. A maneira mais fácil de começar com o Opik é criando uma conta de cometa gratuita no Comet.com.

Se você quiser se auto-hospedar Opik, pode fazê-lo clonando o repositório e iniciando a plataforma usando o Docker Compose:

# Clone the Opik repository

git clone https://github.com/comet-ml/opik.git

# Navigate to the opik/deployment/docker-compose directory

cd opik/deployment/docker-compose

# Start the Opik platform

docker compose up --detach

# You can now visit http://localhost:5173 on your browser!Para obter mais informações sobre as diferentes opções de implantação, consulte nossos guias de implantação:

| Métodos de instalação | Link dos documentos |

|---|---|

| Instância local | |

| Kubernetes |

Para começar, você precisará primeiro instalar o Python SDK:

pip install opik Depois que o SDK estiver instalado, você pode configurá -lo executando o comando opik configure :

opik configureIsso permitirá que você configure o OPIK localmente, definindo o endereço do servidor local correto ou se você estiver usando a plataforma em nuvem, configurando a tecla API

Dica

Você também pode chamar o método opik.configure(use_local=True) do seu código Python para configurar o SDK para executar na instalação local.

Agora você está pronto para iniciar traços de log usando o Python SDK.

A maneira mais fácil de começar é usar uma de nossas integrações. Opik suporta:

| Integração | Descrição | Documentação | Tente em Colab |

|---|---|---|---|

| Openai | Log Rastrear para todas as chamadas OpenAi LLM | Documentação | |

| Litellm | Ligue para qualquer modelo LLM usando o formato OpenAI | Documentação | |

| Langchain | Rastreios de log para todas as chamadas Langchain LLM | Documentação | |

| Palheiro | Rastreios de log para todas as chamadas de palheiro | Documentação | |

| Antrópico | Rastreios de log para todas as chamadas antrópicas de LLM | Documentação | |

| Bedrock | Rastreios de log para todas as chamadas Bedrock LLM | Documentação | |

| Crewai | Log Rastrear para todas as chamadas de tripulação | Documentação | |

| Deepseek | Rastreios de log para todas as chamadas do Deepseek LLM | Documentação | |

| Dspy | Tracas de log para todas as execuções DSPY | Documentação | |

| Gêmeos | Log Rastrear para todas as chamadas Gemini LLM | Documentação | |

| Groq | Rastreios de log para todas as chamadas Groq LLM | Documentação | |

| Guardrails | Tracas de log para todas as validações de guardrails | Documentação | |

| Langgraph | Rastreios de log para todas as execuções de Langgraph | Documentação | |

| Llamaindex | Rastreios de log para todas as chamadas do Llamaindex LLM | Documentação | |

| Ollama | Log Rastrear para todas as chamadas de Ollama LLM | Documentação | |

| Predibase | Tune fino e sirva modelos de idiomas grandes de código aberto | Documentação | |

| Ragas | Estrutura de avaliação para seus pipelines de geração aumentada (RAG) de recuperação (RAG) | Documentação | |

| Watsonx | Rastreios de log para todas as chamadas Watsonx LLM | Documentação |

Dica

Se a estrutura que você estiver usando não estiver listada acima, sinta -se à vontade para abrir um problema ou enviar um PR com a integração.

Se você não estiver usando nenhuma das estruturas acima, também poderá usar o decorador da função track para registrar traços:

import opik

opik . configure ( use_local = True ) # Run locally

@ opik . track

def my_llm_function ( user_question : str ) -> str :

# Your LLM code here

return "Hello" Dica

O decorador da faixa pode ser usado em conjunto com qualquer uma de nossas integrações e também pode ser usado para rastrear chamadas de funções aninhadas.

O Python Opik SDK inclui vários LLM como métricas de juiz para ajudá -lo a avaliar seu aplicativo LLM. Saiba mais sobre isso na documentação das métricas.

Para usá -los, basta importar a métrica relevante e usar a função score :

from opik . evaluation . metrics import Hallucination

metric = Hallucination ()

score = metric . score (

input = "What is the capital of France?" ,

output = "Paris" ,

context = [ "France is a country in Europe." ]

)

print ( score )O Opik também inclui várias métricas heurísticas pré-criadas, bem como a capacidade de criar a sua. Saiba mais sobre isso na documentação das métricas.

O OPIK permite avaliar seu aplicativo LLM durante o desenvolvimento por meio de conjuntos de dados e experimentos.

Você também pode executar avaliações como parte do seu pipeline CI/CD usando nossa integração de pytest.

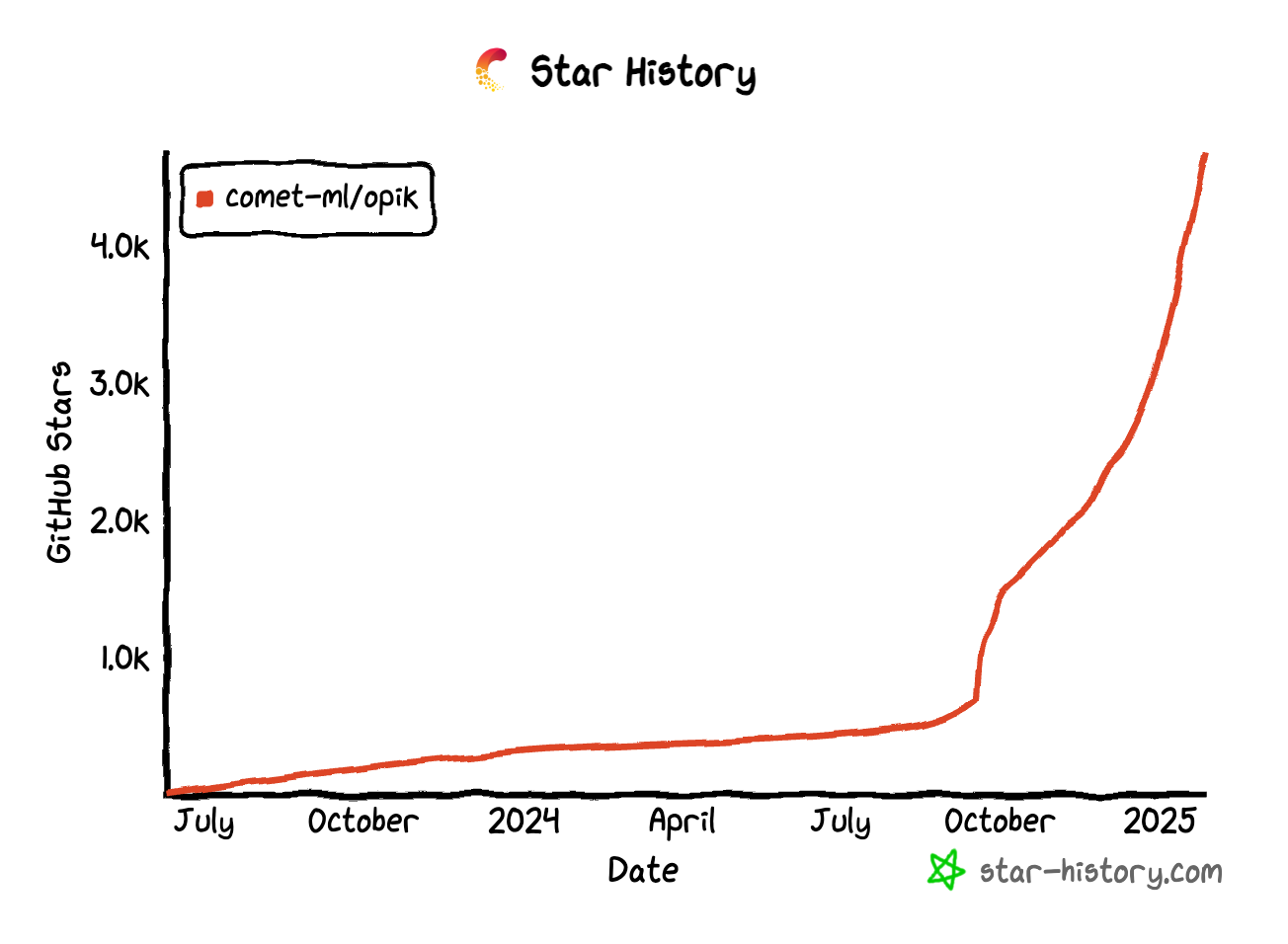

Se você achar o Opik útil, considere nos dar uma estrela! Seu apoio nos ajuda a aumentar nossa comunidade e continuar melhorando o produto.

Existem muitas maneiras de contribuir com o Opik:

Para saber mais sobre como contribuir com o OPIK, consulte nossas diretrizes contribuintes.