Desde chatbots de trapo hasta asistentes de código y tuberías de agente complejas y más allá, construir sistemas LLM que funcionan mejor, más rápido y más barato con el rastreo, las evaluaciones y los paneles.

Sitio web • Comunidad floja • Twitter • Documentación

OPIK es una plataforma de código abierto para evaluar, probar y monitorear aplicaciones LLM. Construido por Comet.

Puedes usar OPIK para:

Desarrollo:

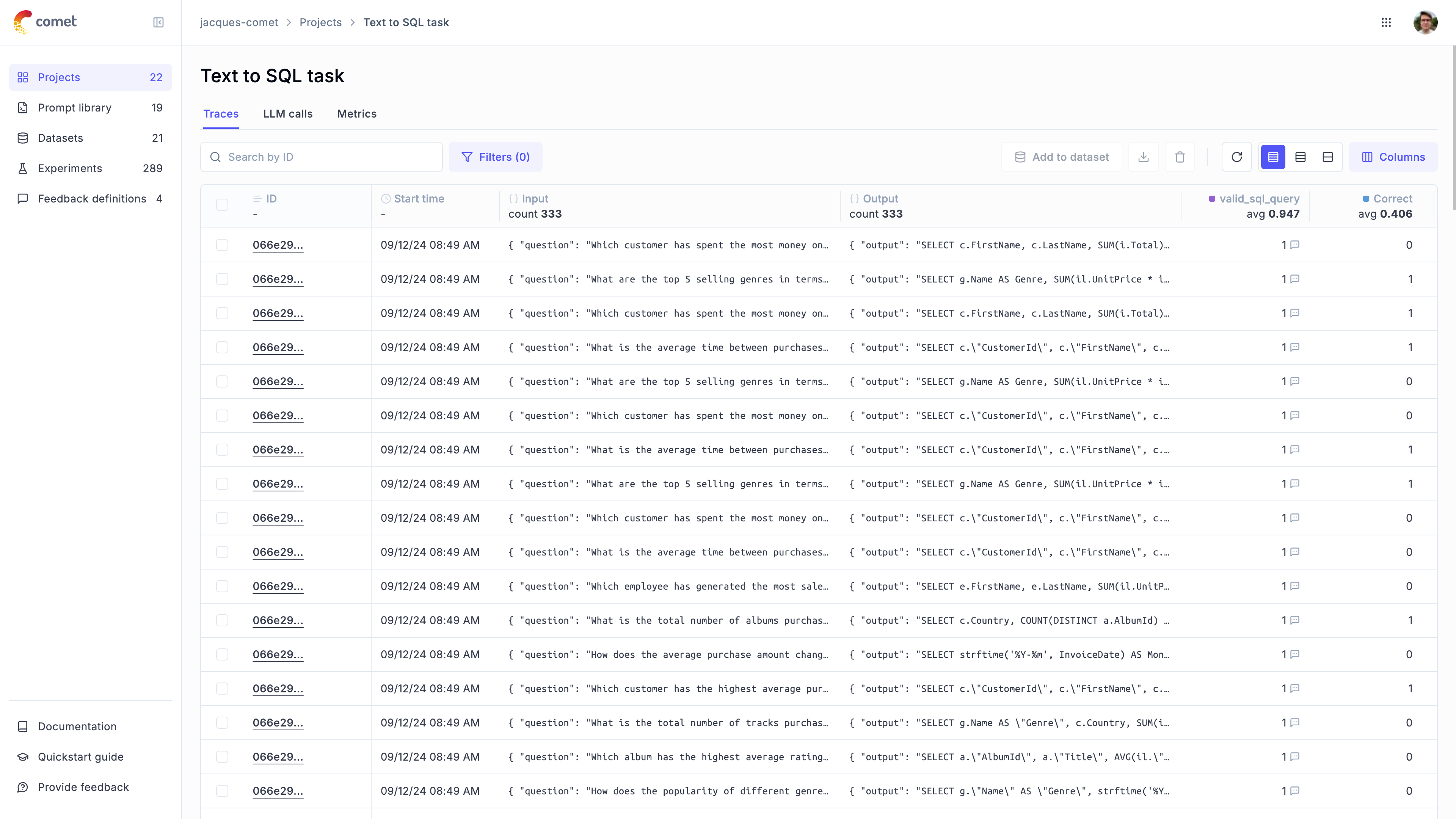

Tracing: rastree todas las llamadas y trazas de LLM durante el desarrollo y la producción (QuickStart, Integrations

Anotaciones: anoten sus llamadas LLM registrando puntajes de retroalimentación utilizando el SDK de Python o la UI.

Planeground :: Prueba diferentes indicaciones y modelos en el patio de recreo prolongado

Evaluación : automatizar el proceso de evaluación de su aplicación LLM:

Conjuntos de datos y experimentos : almacenar casos de prueba y ejecutar experimentos (conjuntos de datos, evaluar su aplicación LLM)

LLM como Juez Métricos : Use el LLM de Opik como métrica de juez para cuestiones complejas como detección de alucinación, moderación y evaluación de trapo (relevancia de respuesta, precisión del contexto

Integración de CI/CD : Ejecutar evaluaciones como parte de su tubería CI/CD utilizando nuestra integración Pytest

Monitoreo de producción :

Registre todos sus rastros de producción : OPIK ha sido diseñado para admitir altos volúmenes de trazas, lo que facilita el monitoreo de sus aplicaciones de producción. ¡Incluso pequeños despliegues pueden ingerir más de 40 millones de rastros por día!

Monitoreo de paneles : revise sus puntajes de retroalimentación, recuento de trazas y tokens con el tiempo en el tablero de Opik.

Métricas de evaluación en línea : obtenga fácilmente todas sus trazas de producción utilizando LLM como métricas de juez e identifique cualquier problema con su aplicación LLM de producción gracias a las métricas de evaluación en línea de OPIK

Consejo

Si está buscando características que Opik no tenga hoy, recaude una nueva solicitud de funciones

OPIK está disponible como una instalación local de código abierto o utilizando Comet.com como una solución alojada. La forma más fácil de comenzar con OPIK es crear una cuenta de cometa gratuita en comet.com.

Si desea que el OPIK de auto-anfitrión, puede hacerlo clonando el repositorio e iniciando la plataforma usando Docker Compose:

# Clone the Opik repository

git clone https://github.com/comet-ml/opik.git

# Navigate to the opik/deployment/docker-compose directory

cd opik/deployment/docker-compose

# Start the Opik platform

docker compose up --detach

# You can now visit http://localhost:5173 on your browser!Para obtener más información sobre las diferentes opciones de implementación, consulte nuestras guías de implementación:

| Métodos de instalación | Enlace de documentos |

|---|---|

| Instancia local | |

| Kubernetes |

Para comenzar, primero deberá instalar el SDK de Python:

pip install opik Una vez que se instala el SDK, puede configurarlo ejecutando el comando opik configure :

opik configureEsto le permitirá configurar OPIK localmente configurando la dirección del servidor local correcta o si está utilizando la plataforma en la nube configurando la tecla API

Consejo

También puede llamar al método opik.configure(use_local=True) desde su código Python para configurar el SDK para ejecutar en la instalación local.

Ahora está listo para comenzar a registrar rastros utilizando el Python SDK.

La forma más fácil de comenzar es usar una de nuestras integraciones. Opik apoya:

| Integración | Descripción | Documentación | Prueba en Colab |

|---|---|---|---|

| Opadai | Rastros de registro para todas las llamadas de OpenAI LLM | Documentación | |

| Litellm | Llame a cualquier modelo LLM utilizando el formato OpenAI | Documentación | |

| Langchain | Rastras de registro para todas las llamadas de Langchain LLM | Documentación | |

| Almiar | Rastras de registro para todas las llamadas de Haystack | Documentación | |

| Antrópico | Rastros de registro para todas las llamadas de LLM antrópicas | Documentación | |

| Base | Rastros de registro para todas las llamadas de Bedrock LLM | Documentación | |

| Crewai | Rastras de registro para todas las llamadas de Crewai | Documentación | |

| Veterano | Rastras de registro para todas las llamadas de Deepseek LLM | Documentación | |

| Dspy | Rastras de registro para todas las ejecuciones DSPY | Documentación | |

| Géminis | Rastras de registro para todas las llamadas de Gemini LLM | Documentación | |

| Hacer surgimiento | Rastras de registro para todas las llamadas Groq LLM | Documentación | |

| Barandas | Rastras de registro para todas las validaciones de barandas | Documentación | |

| Langgraph | Rastras de registro para todas las ejecuciones de Langgraph | Documentación | |

| Llamado | Rastras de registro para todas las llamadas de Llamaindex LLM | Documentación | |

| Ollama | Rastras de registro para todas las llamadas de Ollama LLM | Documentación | |

| Predibase | Tune y sirve modelos de lenguaje de código abierto | Documentación | |

| Ragas | Marco de evaluación para sus tuberías de generación aumentada de recuperación (RAG) | Documentación | |

| watsonx | Rastras de registro para todas las llamadas de Watsonx LLM | Documentación |

Consejo

Si el marco que está utilizando no se enumera anteriormente, no dude en abrir un problema o enviar un PR con la integración.

Si no está utilizando ninguno de los marcos anteriores, también puede usar el Decorador de funciones track para registrar las trazas:

import opik

opik . configure ( use_local = True ) # Run locally

@ opik . track

def my_llm_function ( user_question : str ) -> str :

# Your LLM code here

return "Hello" Consejo

El decorador de la pista se puede usar junto con cualquiera de nuestras integraciones y también se puede usar para rastrear las llamadas de funciones anidadas.

El Python Opik SDK incluye una serie de métricas de Juez como Juez para ayudarlo a evaluar su aplicación LLM. Obtenga más información al respecto en la documentación de métricas.

Para usarlos, simplemente importe la métrica relevante y use la función score :

from opik . evaluation . metrics import Hallucination

metric = Hallucination ()

score = metric . score (

input = "What is the capital of France?" ,

output = "Paris" ,

context = [ "France is a country in Europe." ]

)

print ( score )OPIK también incluye una serie de métricas heurísticas previas a la construcción, así como la capacidad de crear las suyas propias. Obtenga más información al respecto en la documentación de métricas.

OPIK le permite evaluar su aplicación LLM durante el desarrollo a través de conjuntos de datos y experimentos.

También puede ejecutar evaluaciones como parte de su tubería CI/CD utilizando nuestra integración Pytest.

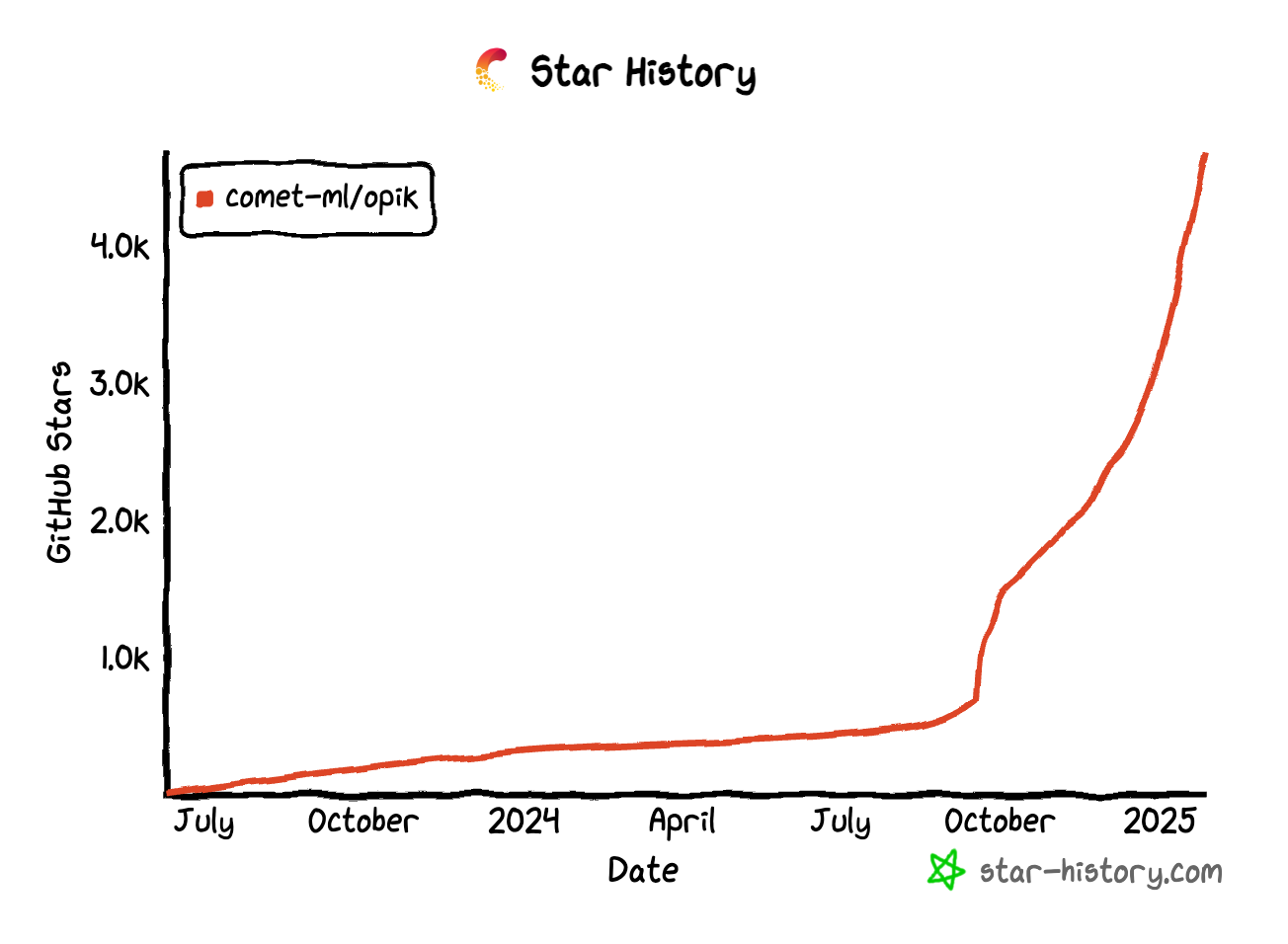

Si encuentra útil Opik, ¡considere darnos una estrella! Su apoyo nos ayuda a hacer crecer nuestra comunidad y continuar mejorando el producto.

Hay muchas formas de contribuir a OPIK:

Para obtener más información sobre cómo contribuir a OPIK, consulte nuestras pautas contribuyentes.