Des chatbots de chiffon aux assistants de code aux pipelines agentiques complexes et au-delà, construisez des systèmes LLM qui fonctionnent mieux, plus rapidement et moins cher avec le traçage, les évaluations et les tableaux de bord.

Site Web • Communauté Slack • Twitter • Documentation

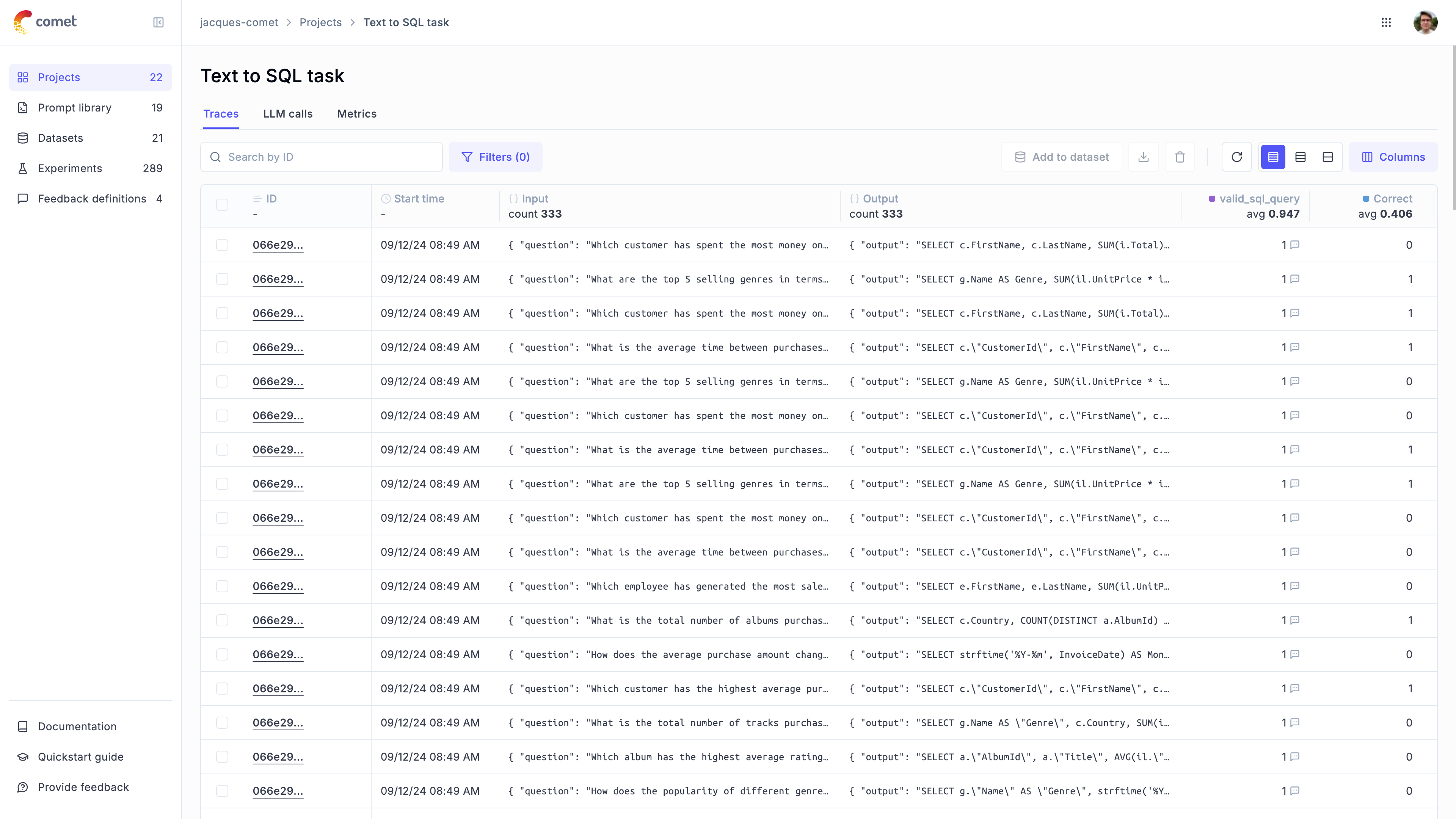

OPIK est une plate-forme open source pour évaluer, tester et surveiller les applications LLM. Construit par la comète.

Vous pouvez utiliser OPIK pour:

Développement:

Traçage: suivez tous les appels et traces LLM pendant le développement et la production (QuickStart, les intégrations

Annotations: annotez vos appels LLM en enregistrant les scores de rétroaction à l'aide du SDK Python ou de l'interface utilisateur.

Playground :: Essayez différentes invites et modèles dans le terrain de jeu rapide

Évaluation : automatiser le processus d'évaluation de votre application LLM:

Ensembles de données et expériences : stocker des cas de test et exécuter des expériences (ensembles de données, évaluer votre application LLM)

LLM en tant que juge Métriques : utilisez l'Opik's LLM comme métrique juge pour des questions complexes telles que la détection d'hallucination, la modération et l'évaluation des chiffons (Réponse, pertinence, précision du contexte

Intégration CI / CD : exécutez les évaluations dans le cadre de votre pipeline CI / CD à l'aide de notre intégration PyTest

Surveillance de la production :

Enregistrez toutes vos traces de production : OPIK a été conçu pour prendre en charge des volumes élevés de traces, ce qui facilite la surveillance de vos applications de production. Même les petits déploiements peuvent ingérer plus de 40 millions de traces par jour!

Surveillance des tableaux de bord : passez en revue vos scores de rétroaction, le nombre de traces et les jetons au fil du temps dans le tableau de bord OPIK.

Métriques d'évaluation en ligne : marquez facilement toutes vos traces de production en utilisant LLM comme métrique de juge et identifiez tout problème avec votre application de production LLM grâce aux mesures d'évaluation en ligne d'Opik

Conseil

Si vous recherchez des fonctionnalités qu'Opik n'a pas aujourd'hui, veuillez soulever une nouvelle demande de fonctionnalité

OPIK est disponible en tant qu'installation locale entièrement open source ou à l'aide de Comet.com comme solution hébergée. Le moyen le plus simple de commencer avec OPIK est de créer un compte COMET gratuit sur Comet.com.

Si vous souhaitez auto-héberger OPIK, vous pouvez le faire en clonage le référentiel et en démarrant la plate-forme à l'aide de Docker Compose:

# Clone the Opik repository

git clone https://github.com/comet-ml/opik.git

# Navigate to the opik/deployment/docker-compose directory

cd opik/deployment/docker-compose

# Start the Opik platform

docker compose up --detach

# You can now visit http://localhost:5173 on your browser!Pour plus d'informations sur les différentes options de déploiement, veuillez consulter nos guides de déploiement:

| Méthodes d'installation | Lien de docs |

|---|---|

| Instance locale | |

| Kubernetes |

Pour commencer, vous devrez d'abord installer le SDK Python:

pip install opik Une fois le SDK installé, vous pouvez le configurer en exécutant la commande opik configure :

opik configureCela vous permettra de configurer OPIK localement en définissant l'adresse du serveur local correct ou si vous utilisez la plate-forme cloud en définissant la touche API

Conseil

Vous pouvez également appeler la méthode opik.configure(use_local=True) de votre code Python pour configurer le SDK pour s'exécuter sur l'installation locale.

Vous êtes maintenant prêt à démarrer des traces de journalisation à l'aide du SDK Python.

La façon la plus simple de commencer est d'utiliser l'une de nos intégrations. Supports OPIK:

| Intégration | Description | Documentation | Essayez à Colab |

|---|---|---|---|

| Openai | Traces de journal pour tous les appels Openai LLM | Documentation | |

| Litrellm | Appelez n'importe quel modèle LLM en utilisant le format OpenAI | Documentation | |

| Lubriole | Traces de journal pour tous les appels Langchain LLM | Documentation | |

| Meule de foin | Traces de journal pour tous les appels de back de foin | Documentation | |

| Anthropique | Traces de journal pour tous les appels LLM anthropiques | Documentation | |

| Base | Traces de journal pour tous les appels LLM pour le fondement | Documentation | |

| Équipage | Traces de journal pour tous les appels de Crewai | Documentation | |

| En profondeur | Traces de journal pour tous les appels LLM Deepseek | Documentation | |

| Dspy | Traces de journal pour toutes les courses dspy | Documentation | |

| Gémeaux | Traces de journal pour tous les appels Gemini LLM | Documentation | |

| Grêle | Traces de journal pour tous les appels GROQ LLM | Documentation | |

| Garde-corps | Traces de journal pour toutes les validations de garde-corps | Documentation | |

| Languette | Traces de journal pour toutes les exécutions de Langgraph | Documentation | |

| Llamaindex | Traces de journal pour tous les appels Llamaindex LLM | Documentation | |

| Ollla | Traces de journal pour tous les appels Olllama LLM | Documentation | |

| Prédibase | Affiner et servir les modèles de grande langue open source | Documentation | |

| Ragas | Cadre d'évaluation pour vos pipelines de génération augmentée (RAG) de récupération | Documentation | |

| Watsonx | Traces de journal pour tous les appels Watsonx LLM | Documentation |

Conseil

Si le cadre que vous utilisez n'est pas répertorié ci-dessus, n'hésitez pas à ouvrir un problème ou à soumettre un RP avec l'intégration.

Si vous n'utilisez aucun des frameworks ci-dessus, vous pouvez également utiliser le décorateur de fonction track pour enregistrer les traces:

import opik

opik . configure ( use_local = True ) # Run locally

@ opik . track

def my_llm_function ( user_question : str ) -> str :

# Your LLM code here

return "Hello" Conseil

Le décorateur de piste peut être utilisé conjointement avec l'une de nos intégrations et peut également être utilisé pour suivre les appels de fonction imbriqués.

Le SDK Python OPIK comprend un certain nombre de mesures LLM en tant que juge pour vous aider à évaluer votre application LLM. En savoir plus à ce sujet dans la documentation des métriques.

Pour les utiliser, importez simplement la métrique pertinente et utilisez la fonction score :

from opik . evaluation . metrics import Hallucination

metric = Hallucination ()

score = metric . score (

input = "What is the capital of France?" ,

output = "Paris" ,

context = [ "France is a country in Europe." ]

)

print ( score )OPIK comprend également un certain nombre de mesures heuristiques prédéfinies ainsi que la possibilité de créer la vôtre. En savoir plus à ce sujet dans la documentation des métriques.

OPIK vous permet d'évaluer votre application LLM pendant le développement via des ensembles de données et des expériences.

Vous pouvez également exécuter des évaluations dans le cadre de votre pipeline CI / CD à l'aide de notre intégration PyTest.

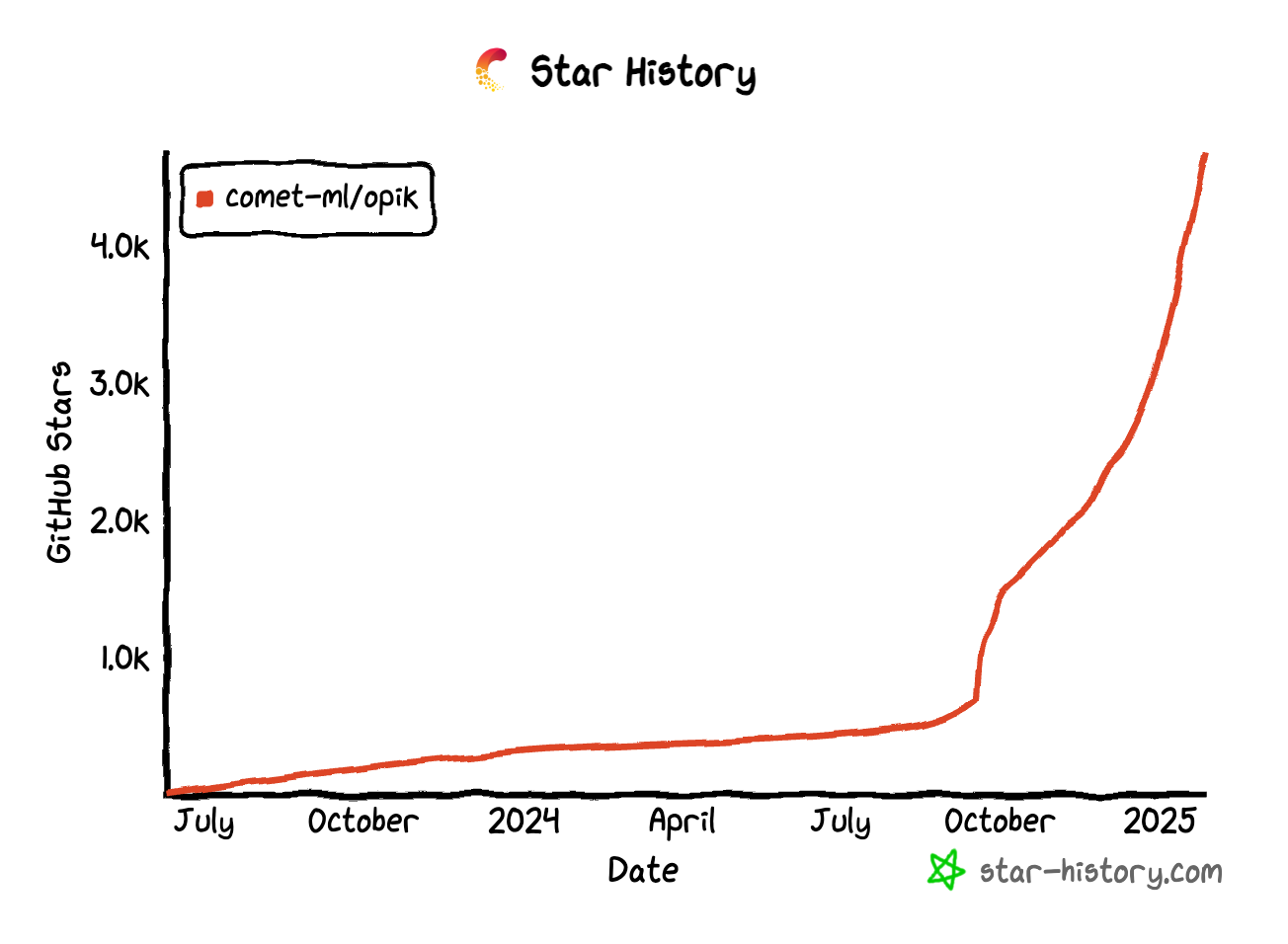

Si vous trouvez OPIK utile, envisagez de nous donner une étoile! Votre soutien nous aide à développer notre communauté et à continuer d'améliorer le produit.

Il existe de nombreuses façons de contribuer à OPIK:

Pour en savoir plus sur la façon de contribuer à OPIK, veuillez consulter nos directives contributives.