Erstellen Sie LLM -Systeme, die besser, schneller und billiger mit Verfolgung, Bewertungen und Dashboards sind.

Website • Slack Community • Twitter • Dokumentation

OPIK ist eine Open-Source-Plattform zur Bewertung, Testen und Überwachung von LLM-Anwendungen. Gebaut vom Kometen.

Sie können OPIK verwenden für:

Entwicklung:

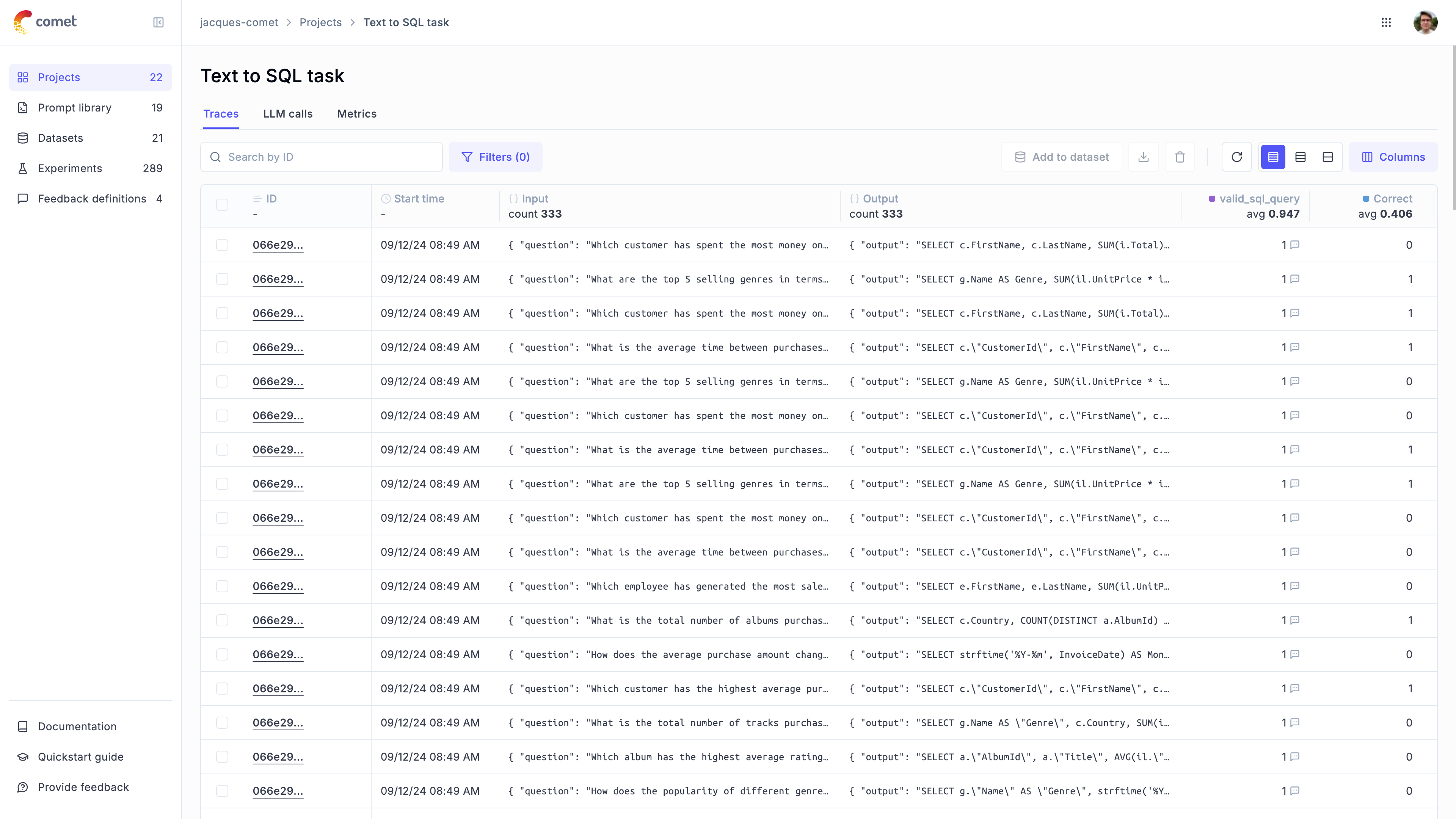

Verfolgung: Verfolgen Sie alle LLM -Anrufe und -verfolgung während der Entwicklung und Produktion (QuickStart, Integrationen

Anmerkungen: Annotieren Sie Ihre LLM -Anrufe, indem Sie Feedback -Bewertungen mithilfe des Python SDK oder der Benutzeroberfläche protokollieren.

Spielplatz :: Probieren Sie verschiedene Eingabeaufforderungen und Modelle auf dem schnellen Spielplatz aus

Bewertung : Automatisieren Sie den Bewertungsprozess Ihrer LLM -Anwendung:

Datensätze und Experimente : Testfälle speichern und Experimente ausführen (Datensätze, bewerten Sie Ihre LLM -Anwendung)

LLM als Richterkennzahlen : Verwenden Sie OPIKs LLM als Richtermetrik für komplexe Themen wie Halluzinationserkennung, Mäßigung und Lappenbewertung (Antwortrelevanz, Kontextgenauigkeit

CI/CD

Produktionsüberwachung :

Log alle Ihre Produktionsspuren : OPIK wurde entwickelt, um hohe Spuren von Spuren zu unterstützen, wodurch Sie Ihre Produktionsanwendungen leicht überwachen können. Selbst kleine Einsätze können mehr als 40 Millionen Spuren pro Tag einnehmen!

Überwachung der Dashboards : Überprüfen Sie Ihre Feedback -Bewertungen, die Zählung der Spuren und die Token im Laufe der Zeit im OPIK -Dashboard.

Online -Evaluierungsmetriken : Beachten Sie einfach alle Ihre Produktionsspuren mit LLM als Richterkennzahlen und identifizieren Sie alle Probleme mit Ihrer Produktions -LLM -Anwendung dank OPIKs Online -Bewertungsmetriken

Tipp

Wenn Sie nach Funktionen suchen, die Opik heute nicht hat, stellen Sie bitte eine neue Funktionsanfrage auf

OPIK ist als vollständig Open -Source -lokale Installation oder Comet.com als gehostete Lösung erhältlich. Der einfachste Weg, um mit OPIK zu beginnen, besteht darin, ein kostenloses Comet -Konto bei Comet.com zu erstellen.

Wenn Sie Opik selbst veranstalten möchten, können Sie dies tun, indem Sie das Repository klonen und die Plattform mithilfe von Docker Compose starten:

# Clone the Opik repository

git clone https://github.com/comet-ml/opik.git

# Navigate to the opik/deployment/docker-compose directory

cd opik/deployment/docker-compose

# Start the Opik platform

docker compose up --detach

# You can now visit http://localhost:5173 on your browser!Weitere Informationen zu den verschiedenen Bereitstellungsoptionen finden Sie in unseren Bereitstellungsleitfäden:

| Installationsmethoden | DOCS -Link |

|---|---|

| Lokale Instanz | |

| Kubernetes |

Um loszulegen, müssen Sie zuerst die Python SDK installieren:

pip install opik Sobald der SDK installiert ist, können Sie ihn konfigurieren, indem Sie den Befehl opik configure ausführen:

opik configureAuf diese Weise können Sie OPIK lokal konfigurieren, indem Sie die richtige lokale Serveradresse festlegen oder die Cloud -Plattform verwenden, indem Sie die API -Taste festlegen

Tipp

Sie können auch die Methode opik.configure(use_local=True) von Ihrem Python -Code aufrufen, um den SDK für die lokale Installation auszuführen.

Sie sind jetzt bereit, mit dem Python SDK Spuren zu protokollieren.

Der einfachste Weg, um zu beginnen, besteht darin, eine unserer Integrationen zu verwenden. Opik unterstützt:

| Integration | Beschreibung | Dokumentation | Versuchen Sie es in Colab |

|---|---|---|---|

| Openai | Protokollspuren für alle OpenAI -LLM -Anrufe | Dokumentation | |

| Litellm | Rufen Sie jedes LLM -Modell mit dem OpenAI -Format an | Dokumentation | |

| Langchain | Protokollspuren für alle Langchain -LLM -Anrufe | Dokumentation | |

| Heuhaufen | Protokollspuren für alle Heuheu -Anrufe | Dokumentation | |

| Anthropisch | Protokollspuren für alle anthropischen LLM -Anrufe | Dokumentation | |

| Grundgestein | Protokollspuren für alle Grundgestein -LLM -Anrufe | Dokumentation | |

| Crewai | Protokollspuren für alle Crewai -Anrufe | Dokumentation | |

| Deepseek | Protokollspuren für alle Deepseek LLM -Anrufe | Dokumentation | |

| DSPY | Protokollspuren für alle DSPY -Läufe | Dokumentation | |

| Zwillinge | Protokollspuren für alle Gemini LLM -Anrufe | Dokumentation | |

| Groq | Protokollspuren für alle COQ LLM -Anrufe | Dokumentation | |

| Leitplanken | Protokollspuren für alle Leitplanken Validierungen | Dokumentation | |

| Langgraph | Protokollspuren für alle Langgraph -Ausführungen | Dokumentation | |

| Llamaindex | Protokollspuren für alle Lamaindex LLM -Anrufe | Dokumentation | |

| Ollama | Protokollspuren für alle Ollama LLM -Anrufe | Dokumentation | |

| Predibase | Feinabstimmung und servieren Open-Source-Modelle mit großer Sprache | Dokumentation | |

| Ragas | Bewertungsrahmen für Ihre RAG -Pipelines (Abrufer Augmented Generation) | Dokumentation | |

| Watsonx | Protokollspuren für alle Watsonx LLM -Anrufe | Dokumentation |

Tipp

Wenn das von Ihnen verwendete Framework nicht oben aufgeführt ist, können Sie ein Problem mit der Integration ein Problem eröffnen oder eine PR einreichen.

Wenn Sie keine der oben genannten Frameworks verwenden, können Sie auch den track Function Decorator verwenden, um Spuren zu protokollieren:

import opik

opik . configure ( use_local = True ) # Run locally

@ opik . track

def my_llm_function ( user_question : str ) -> str :

# Your LLM code here

return "Hello" Tipp

Der Track Decorator kann in Verbindung mit einer unserer Integrationen verwendet werden und auch zur Verfolgung verschachtelter Funktionsanrufe verwendet werden.

Das Python Opik SDK enthält eine Reihe von LLM als Richterkennzahlen, mit denen Sie Ihren LLM -Antrag bewerten können. Erfahren Sie in der Dokumentation der Metriken mehr darüber.

Um sie zu verwenden, importieren Sie einfach die relevante Metrik und verwenden Sie die score :

from opik . evaluation . metrics import Hallucination

metric = Hallucination ()

score = metric . score (

input = "What is the capital of France?" ,

output = "Paris" ,

context = [ "France is a country in Europe." ]

)

print ( score )OPIK enthält auch eine Reihe vorgefertigter heuristischer Metriken sowie die Fähigkeit, Ihre eigenen zu erstellen. Erfahren Sie in der Dokumentation der Metriken mehr darüber.

Mit OPIK können Sie Ihre LLM -Anwendung während der Entwicklung durch Datensätze und Experimente bewerten.

Mit unserer PyTest -Integration können Sie auch Bewertungen als Teil Ihrer CI/CD -Pipeline ausführen.

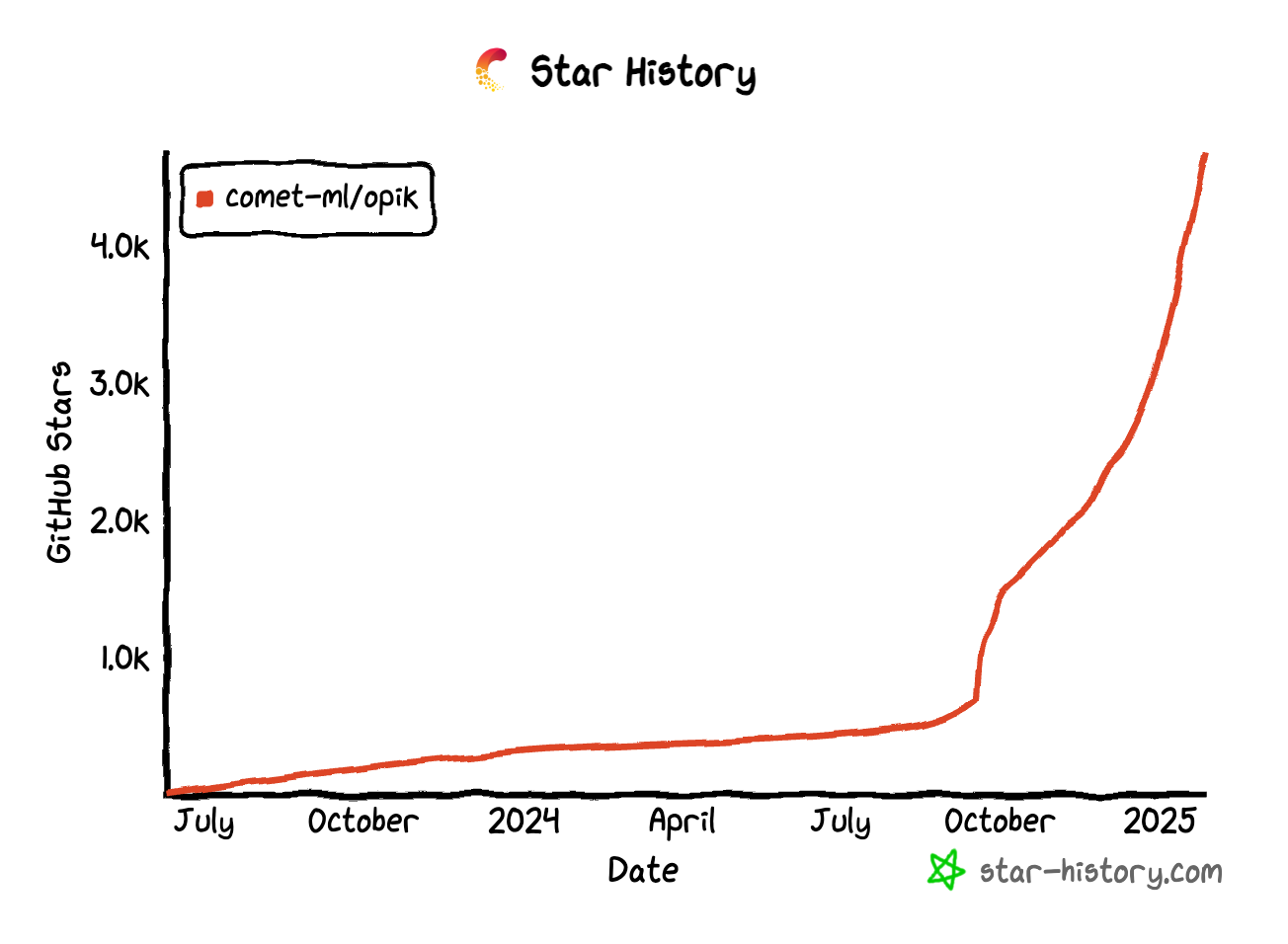

Wenn Sie Opik nützlich finden, sollten Sie uns einen Stern geben! Ihre Unterstützung hilft uns, unsere Community auszubauen und das Produkt weiter zu verbessern.

Es gibt viele Möglichkeiten, um Opik beizutragen:

Um mehr darüber zu erfahren, wie Sie zu OPIK beitragen können, finden Sie in unseren beitragenden Richtlinien.